O potencial de relevância e impacto inovador de transformadores [veja A Grande Transformação dos Transformadores, em bit.ly/3iou4aO e ChatGPT is everywhere. Here’s where it came from, em bit.ly/3JVTuIk] como chatGPT pode ser medido pela quantidade de especialistas, profissionais, pesquisadores e, de resto, membros do público em geral que se dedicaram, nas últimos semanas, a apontar problemas de todos os tipos da estrela dos sistemas generativos. Não sem razão, é bom que se diga.

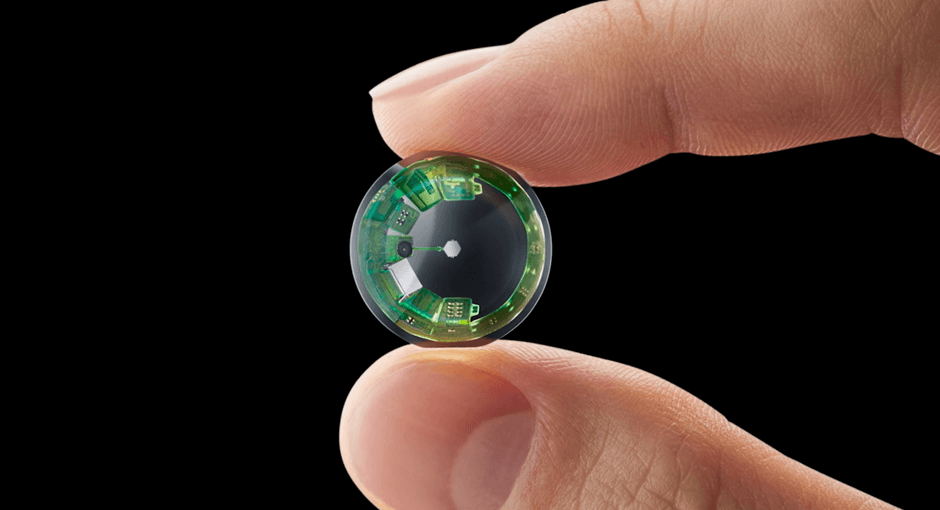

Pela primeira vez, uma aplicação de inteligência artificial consegue simular conversações com humanos usando não só regras de interação mas a partir de uma base de texto de 570 gigabytes -o equivalente a 385 milhões de páginas de texto em Word- desenvolver tópicos que variam de avanços na astrobiologia a receitas práticas de como fazer cerveja lager.

Já era de se esperar que o chatbot tivesse problemas de acurácia, fosse muito pouco criativo e tivesse zero de inteligência emocional. Até aí, nada de novo. Trata-se de um simulador, treinado com material existente na rede, e de uma forma muito particular.

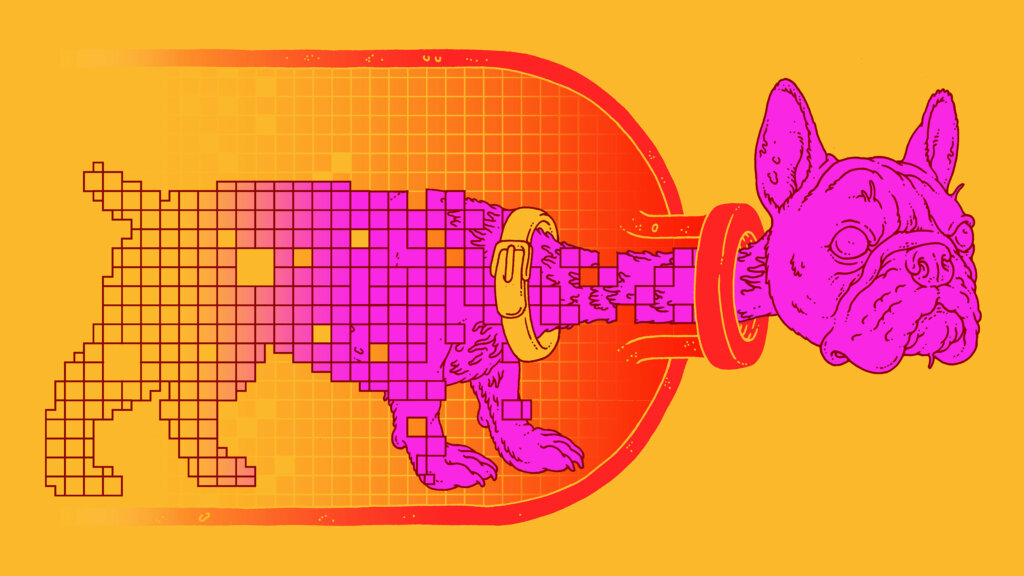

Uma metáfora para explicar como tal simulador é uma representação limitada da web está em ChatGPT Is a Blurry JPEG of the Web [bit.ly/3XnJ8Uq]: as máquinas [as de machine learning…] “aprendem” usando um processo de extração de características, equivalente a forçar a informação do universo de interesse [presente nos dados de treinamento, no caso de chatGPT parte da web] por um gargalo [veja New Theory Cracks Open the Black Box of Deep Learning, em bit.ly/3YkOgtZ] que comprime os dados [e o ruído que os acompanha] o máximo possível, preservando -até o limite definido no treinamento- a informação representada nos dados… usando um espaço muito menor do que a web.

Presto: um grande modelo linguístico [veja Inteligência Artificial e Grandes Algoritmos, em… bit.ly/3FJMKdS], como o que está por trás de chatGPT, é um compressor de informação; ainda mais, é um sistema que perde informação no processo. Uma coisa que chatGPT e similares não deverá ter são competências e habilidades que humanos têm, em muitos casos, naturalmente. Como a capacidade de se comunicar com outros humanos de forma sofisticada.

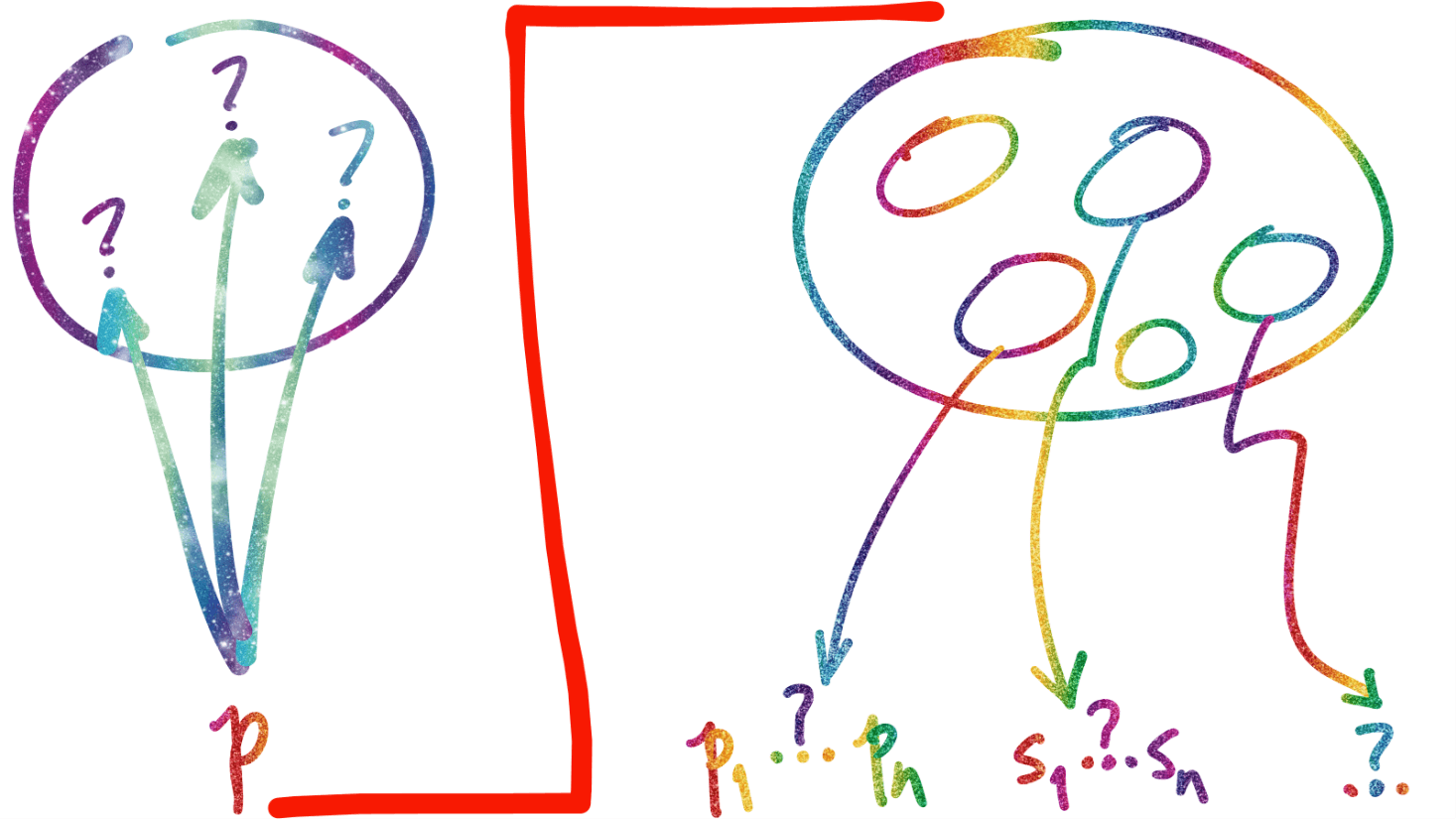

Mas… o que muda do ponto de vista do diálogo entre pessoas e sistemas de informação? Se o sistema é de busca, como Google, o papel dos humanos é só teclar palavras [desconexas] numa caixa virtual, e receber de volta uma lista de links… onde quase só a primeira página importa, do ponto de vista do comportamento de quem pergunta. Quase ninguém sabe que há uma forma de busca avançada e uma linguagem para tal. As empresas têm problemas diferentes, como entender o funcionamento do algoritmo de Google e suas mudanças, para não perder relevância nas respostas do buscador. Sabendo que o algoritmo pode mitigar tal relevância, sempre que for de interesse do modelo de negócios…

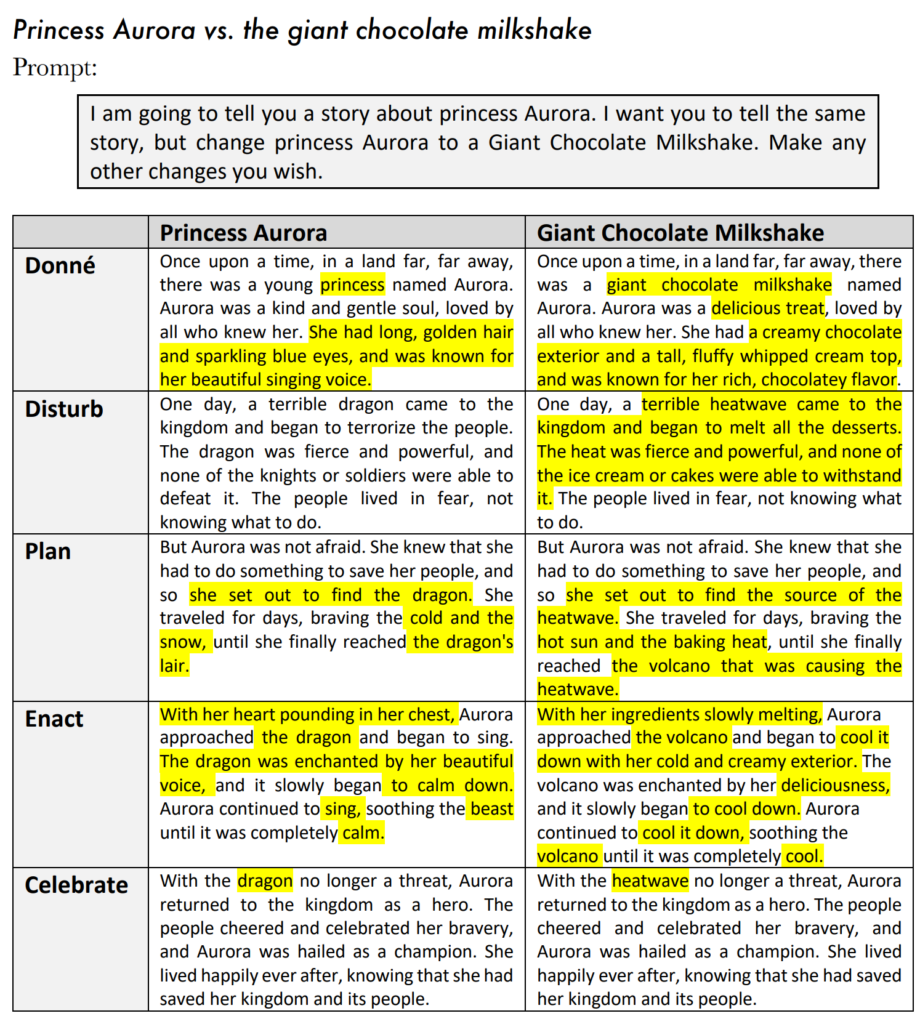

Se o sistema é chatGPT… e a informação foi comprimida… e houve perdas, a resposta do sistema deve ser gerada [daí a ‘generative AI’ era… cnn.it/3HSI3OY]… e a qualidade das respostas passa a depender, e muito mais, da sofisticação das perguntas [ChatGPT reminds us why good questions matter, bit.ly/3Xmzbqk]. O texto do link diz tudo: perguntas desempenham um papel fundamental em muitos aspectos de nossas vidas. As perguntas certas são críticas, por exemplo, para o processo científico, impulsionando a investigação e a exploração em uma ampla gama de tópicos e questões e moldando as políticas públicas.

O que nos leva diretamente a Einstein e sua frase sobre perguntas: se eu tivesse uma hora para resolver um problema e minha vida dependesse da solução, gastaria os primeiros 55 minutos tentando descobrir a pergunta certa a fazer.

Vale a pena observar que esta não é a norma dos negócios e da vasta maioria das pessoas. Quase sempre, ao enfrentar um problema que exige o desenho de uma estratégia para tratar o curto, médio e longo prazos, a tendência é começar a desenvolver a solução sem ter sequer identificado os cenários, personas e as hipóteses que correspondem às perguntas a fazer, os experimentos que verificam e validam as hipóteses, que encaminham a solução dos problemas. Ao sair fazendo de forma impensada, nada se resolve, quase tudo é tempo, recursos, oportunidades perdidas.

Mas a expressão genuinamente humana não é dar respostas do repertório público a perguntas já estabelecidas, que por sua vez representam problemas habituais. Na verdade, é criar novas perguntas, que representam novos problemas, que abrem espaço para criação de novas respostas, que na prática podem levar a melhor resolver problemas já solucionados de alguma forma. Estamos dando um salto cognitivo: de repente, jogar palavras numa caixa de perguntas trará, de volta, texto padrão que todo mundo irá receber. Articular diálogos que levem à construção de resultados discursivos potencialmente novos exige novas competências culturais e novas habilidades linguísticas e de comunicação.

Aí aparece um texto [What’s Wrong with ChatGPT?, bit.ly/3YAvTAU], de dois renomados economistas, a dizer que… o problema que chatGPT representa para os trabalhadores é óbvio: haverá menos empregos que exijam fortes habilidades de comunicação e, portanto, menos cargos que paguem bem.

Como assim?… Tal suposição está simplesmente errada.

Exatamente porque agora existe uma gama de sistemas que “conversa” [e “pinta” quadros… etc.] cujo funcionamento pode ser comparado -de brincadeira- a papagaios empoderados por grandes bancos de dados [On the Dangers of Stochastic Parrots, bit.ly/3XBHDm1] e regras de interação e composição… os negócios que quiserem se diferenciar precisam de mais pessoas com habilidades ainda mais fortes habilidades de escrita e comunicação e não menos gente com tais capacidades.

Até porque conduzir um diálogo significativo com um chatGPT não é uma tarefa fácil pra qualquer um… exige uma habilidade que não se ensina na escola, quase não se aprende no trabalho, quase sempre se trata com desprezo na sociedade, que é exatamente a de… fazer perguntas. Isso já deveria estar causando um choque que realidade na escola, que ainda nem entendeu como fazer busca em sistemas baseados em pagerank como Google. Lasca. Só aí, são 25 anos de atraso.

Mas o fato é que, com iLLMs [interactive Large Language Models] à solta, a barra de interação semântica subiu. Quem estava no nível de escrita de tirar 700+ na redação sintática do ENEM [para o que só é necessário cumprir um conjunto de regras elementares que, sim, podem ser usadas para treinar um iLLM…] acaba de descobrir que seu trabalho passou a depender de habilidades de comunicação muito mais fortes. Isso é uma grande oportunidade, pra quem entender o cenário e se preparar -rápido- pra ele. E um problema, pra quem não compreender e|ou não se preparar.

Aí, e como é quase sempre o caso em inovação de todos os tipos, haverá destruição e criação de trabalho, e não necessariamente quem teve seu trabalho destruído no processo conseguirá se colocar como candidato ao trabalho que será criado. Quem está no negócio de fazer texto pouco criativo, repetitivo, sim, terá problemas. Deveria ter começado a se preparar muito melhor há algum tempo e, ainda há tempo. Quem já tem a capacidade de fazer texto sofisticado quase certamente também terá -ou teria, em pouco tempo- a capacidade de usar um ou mais iLLMs a seu favor.

Mas há outros entendimentos para o mesmo cenário. Em ChatGPT intimates a tantalizing future… and it has broken the idea of thinking [bit.ly/3IhpXHT] a hipótese é de que… o comportamento de ChatGPT é sofisticado a ponto do conceito de pensamento ter se tornado inútil para distinguir entre o comportamento humano e o de um iLLM.

É uma possibilidade. Pode ser restrita a um fragmento do espaço tratado pela ferramenta. Mas pode ser suficiente para causar uma ruptura [radical] em partes relevantes do mercado de trabalho de quem concebe, escreve, edita, publica, critica e analisa textos genéricos. Ou específicos, de uma ou algumas áreas. E ainda estamos em 2023. Ainda nem começou.