Há um jeito confortável de conversar sobre algoritmos: como se fossem ferramentas neutras que, ocasionalmente, erram. Aí o remédio parece simples, corrigir o bug, ajustar o modelo, melhorar o dado, acrescentar uma “camada ética”. Só que a tese do Institute for the Future é mais incômoda e, por isso, mais útil:

o dano algorítmico não é um acidente do sistema, ele é parte do sistema, porque o sistema foi desenhado para maximizar lucro e externalizar prejuízos.

E a adoção desse tipo de decisão automatizada está correndo mais rápido do que a capacidade de responsabilização.

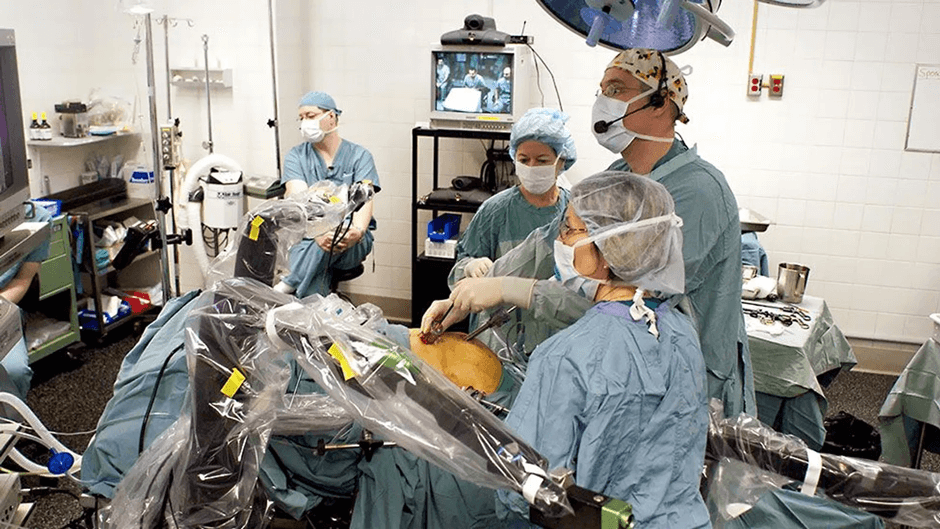

Um exemplo, quase banal pela repetição, é o do trabalho “plataformizado”. O motorista abre o aplicativo e descobre que foi desativado, sem explicação clara, sem devido processo, sem quakquer direito de defesa, sem nada… e de repente, sem renda. O problema não é apenas o resultado, é a assimetria completa entre quem decide e quem sofre a decisão. O algoritmo vira chefia, tribunal e sentença, e o trabalhador vira um número em uma interface.

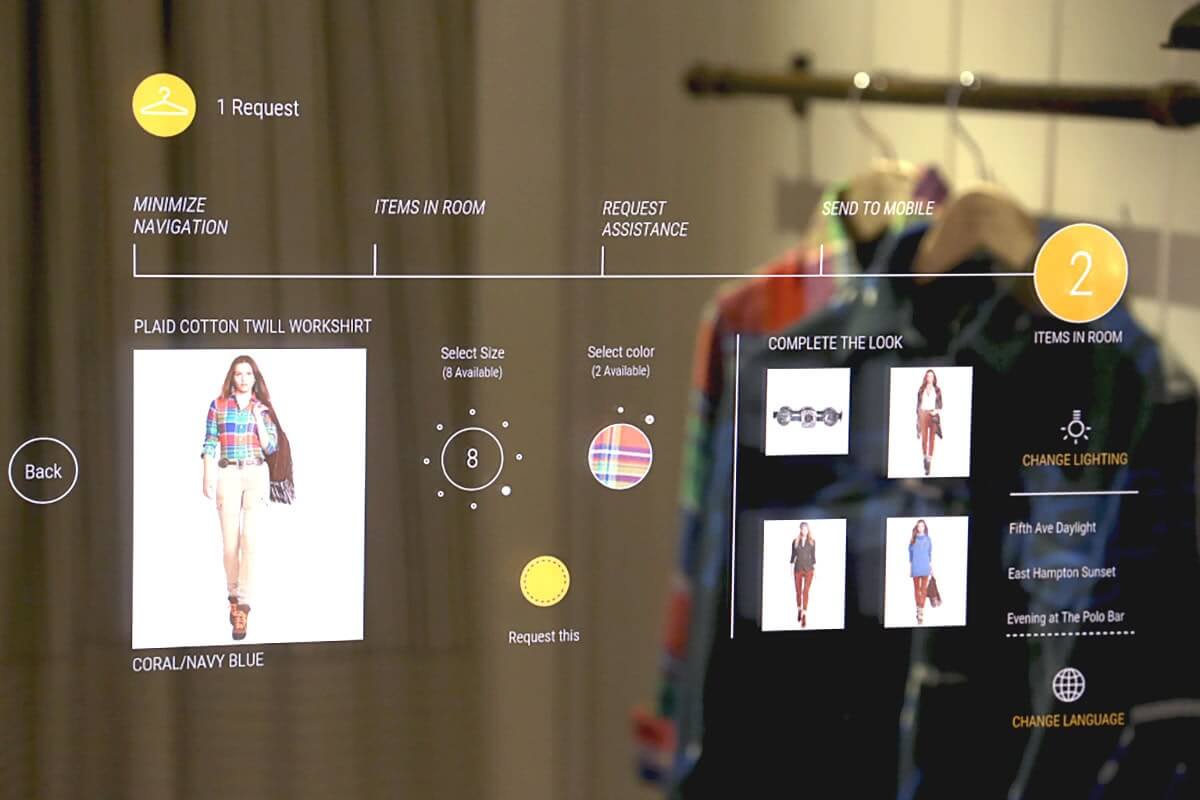

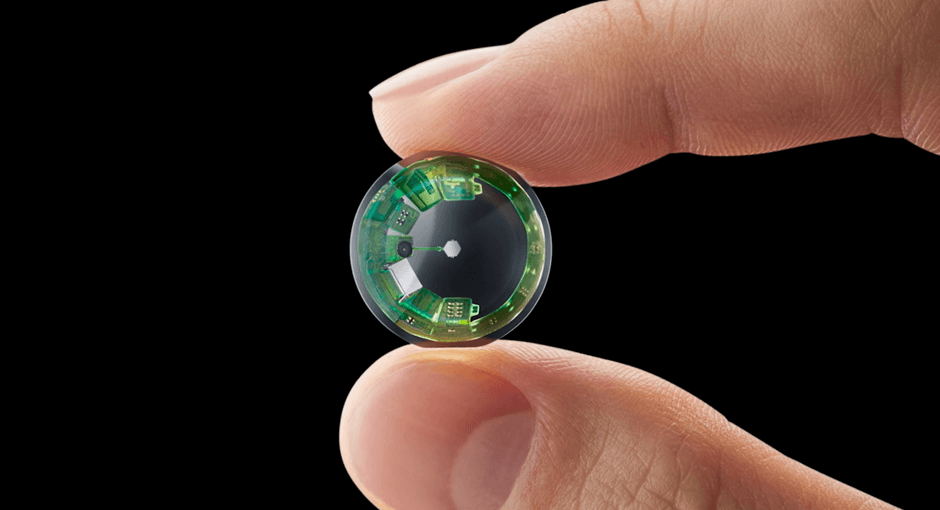

Até aqui, muita gente diria: “é o capitalismo de sempre, só que digital”. Entra então Yannis Varoufakis com um argumento que vale como lente, mesmo que você discorde do rótulo. Para ele, estamos migrando de um regime em que a riqueza vem principalmente de lucro para outro em que vem de renda, extraída por “feudos” digitais apoiados em “capital na nuvem”, isto é, infraestrutura, dados, software e, sobretudo, controle algorítmico do acesso a mercados e pessoas. O exemplo clássico é o pedágio de lojas de aplicativos e plataformas que retêm percentuais como se fossem renda da terra.

Se isso é “tecnofeudalismo” ou “capitalismo com esteróides” é um debate relevante, há críticas fortes à ideia de que seja um sistema novo.

Mas a dimensão adicional que Varoufakis ilumina ajuda muito a entender por que “dano algorítmico” tende a persistir:

quando o modelo de negócios é renda por controle, a opacidade não é um desvio, é um ativo.

Transparência vira risco competitivo. Explicabilidade vira risco jurídico. Reversibilidade vira risco operacional. Responsabilização vira risco financeiro.

O dano, quando bem distribuído para fora da firma, vira margem.

É aqui que a frase “não é bug, é modelo de negócios” ganha densidade política. Pense no que sustenta a economia da atenção:

sistemas que otimizam engajamento, retenção e rentabilidade publicitária, sem compromisso intrínseco com verdade, interesse público ou saúde democrática, porque essas variáveis não estão no objetivo, ou entram apenas como custo reputacional quando a crise explode.

O algoritmo não “erra” ao promover o extremo, ele aprende que o extremo prende. Não “falha” ao reduzir diversidade, ele aprende que repetição aumenta previsibilidade. Há evidências de dinâmicas de reforço rápidas em sistemas de recomendação, com queda gradual de diversidade em certos contextos de consumo de conteúdo.

O tecnofeudalismo, nessa leitura, não é só economia, é governança. O senhor feudal não precisava explicar por que fechou o caminho. Ele controlava o caminho. O equivalente moderno é o controle de fluxos, atenção, reputação, visibilidade, crédito, acesso a trabalho, acesso a serviços. E, quando a decisão é automatizada, ela ganha uma aura de inevitabilidade, como se fosse “a matemática” falando. Só que matemática, aqui, é política codificada.

Por isso, o centro do problema não é apenas “IA”. É decisão algorítmica, com IA ou sem IA.

Um score, uma regra, uma heurística, um ranking, um sistema de recomendação, um classificador, um modelo generativo que decide o que você vê e o que você não vê, tudo isso é infraestrutura de poder. Se a sociedade não criar contrapesos, o alcance destrutivo desses sistemas cresce como cresce qualquer monopólio: silenciosamente, até o dia em que já é tarde.

A boa notícia, se é que cabe uma, é que não estamos começando do zero. Há princípios intergovernamentais, como os da OCDE, que colocam transparência, explicabilidade e accountability como requisitos de “IA confiável”. Há instrumentos legais, como GDPR (artigo 22) e LGPD (artigo 20), que impõem salvaguardas para decisões automatizadas com efeitos significativos , incluindo o direito de não ser submetido a decisões “baseadas exclusivamente” em processamento automatizado e a existência de garantias.

Há legislações emergentes e propostas, como o Algorithmic Accountability Act de 2025 nos EUA, que (apesar do atual regime dos EUA) caminha na direção de exigir avaliações de impacto para sistemas de decisão automatizada em processos críticos. E há o EU AI Act (artigo 50), que consolida obrigações de transparência em diferentes camadas, ainda que a prática de fiscalização e o que será “suficientemente explicável” siga sendo disputa.

Só que princípios e leis, sozinhos, não vencem modelos de renda por controle.

E é por isso que a agenda tem de ser social, institucional e, sim, política: TERR (transparência, explicabilidade, reversibilidade e responsabilização) como exigência mínima para qualquer decisão algorítmica que afete gente de verdade.

Transparência. Quem decide, decide o quê, com quais dados, com quais objetivos e incentivos. Transparência não é abrir o código inteiro para o mundo, é revelar a estrutura de poder: finalidade, superfície de decisão, variáveis relevantes, categorias de dados, parceiros, e, principalmente, o desenho do incentivo econômico. Sem isso, o dano continua sendo “custo do outro”.

Explicabilidade. A pessoa afetada precisa de “informação significativa” sobre a lógica envolvida, em linguagem humana, para poder contestar, e para que a sociedade possa auditar padrões de discriminação e abuso. Explicar não é romantizar, é tornar discutível. A GDPR, por exemplo, coloca salvaguardas e abre espaço para intervenção humana e contestação em decisões automatizadas com impacto significativo.

Reversibilidade. Se um sistema erra, e ele vai errar, a decisão precisa ser reversível, com trilha de auditoria, canal de recurso, prazo, e autoridade capaz de mudar o resultado. “Fired by app” não é apenas crueldade, é desenho de operação. Reversibilidade é o antídoto do fatalismo algorítmico.

Responsabilização. Sem responsabilidade, transparência vira marketing e explicabilidade vira PDF. Responsabilização significa dever de cuidado, avaliação de impacto, auditorias independentes, penalidade real e, quando necessário, restrição ou proibição de uso em contextos de alto risco. É por isso que propostas de lei focam em avaliação de impactos e em processos críticos.

TERR não é um adorno “ético”.

É uma forma de colocar o poder algorítmico dentro do contrato social. Sem isso, o que chamamos hoje de “plataforma” vira, na prática, uma jurisdição privada.

E jurisdição privada tende a servir ao soberano, não ao cidadão.

Alguém pode perguntar: mas isso não atrasa inovação? Mas a pergunta correta é outra:

inovação para quem, com quais custos, pagos por quem, e com qual direito de contestação?

Quando o dano é parte do modelo de negócios, “inovar” pode significar, simplesmente, encontrar novas maneiras de minerar humanos, sua atenção, seu trabalho, seus dados, sua vulnerabilidade, e transformar isso em renda.

Se a sociedade não se articular, o tecnofeudalismo não chega como golpe.

Ele chega como termo de uso. E, quando você percebe, já está trabalhando no feudo, de graça, sem saber como foi julgado pelo senhorio algorítmico.

O caminho realista, portanto, é organizar demanda pública por TERR, traduzida em regulação, em fiscalização competente, em litigância estratégica, em pressão sobre compras governamentais, em sindicatos e associações que entendam sistemas, e em educação cívica para a era algorítmica.

É isso ou aceitar o futuro como produto de backlogs privados.

E, neste caso, “aceitar” não é neutralidade.

É submissão.

*************************

P.S.: O tema deste artigo está por trás de muitos dos argumentos, desafios, oportunidades e debates do livro A PRÓXIMA DEMOCRACIA. que escrevi com Rosário Pompeia, tratando dos sinais de colapso da democracia e da politica em um mundo de plataformas, e de princípios e teses para refundar a democracia no espaço figital.

Sim. Refundar.

A democracia que foi pensada para os sécuclos XVIII, XIX e XX não tem a menor chance de subsistir, melhorada, no mundo figital. Precisamos ter a coragem, foco e determinação para refundar a política e a democracia… ou descambar para o mais abjeto autoritarismo.

O site do livro é aproximademocracia.com.br e ele por ser adquirido neste link.