Plataformas como Facebook, Twitter e YouTube se tornaram uma parte central do discurso público e da vida democrática. Elas criam novos espaços para participação política, debate público e acesso à informação.

As mesmas plataformas, e seu uso, também levantam preocupações significativas sobre privacidade, desinformação, discurso de ódio, interferência eleitoral e concentração de poder. A natureza transnacional e sem precedentes dessas plataformas representa um desafio para as estruturas regulatórias existentes, principalmente focadas em meios de comunicação tradicionais e delimitadas por fronteiras nacionais.

Há uma necessidade clara de novas abordagens de governança que protejam direitos fundamentais, garantam eleições justas, promovam um discurso democrático saudável e incentivem mercados digitais competitivos e inovadores. As 10 recomendações a seguir representam um potencial caminho a seguir.

- Estabelecer conselhos de mídia social com participação de múltiplos atores, incluindo plataformas, sociedade civil e governos, para desenvolver e supervisionar padrões de moderação de conteúdo com base nos direitos humanos internacionais.

Os conselhos de mídia social seriam instituições para reunir regularmente plataformas e sociedade civil, potencialmente com supervisão governamental, para abordar desafios de moderação de conteúdo (Tworek, 2019). Eles incluiriam representantes de grupos marginalizados e organizações da sociedade civil para garantir que as soluções incorporem as experiências daqueles frequentemente mais afetados pelas decisões de moderação de conteúdo.

O Relator Especial da ONU sobre Liberdade de Opinião e Expressão recomendou um órgão desse tipo para lidar com a moderação de conteúdo online (UN Special Rapporteur, 2018). Esses conselhos poderiam estabelecer princípios gerais, enquanto as plataformas definiriam os detalhes da implementação. Princípios de orientação poderiam incluir padrões de direitos humanos internacionais, como os estabelecidos no Artigo 19 do Pacto Internacional sobre Direitos Civis e Políticos (UN General Assembly, 1966).

- Criar sistemas de corregulação, em que as plataformas desenvolvem mecanismos para regular seus usuários, que por sua vez devem ser aprovados por legisladores ou reguladores estatais democraticamente legítimos.

A corregulação envolve plataformas desenvolvendo seus próprios mecanismos para regular usuários, que então devem ser aprovados por reguladores ou legisladores estatais e monitorados quanto à eficácia (Marsden et al., 2020). Ela fornece a base legal e legitimidade da aprovação parlamentar para sistemas regulatórios, junto com princípios gerais de boa regulação, como independência, processos de apelação e auditoria.

Um estatuto estabeleceria os princípios gerais aplicáveis a um regulador de IA, enquanto o regulador definiria os detalhes do esquema. Princípios poderiam incluir que nenhuma conta pode ser suspensa sem intervenção humana e potencial para recurso do titular da conta, um requisito mínimo para manter a liberdade de expressão.

A corregulação já é aplicada em algumas áreas, como no esquema Pan European Game Information (PEGI) para classificação de jogos eletrônicos na Europa (Marsden, 2011). Estruturas semelhantes poderiam ser aplicadas às plataformas de mídia social.

- Exigir maior transparência das plataformas sobre seus algoritmos, decisões de moderação de conteúdo e apelos de usuários.

Plataformas como Facebook, YouTube e Twitter atualmente têm pouca transparência sobre como moderam conteúdo e contas de usuários. Seus processos internos são frequentemente opacos e suas regras podem ser aplicadas arbitrariamente, com pouco devido processo para os usuários (Gorwa, 2019).

Os conselhos de mídia social propostos poderiam exigir que as plataformas divulguem mais informações sobre seus algoritmos e decisões de moderação de conteúdo. Isso poderia incluir notificações e explicações quando o conteúdo é removido, bem como dados sobre taxas de remoção, apelos e suas resoluções.

O Relator Especial da ONU argumentou que para proteger a liberdade de expressão, as empresas devem estabelecer procedimentos de devida diligência, transparência, responsabilidade e reparação (UN Special Rapporteur, 2018). Maior transparência também permitiria melhor monitoramento e responsabilização pública.

Os “Princípios de Santa Clara” para moderação de conteúdo, desenvolvidos por acadêmicos e ativistas, também pedem números agregados sobre remoções de conteúdo, notificação aos usuários e um robusto processo de apelação (Santa Clara Principles, 2018). Incorporá-los em um código de conduta ou estrutura regulatória poderia melhorar muito a transparência.

- Garantir supervisão humana sobre sistemas de inteligência artificial usados para moderar conteúdo, com possibilidade de recurso.

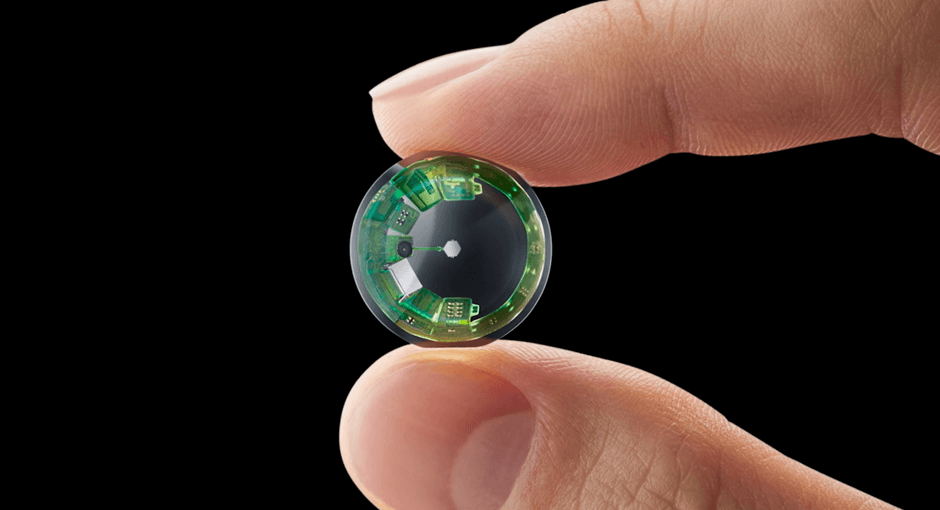

Sistemas baseados em IA são cada vez mais usados para detectar e moderar conteúdo problemático em larga escala. No entanto, eles têm limitações significativas em termos de precisão e compreensão contextual (Gorwa et al., 2020). Remover conteúdo automaticamente sem revisão humana pode levar à censura excessiva.

Qualquer uso de IA para moderação deve ser supervisionado por revisores humanos treinados que podem interpretar nuances contextuais e culturais (Tworek, 2019). Processos claros de recurso também devem existir para que os usuários possam contestar remoções incorretas.

A legislação pode exigir salvaguardas contra decisões totalmente automatizadas. O Regulamento Geral de Proteção de Dados da UE já dá aos titulares de dados o direito de contestar decisões baseadas unicamente em processos automatizados (Regulation (EU) 2016/679, 2016). Disposições semelhantes poderiam ser aplicadas à moderação de conteúdo.

- Desenvolver padrões globais para a governança de dados e plataformas digitais, harmonizando diferentes abordagens nacionais.

Atualmente, a regulamentação das plataformas digitais é fragmentada, com diferentes países adotando diferentes abordagens baseadas em seus valores e prioridades locais. No entanto, como as principais plataformas operam globalmente, uma abordagem mais coordenada internacionalmente deveria ser o caso, e pode ser benéfica.

Em 2023, o Parlamento Europeu, o Conselho e a Comissão proclamaram a Declaração Europeia sobre os Direitos e Princípios Digitais para a Década Digital (Council of Europe 2023). Essa declaração visa assegurar que a transformação digital respeite os valores fundamentais da União Europeia (UE) e os direitos dos cidadãos. Ela aborda questões como soberania digital, respeito pelos direitos fundamentais, Estado de direito, inclusão, igualdade, sustentabilidade e segurança. Essa declaração é um marco importante para a governança democrática das plataformas digitais na UE.

Ainda em 2023, a OCDE divulgou uma “atualização dirigida” das Diretrizes da OCDE para Empresas Multinacionais sobre Conduta Empresarial Responsável (OCDE 2023). Essas diretrizes envolveram negociações entre os países membros e abordam questões relacionadas à responsabilidade das empresas multinacionais no contexto digital. Embora não sejam exclusivamente voltadas para plataformas digitais, as diretrizes têm implicações significativas para a governança das plataformas.

No entanto, ainda há espaço para maior colaboração internacional, talvez através de um Conselho de Estabilidade Digital, modelado no Conselho de Estabilidade Financeira (que trabalha para fortalecer os sistemas financeiros e aumentar a estabilidade dos mercados financeiros internacionais), para coordenar e harmonizar os esforços regulatórios digitais (Fay, 2019). Princípios comuns relacionados à transparência, responsabilidade e direitos humanos poderiam orientar abordagens nacionais divergentes.

- Exigir que as plataformas contribuam financeiramente para um fundo global de mídia aberta, pública para apoiar o jornalismo investigativo.

As plataformas digitais causaram uma grande ruptura nos modelos de negócios tradicionais da mídia e capturaram grande parte da receita publicitária que antes financiava o jornalismo. Isso levou a demissões, fechamentos e escassez de jornalismo local e investigativo (Pickard, 2020). Essa falta de jornalismo de qualidade, por sua vez, permitiu que a desinformação proliferasse online, aumentou o autoritarismo local e global e a corrupção (UNODC 2020).

Pickard (2020) propõe que as plataformas sejam obrigadas a pagar um pequeno imposto sobre suas receitas de publicidade para financiar um fundo internacional de jornalismo público. Isso poderia subsidiar reportagens investigativas e colocar mais jornalistas profissionais para atuar como ‘cães de guarda’ da desinformação.

Taxas sobre gigantes da tecnologia para apoiar a mídia já foram implementadas ou propostas em países como França, Reino Unido e Austrália (Kaye, 2019). Expandir isso para um mecanismo global mais robusto poderia fornecer uma fonte sustentável de financiamento para uma mídia forte e independente como um bem público.

- Aplicar às plataformas online regras eleitorais existentes sobre transparência de publicidade política e limites a doações estrangeiras.

Plataformas como Facebook e Google se tornaram importantes para publicidade política, mas geralmente não estão sujeitas às mesmas regras que a mídia tradicional. Isso levou a preocupações sobre interferência estrangeira, financiamento obscuro e disseminação de desinformação (Gorwa, 2019).

Leis eleitorais sobre transparência de gastos e limites a contribuições estrangeiras poderiam ser estendidas às plataformas digitais. O Canadá e a Irlanda recentemente implementaram tais regras, exigindo que plataformas mantenham registros públicos de anúncios políticos e proíbam anúncios políticos estrangeiros durante os períodos eleitorais (Marsden et al., 2020).

Requisitos mais rigorosos de “conhecer seu cliente” para compradores de anúncios políticos, rótulos claros para anúncios políticos e bancos de dados pesquisáveis de todos os anúncios também poderiam melhorar a transparência e a prestação de contas (Tworek, 2019). As plataformas também podem ser proibidas de direcionar publicidade política usando dados pessoais, prática que permite um certo ‘microdirecionamento’ de mensagens divisivas para públicos pequenos e específicos.

- Reformar as leis antitruste e de concorrência para lidar com o poder de mercado das grandes plataformas digitais.

Algumas empresas de plataforma como Google e Facebook alcançaram um poder de mercado substancial, e monopolista em muitos países, levantando preocupações sobre concorrência e inovação. Suas vantagens de dados, efeitos de rede e economias de escala tornam difícil para os concorrentes prosperarem -e mesmo exitirem (Kimmelman, 2020).

Autoridades antitruste estão começando a examinar os mercados digitais, mas muitos argumentam que novas ferramentas e estruturas são necessárias. Leis de concorrência tradicionais se concentram nos efeitos de preços para os consumidores, mas grande parte dos serviços de plataformas é gratuita, com danos potenciais assumindo outras formas, como degradação da privacidade (Kimmelman, 2020).

Reformas propostas incluem regras mais rígidas contra ‘amarrar’ produtos, proibições de plataformas favorecendo seus próprios serviços, portabilidade de dados aprimorada para reduzir os efeitos de aprisionamento, potencialmente separar algumas empresas (Kimmelman, 2020; Fay, 2019). Regras de concorrência reformadas poderiam ajudar a nivelar o campo de jogo e reduzir a influência das grandes plataformas sobre o discurso público.

Na Europa, as regras especificadas no par de regulações DMA e DSA dizem respeito principalmente aos intermediários e plataformas online, como marketplaces, redes sociais, plataformas de compartilhamento de conteúdos, apps stores e plataformas online de viagens e hospedagem e são um bom ponto de partida para o resto do mundo estudar alternativas de regulaçãod e grandes plataformas (European Comission 2024).

- Aumentar a alfabetização midiática dos cidadãos e apoiar o jornalismo de qualidade para combater a desinformação.

Mesmo com uma melhor regulamentação das plataformas, alguma (bem, quase certamente, muita…) desinformação provavelmente continuará circulando online. Equipar os cidadãos com as habilidades para navegar criticamente na mídia digital e identificar informação confiável é, portanto, essencial.

Iniciativas de alfabetização midiática podem ensinar as pessoas a verificar as fontes, reconhecer indicadores de notícias falsas e entender como os algoritmos das plataformas podem moldar o que elas veem (Tworek, 2019). Essas habilidades poderiam ser integradas nos currículos escolares e campanhas públicas de educação.

O apoio a um jornalismo robusto e ético também é vital como um contrapeso à desinformação. Além de apoiar diretamente os meios de comunicação públicos, os governos também podem oferecer incentivos fiscais e subsídios para apoiar o jornalismo local e investigativo (Pickard, 2020).

- Continuar a pesquisa e análise dos impactos das plataformas digitais na democracia para embasar respostas políticas baseadas em evidências.

O cenário digital está evoluindo rapidamente e ainda há muito que não sabemos sobre como exatamente as plataformas estão remodelando o discurso público e os processos democráticos. Investimentos contínuos em pesquisas interdisciplinares nesta área são essenciais.

As plataformas devem facilitar o acesso dos pesquisadores a dados-chave, respeitando a privacidade dos usuários. APIs transparentes, processos de revisão ética e ambientes seguros para pesquisas podem ajudar os estudiosos a analisar padrões de desinformação, alcance de anúncios políticos, efeitos de algoritmos e mais (Tworek, 2019).

Órgãos consultivos independentes, como o proposto Comitê de Supervisão do Facebook, também podem desempenhar um papel na síntese de evidências e fornecimento de orientações especializadas (Tworek, 2019). Seus esforços devem complementar, e não substituir, processos democráticos.

À medida que desenvolvemos respostas políticas, devemos ter o cuidado de avaliar continuamente as evidências sobre seus impactos – pretendidos e não pretendidos. Apenas por meio de pesquisas e análises robustas, podemos desenvolver estruturas de governança que efetivamente alinhem as plataformas com o interesse público.

* * * * * *

As 10 recomendações descritas acima abordam muitos dos desafios centrais colocados pelas plataformas digitais para a governança democrática. Elas envolvem uma combinação de novas estruturas regulatórias (como conselhos de mídia social e corregulação), reformas de regimes legais existentes (como leis eleitorais e antitruste), e investimentos complementares em alfabetização midiática e jornalismo de alta qualidade. Em conjunto, elas apontam para uma abordagem de governança multifacetada e em várias camadas que procura alinhar os incentivos das plataformas com o interesse público, protegendo direitos fundamentais, e capacitar cidadãos.

No entanto, é importante reconhecer que não existe uma solução única para um problema tão complexo e em rápida evolução. Estas recomendações representam um ponto de partida, não um plano abrangente. Sua implementação exigirá uma experimentação política cuidadosa, adaptada aos contextos locais, e uma reavaliação e ajuste contínuos com base em evidências. Também exigirá uma coordenação sustentada entre governos, empresas, sociedade civil e cidadãos.

Talvez o mais importante, como a recomendação final enfatiza, precisaremos de pesquisa e análise contínuas para entender mais profundamente os impactos das plataformas digitais em nossas sociedades e continuamente atualizar nossas respostas. Com o engajamento sustentado de todas as partes interessadas, e sendo orientados por valores democráticos, estas recomendações podem ajudar a construir um panorama digital que capacite e alimente uma esfera pública vibrante e inclusiva. Está é, sem dúvida, uma das tarefas definidoras do nosso tempo.

Apêndice

- Um modelo “multilema” de governança de plataformas que envolva múltiplos atores em diferentes níveis para navegar as complexidades da regulação de conteúdo.

Como já vimos, a ascensão das plataformas de redes sociais evolucionou a esfera pública, criando novos espaços para expressão, acesso à informação e engajamento cívico em uma escala sem precedentes. No entanto, as plataformas também se tornaram terreno fértil para a propagação de desinformação, discurso de ódio, assédio e interferência eleitoral estrangeira. Essas ameaças apresentam desafios radicais para as sociedades democráticas, minando a capacidade dos cidadãos de se envolver em deliberações informadas e corroendo a confiança nas instituições democráticas.

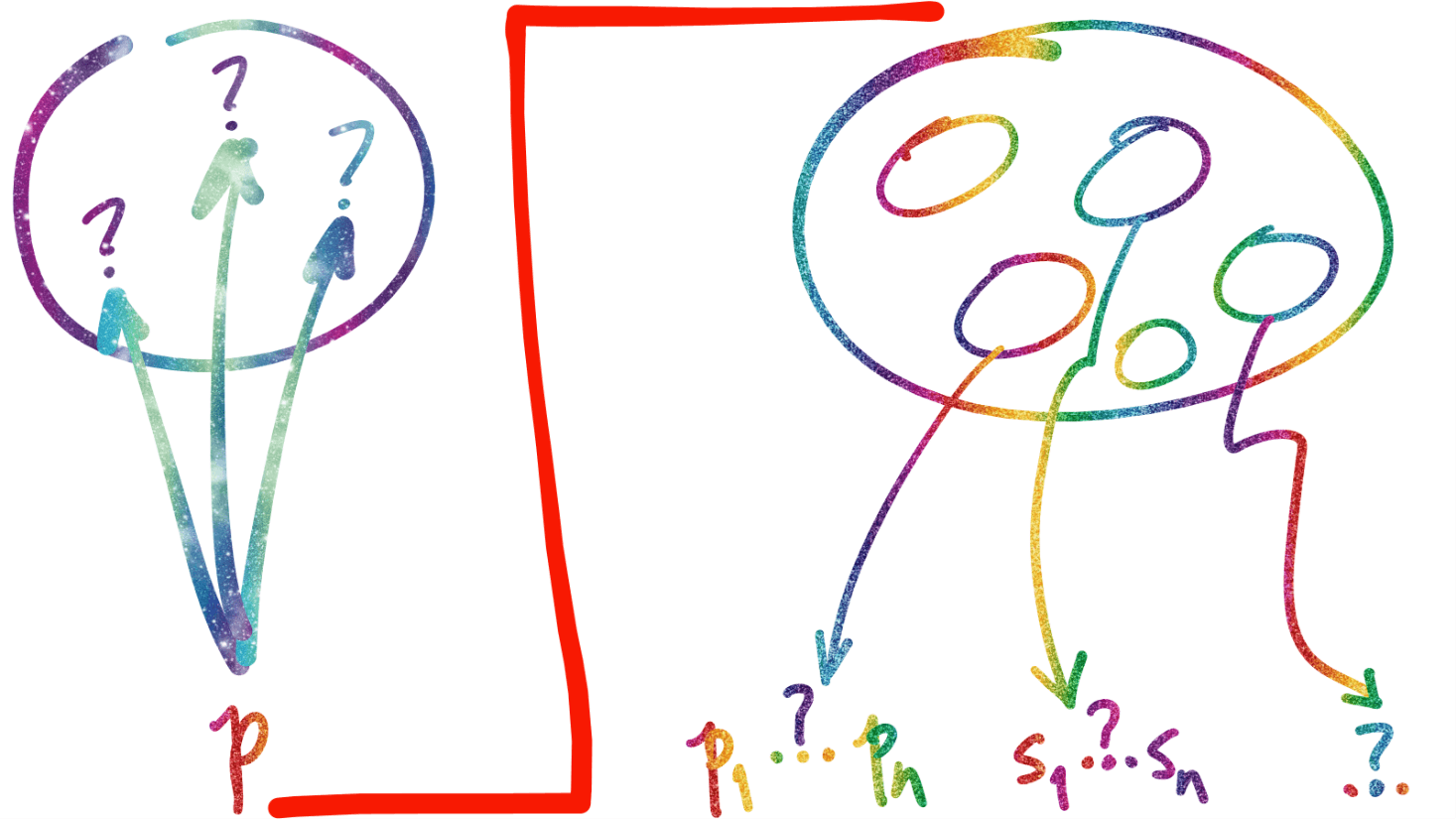

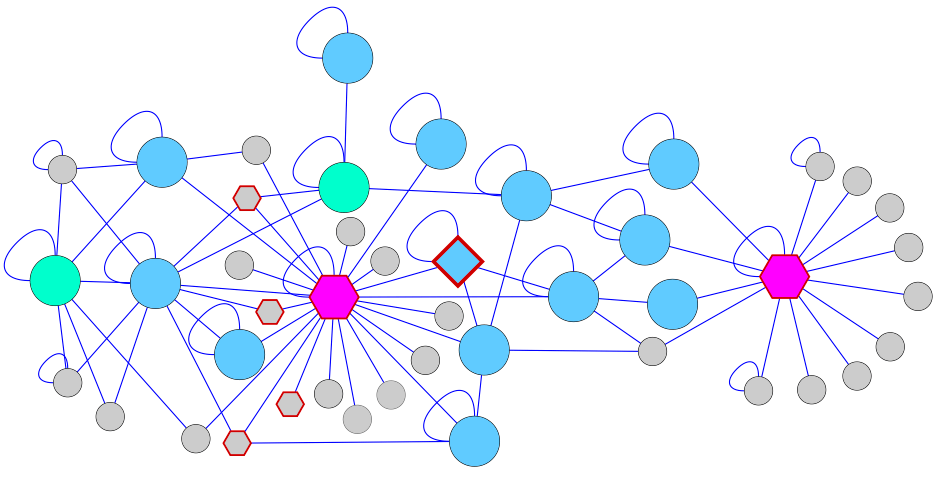

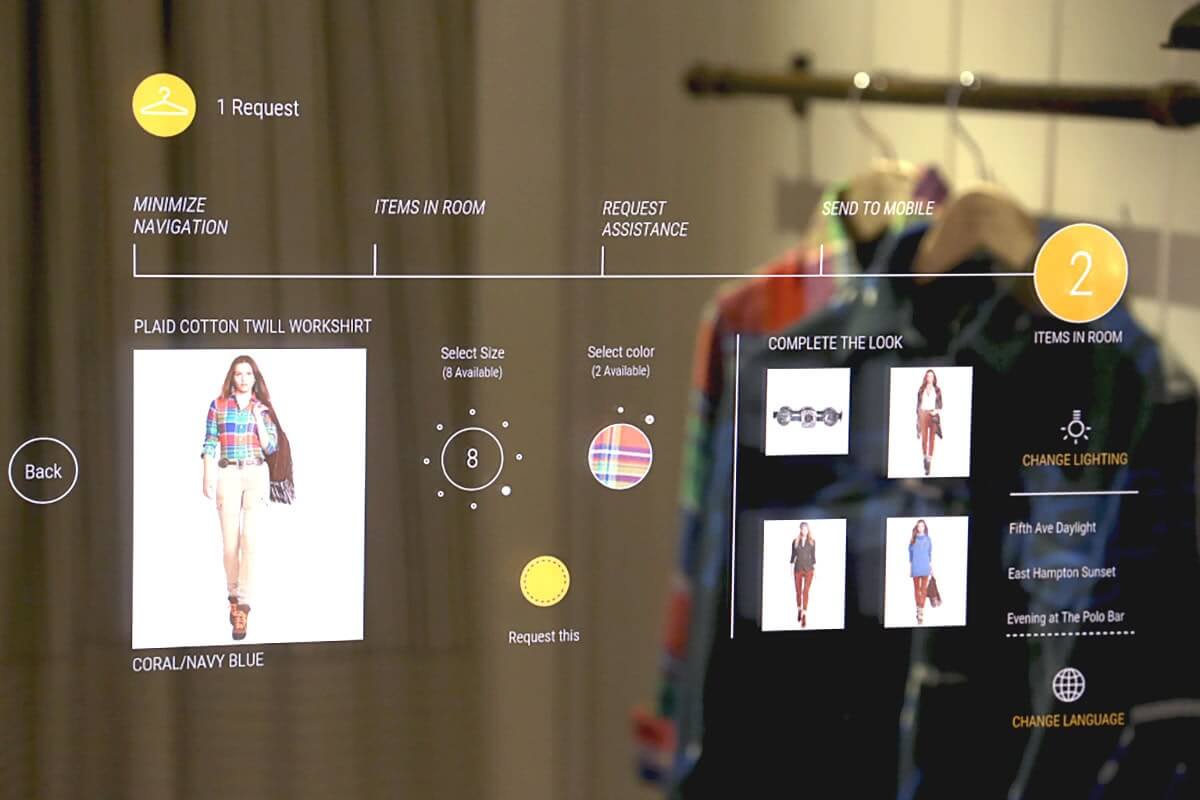

Abordar esses desafios requer novas formas de governança que sejam adaptadas às realidades do cenário digital, mas ainda assim estejam fundamentadas em direitos humanos e valores democráticos. Como destacado no artigo de Gorwa (2019) “The Platform Governance Triangle” (imagem acima), arranjos informais envolvendo estados, empresas e ONGs têm sido uma ferramenta importante até agora. No entanto, a governança do conteúdo online tem sido menos multissetorial do que outras áreas da governança da Internet, com a sociedade civil frequentemente marginalizada.

Estes arranjos vêm evoluindo no tempo, como mostra a imagem abaixo, mas a complexidade intrínseca da governança de plataformas demanda outros pontos de partida e, quase certamente, caminhos que ainda não foram pensados até agora.

Para enfrentar adequadamente a complexidade deste desafio, talvez se devesse expandir esse triângulo para um multilema de governança de plataformas que envolva um espectro mais amplo de partes interessadas:

- Reguladores nacionais: Desempenham um papel crucial no desenvolvimento e aplicação de regras adaptadas aos contextos locais, considerando as normas culturais e legais específicas. No entanto, como observado nos pontos 2 e 3 (acima), os reguladores nacionais também devem estipular requisitos robustos de transparência para práticas de moderação de conteúdo e exigir supervisão humana significativa de sistemas de IA (ponto 4, acima).

- Reguladores e organismos internacionais: Órgãos como a UE, o Conselho da Europa e a ONU são vitais para facilitar a coordenação transfronteiras (ponto 5) e promover normas globais. Eles podem criar fóruns para o desenvolvimento de códigos de conduta da indústria (como o Código da UE sobre Desinformação), bem como delinear padrões baseados em direitos humanos para a governança de plataformas.

- Empresas de plataforma: Como os principais atores diretamente responsáveis pela moderação de conteúdo e design de sistemas, envolvimento das empresas de plataformas é indispensável. No entanto, eles não podem ser deixados para policiar a si mesmos; em vez disso, eles devem se envolver em esforços de co-regulamentação (ponto 4) e ser responsáveis perante órgãos de supervisão independentes (ponto 3). As plataformas também devem contribuir com fundos para apoiar a alfabetização midiática, verificação de fatos e jornalismo (pontos 6 e 9).

- ONGs: As organizações da sociedade civil são cruciais para defender os direitos dos usuários, promover transparência e responsabilizar plataformas e governos. Eles devem ter assentos à mesa em quaisquer arranjos de governança e receber recursos adequados para desempenhar seu papel de vigilância.

- Conselhos consultivos dos usuários das plataformas: As vozes dos mais diretamente afetados pelas decisões de governança de plataformas muitas vezes estão ausentes. Conselhos consultivos com membros selecionados de forma transparente podem ajudar a garantir que preocupações e perspectivas dos usuários sejam levadas em conta.

- Especialistas independentes: Acadêmicos, grupos de reflexão e outros especialistas podem criar análises valiosas e recomendações baseadas em evidências para informar os esforços de governança. Eles também podem ajudar a projetar estruturas para o acesso do pesquisador aos dados da plataforma (ponto 10), permitindo o estudo de questões de integridade e os impactos das intervenções políticas.

- Órgãos de administração eleitoral, partidos políticos, grupos de integridade eleitoral: Dado o potencial das plataformas digitais de impactar os processos eleitorais, é vital que os órgãos de administração eleitoral tenham assento nos arranjos de governança. Eles podem ajudar a alinhar as regras de publicidade online com as leis eleitorais existentes (ponto 7) e servir como um canal para denunciar violações e desinformação eleitoral.

Reunir tantas partes interessadas não será uma tarefa fácil. Assimetrias de poder, incentivos conflitantes e diferenças ideológicas criarão tensões significativas. As plataformas podem resistir a esforços percebidos como restrição de suas operações; governos podem tentar cooptar o processo para seus próprios fins; organizações da sociedade civil com agendas diferentes podem entrar em conflito.

No entanto, se os fóruns apropriados fossem estabelecidos – potencialmente sob os auspícios de órgãos respeitados, regionais ou globais – um diálogo sustentado poderia render progressos graduais. O objetivo seria desenvolver padrões, melhores práticas e mecanismos de supervisão para a governança de plataformas, fundamentados no direito internacional sobre os direitos humanos (por exemplo, Artigo 19 do PIDCP).

Através de discussões multissetoriais, estudos baseados em evidências (ponto 10) e experimentação cuidadosa, os elementos de uma abordagem “multilemma” para a moderação de conteúdo poderiam ser reunidos.

As bases para um possível algoritmo de alto nível que possa ser usado no processo pode se parecer com…

- Plataformas desenvolvem e implementam políticas claras e acessíveis de conteúdo alinhadas com as normas internacionais de direitos humanos (sem esquecer a legislação local, de cada país).

- Avaliação de risco aos direitos humanos é realizada para políticas de conteúdo (incluindo recomendações) e implantações de IA.

- Sistemas de IA são implantados para sinalizar o conteúdo para moderação, com salvaguardas robustas e supervisão humana (ponto 4); a moderação utomática por algoritmos deve ter transparente, explicável e reversível, nos casos de bloqueio.

- Equipes de moderação humana, adequadamente dimensionadas e apoiadas, revisam decisões de IA. Face à imensidão do universo de contribuições às plataformas, no tempo, a moderação humana quase certamente só será possível sobre os processo de tomada de decisão dos al;goritmos.

- Processos de criação de relatórios transparentes e acessíveis para usuários são instalados e podem ser ativados pelos próprios usuários, sob certas restrições operacionais e econômicas.

- Notificações claras devem ser enviadas aos usuários sobre conteúdo removido/ações tomadas, e suas consequências.

- Oportunidades de recurso temporais e justas para os usuários (ponto 3). Deve haver mecanismos claros, automatizados ou não, de recurso das decisões.

- Plataformas publicam relatórios de transparência detalhando ações de moderação, recursos, etc. (pontos 2, 3).

- Interfaces e fluxos específicos, em tempo quase real, para autoridades eleitorais/verificadores de fatos denunciarem violações das normas das plataformas, da regulação, das leis vigentes.

- Órgãos de supervisão multissetoriais monitoram a implementação dos mecanismos e se envolvem regularmente com as plataformas.

- Pesquisadores têm acesso a dados -através das APIs- para estudar impactos e eficácia dos mecanismos de regulação (ponto 10).

- Revisões periódicas são realizadas por auditores independentes e resultados publicados.

- Financiamento sustentado e apoio -das plataformas- para alfabetização midiática, jornalismo, verificação de fatos (pontos 6, 9).

Implementar esse modelo seria um desafio significativo. Exigiria instituições eficazes, mecanismos de aplicação em vários níveis e um compromisso sustentado de uma ampla coalizão de partes interessadas. A aplicação desigual por diferentes estados poderia levar à fragmentação.

Algumas plataformas podem se retirar de certos mercados em vez de cumprir as regras, como aconteceu agora, no Brasil, com a decisão de Google e Twitter de não aceitar publicidade eleitoral, dadas as novas regras para tal. Mas deve-se dizer que, no caso, mesmo com todas as razões para que as novas regras façam sentido, nada parecido com um documento como este foi discutido com a miríade de agentes que acreditamos que deveriam ter sido envolvidos no processo.

Mas os riscos de inação superam em muito os desafios de avançar. Sem supervisão significativa, tendências atuais de poluição da informação, polarização e manipulação podem se acelerar rapidamente, sufocando a esfera pública e a própria democracia.

De fato, a saúde a longo prazo da democracia na era digital pode muito bem depender da construção de novas formas de governança colaborativa e responsiva.

As respostas não serão perfeitas e exigirão iteração contínua.

Mas através do diálogo multissetorial contínuo, pesquisa rigorosa e comprometimento com os direitos humanos, é possível criar modelos de governança de plataformas que orientem o poder da tecnologia para o bem público, protegendo e promovendo liberdades fundamentais e capacitando os cidadãos no processo.

Fazê-lo não será fácil – mas é essencial para salvaguardar a integridade das sociedades democráticas na era digital e além.

Referências

Council of Europe. (2023). Declaração Europeia sobre os direitos e princípios digitais para a década digital. https://tinyurl.com/vfkwewzw.

European Comission (2024). The Digital Services Act package. https://tinyurl.com/23v45aws.

Fay, R. (2019). Digital Platforms Require a Global Governance Framework. Centre for International Governance Innovation. https://tinyurl.com/55x5tm6j.

Gorwa, R. (2019). The platform governance triangle: conceptualising the informal regulation of online content. Internet Policy Review, 8(2). https://doi.org/10.14763/2019.2.1407

Gorwa, R., Binns, R., & Katzenbach, C. (2020). Algorithmic content moderation: Technical and political challenges in the automation of platform governance. Big Data & Society, 7(1). https://doi.org/10.1177/2053951719897945

Kaye, D. (2019). Speech Police: The Global Struggle to Govern the Internet. Columbia Global Reports. https://tinyurl.com/2rc284yk.

Kimmelman, G. (2020). The Right Way to Regulate Digital Platforms. Harvard Kennedy School Shorenstein Center. https://tinyurl.com/yc8uh6xr.

Marsden, C., Meyer, T., & Brown, I. (2020). Platform values and democratic elections: How can the law regulate digital disinformation?. Computer Law & Security Review, 36. https://doi.org/10.1016/j.clsr.2019.105373

OCDE. (2023). Diretrizes da OCDE para Empresas Multinacionais sobre Conduta Empresarial Responsável. https://tinyurl.com/48mm2kef.

Pickard, V. (2020). Restructuring Democratic Infrastructures: A Policy Approach to the Journalism Crisis. Digital Journalism, 8(6), 704-719. https://doi.org/10.1080/21670811.2020.1733433

Regulation (EU) 2016/679 of the European Parliament and of the Council of 27 April 2016 on the protection of natural persons with regard to the processing of personal data and on the free movement of such data, and repealing Directive 95/46/EC (General Data Protection Regulation). https://tinyurl.com/2mdess2a.

Santa Clara Principles on Transparency and Accountability in Content Moderation. (2018). https://santaclaraprinciples.org

Tworek, H. (2019). Social Media Councils. Centre for International Governance Innovation. https://tinyurl.com/4jjjzu58.

UN Office on Drugs and Crime. (2020) The role of the media in fighting corruption. https://tinyurl.com/4zszt3m8.

UN General Assembly. (1966). International Covenant on Civil and Political Rights. Treaty Series, 999, 171. https://tinyurl.com/mexv2tr3.

UN Special Rapporteur on the Promotion and Protection of the Right to Freedom of Opinion and Expression. (2018). Report of the Special Rapporteur to the Human Rights Council on online content regulation. A/HRC/38/35. https://tinyurl.com/3r9pe7xd.