Se um sistema afeta a vida das pessoas, exige-se que seu comportamento seja justo. Pelo menos no que costumamos chamar de civilização. Ser justo é tratar todos da mesma forma em cada contexto, sem favorecer ou discriminar ninguém. Dito assim, fica fácil ver que o mundo é injusto e que a busca por mais justiça será eterna. E sempre haverá interesses buscando favorecimento e discriminação. Em tal mundo, injusto, estamos escrevendo algoritmos para tomar decisões sobre a vida das pessoas. E é certo que devemos fazer o melhor que podemos para que eles sejam justos. Pelo menos tanto quanto possível.

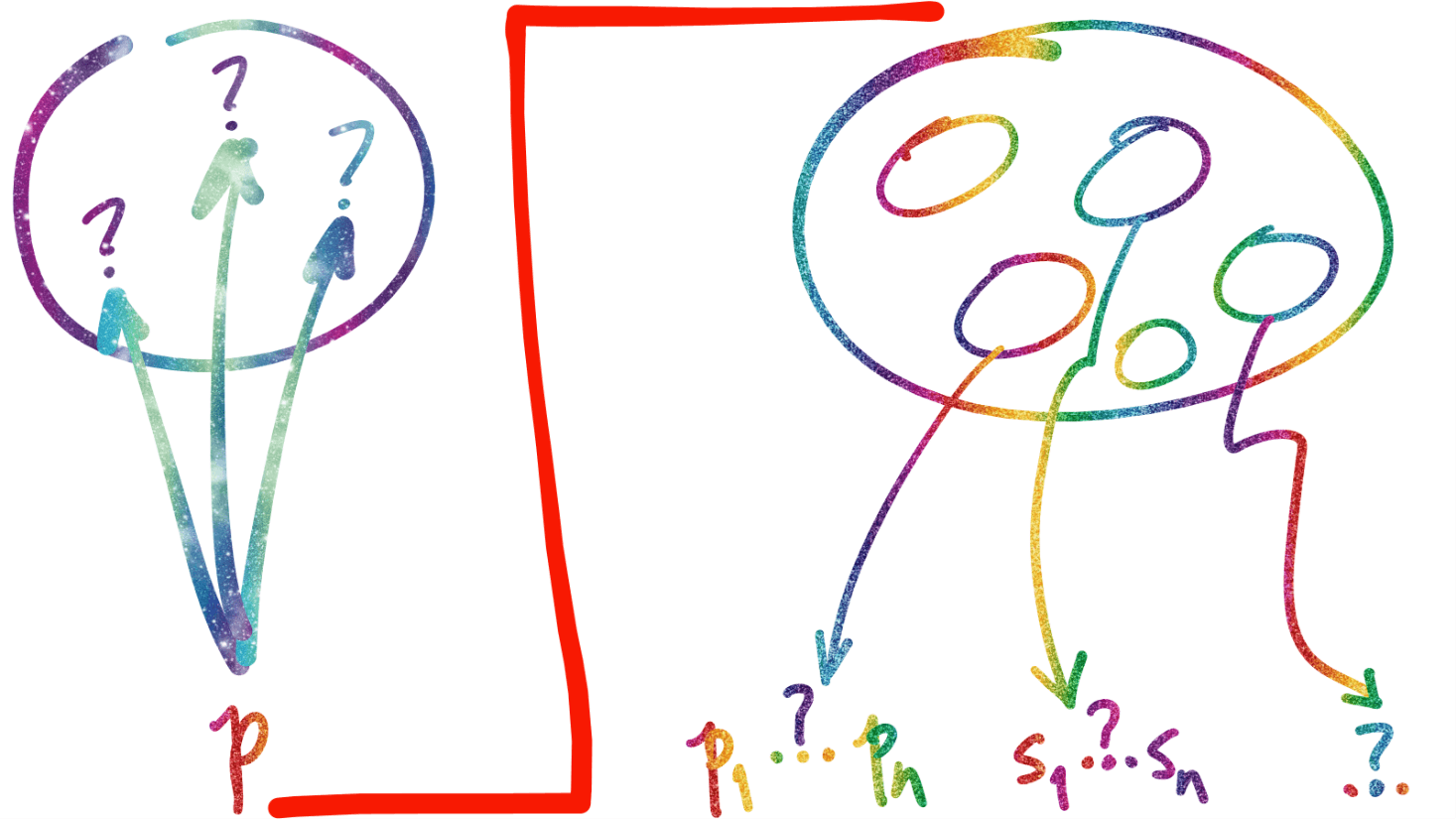

Há muita pesquisa sobre como garantir que um algoritmo é justo [por exemplo, “Algorithmic Fairness”, Dana Pessach & Erez Shmueli, arXiv, JAN 2020: bit.ly/2HMX8TF]. Mas parece ser impossível mostrar que um algoritmo, incluindo os de inteligência artificial e, em especial, os de aprendizado de máquina, é justo sem informação de fora do sistema [como mostrado em “The measure and mismeasure of fairness”, Adrian Colyer, the morning paper, FEV/2020: bit.ly/32iqLFE].

Em outras palavras, não é possível escrever um algoritmo que decide se um outro é justo ou não. E que, quase certamente, ao invés de deixar certas classes de decisões que afetam a vida das pessoas a critério de um algoritmo, talvez seja mais prudente -e muito mais justo- ter a análise e recomendação feitas por um algoritmo apenas como parte do processo de tomada de decisão e longe da intervenção que, lá no mundo real, tentará resolver um problema.

Parafraseando Stuart Russell [Em “Human Compatible: AI and the problem of control”, VOX, OUT/2019, bit.ly/2STSnxJ], algoritmos são benéficos na medida em que se espera que suas ações alcancem nossos objetivos. O problema, aí, é o significado de “nossos”. Numa rara oportunidade para entender os meandros de sistemas que tratam pessoas, o estudo de um algoritmo de retenção de segurados nos EUA mostrou que sua essência era cobrar menos dos clientes com mais chance de mudar de seguradora e cobrar mais dos clientes mais fiéis [veja “Suckers List: How Allstate’s Secret Auto Insurance Algorithm Squeezes Big Spenders”, The Markup, FEB/2020: bit.ly/39XSkXo. Em que serviços isso acontece no Brasil? Será que nossos reguladores do setor de seguros e finanças, além de telecom e outros, não deveriam avaliar os algoritmos de seus regulados para saber se os clientes estão sendo tratados de forma justa?

Algoritmos tomam decisões que, cada vez mais, afetam vidas. “Eles”, ou seus responsáveis, terão que se explicar, inclusive do ponto de vista legal, quando a justiça de suas ações for posta em causa [ver “Accountability of AI Under the Law: The Role of Explanation”, Finale Doshi-Velez et al, arXiv, DEZ/2019, bit.ly/2T735zU]. No caso das caixas pretas de inteligência artificial, as explicações deverão ser formais [“Fairwashing: the risk of rationalization”, Ulrich Aïvodji et al., arXiv, MAI/2019: bit.ly/2HULJAU] e isso não vai ser fácil, até porque será preciso confiar em quem -ou no que- cria as explicações.

E isso, por sua vez, pode criar mais problemas do que resolve. Uma das soluções para tratar as caixas pretas é código aberto [How IBM is leading the fight against black box algorithms”, COMPUTERWORLD, SET/2018, bit.ly/2vf4T1I], o que deveria ser óbvio, já que quase todos os sistemas relevantes do presente e do futuro estão na nuvem, interdependentes de muitos outros sistemas; abrir o código para análise por terceiros não afeta a essência do modelo de negócios e cria a transparência mínima para que se confie que “suas ações alcançam nossos objetivos”.

Mais cedo do que tarde, haverá uma demanda objetiva para proteger as pessoas dos algoritmos [“An Examination of the Algorithmic Accountability Act of 2019”, M. MacCarthy, Georgetown Univ., OUT/2020, bit.ly/2DiB5oZe] e nós deveríamos estar discutindo como fazer isso desde já, e por muito tempo a partir de agora, para evitar que, lá no futuro, se tome decisões legislativas sem as necessárias reflexões para fazer algo de longo prazo, exequível e, principalmente, justo. Para as pessoas e os algoritmos, também.

********************

Uma versão editada deste texto foi publicada no ESTADÃO em 11/03/20.