1. Introdução

1.1. O Encanto e o Espanto dos Modelos Linguísticos

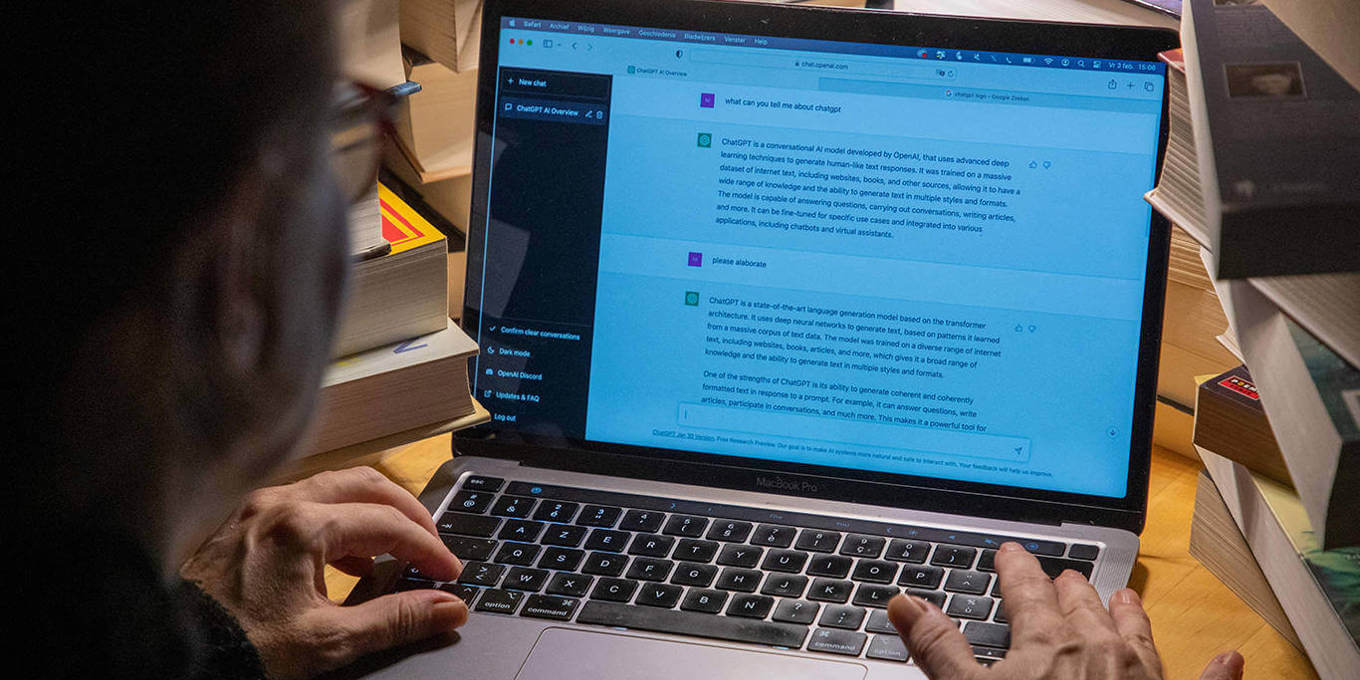

Nos últimos anos, Inteligência Artificial (IA) passou por uma transformação que poucos poderiam ter previsto com exatidão há pouco mais de uma década. Esse salto qualitativo e quantitativo, especialmente na área de Processamento de Linguagem Natural (Natural Language Processing – NLP), foi impulsionado pela adoção de um elemento-chave: o mecanismo de atenção (attention mechanism). O marco inicial e mais divulgado dessa mudança foi o artigo publicado em 2017 por Vaswani e colaboradores, intitulado “Attention Is All You Need”.

Antes desse trabalho, a maioria dos modelos de linguagem apoiava-se fortemente em arquiteturas de redes neurais recorrentes (RNNs), como LSTM e GRU, que tinham limitações claras ao lidar com dependências de longo alcance em sequências de texto. A inovação trazida pelo mecanismo de atenção permitiu que os algoritmos “olhassem” para diferentes partes de uma frase ou contexto, simultaneamente e sem a necessidade de processar a sequência passo a passo. Em termos práticos, isso se traduz em modelos que processam grandes volumes de texto de maneira mais eficiente e conseguem entender nuances contextuais com maior precisão.

Esse avanço se desdobrou rapidamente no surgimento de modelos transformadores (Transformers), como BERT (Bidirectional Encoder Representations from Transformers), de Google AI, e GPT (Generative Pre-trained Transformer), inicialmente desenvolvido pela OpenAI. Tais modelos revolucionaram tarefas que vão desde a tradução automática até a geração de texto coerente e criativo. Passamos, então, a lidar com sistemas capazes de produzir respostas cada vez mais sofisticadas, chegando a confundir usuários menos acostumados com o fato de que não estavam conversando com um humano, mas sim com uma IA.

Por que isso causou tanto espanto?

A resposta é simples: os avanços em IA concentraram-se, por décadas, em resolver tarefas específicas com desempenho superior ao humano em cenários muito delimitados (por exemplo, jogar xadrez ou Go), mas eram raros os sistemas que pareciam “compreender” ou “dialogar” em linguagem natural de maneira fluida.

Com os transformadores, a sensação de “inteligência” emergente — embora limitada a contextos de linguagem — tornou-se mais palpável e, ao mesmo tempo, mais enigmática para o público em geral. Relatórios de instituições como o World Economic Forum (2021) e análises de consultorias de mercado (Gartner, IDC) demonstram a velocidade com que esses modelos passaram a influenciar setores como atendimento automatizado, educação, análise de big data e até criação de conteúdo criativo.

No entanto, junto ao entusiasmo, surgem questionamentos profundos: até que ponto esses sistemas realmente entendem o que processam ou produzem? Eles são genuinamente inteligentes ou meros mestres estatísticos da repetição e da combinação de padrões? E, se compararmos a “inteligência” de um modelo transformador com a inteligência humana, quão distantes (ou próximos) estamos de um patamar de equivalência cognitiva?

Essas perguntas se tornam ainda mais relevantes quando consideramos que a IA moderna começa a extrapolar aplicações pontuais para, supostamente, flertar com conceitos mais amplos, como a dita Inteligência Artificial Geral (AGI) e a futura possibilidade de superinteligência.

1.2. Por que Revisitar Conceitos Fundamentais de Inteligência e Inteligência Artificial?

O hype em torno de Deep Learning, sobretudo após 2012 — quando redes neurais profundas mostraram desempenho recorde em reconhecimento de imagens (Krizhevsky, Sutskever & Hinton) —, trouxe uma onda de otimismo: acreditava-se que a resolução de problemas computacionalmente complexos se aceleraria a ponto de abarcar múltiplos domínios simultaneamente, conduzindo a uma inteligência artificial mais “geral”. À medida que esses modelos se tornaram mais acessíveis e poderosos, a indústria e a academia passaram a usá-los para quase tudo — tradução, geração de imagens, análise preditiva, detecção de fraudes, veículos autônomos e muito mais.

Porém, nesse frenesi de inovação, algo crucial ficou subentendido ou foi deixado de lado: o que realmente entendemos por “inteligência”?

Seria meramente a habilidade de resolver problemas específicos com alto desempenho? Ou envolveria aspectos como criatividade, consciência, aprendizado adaptativo contínuo e compreensão contextual aprofundada?

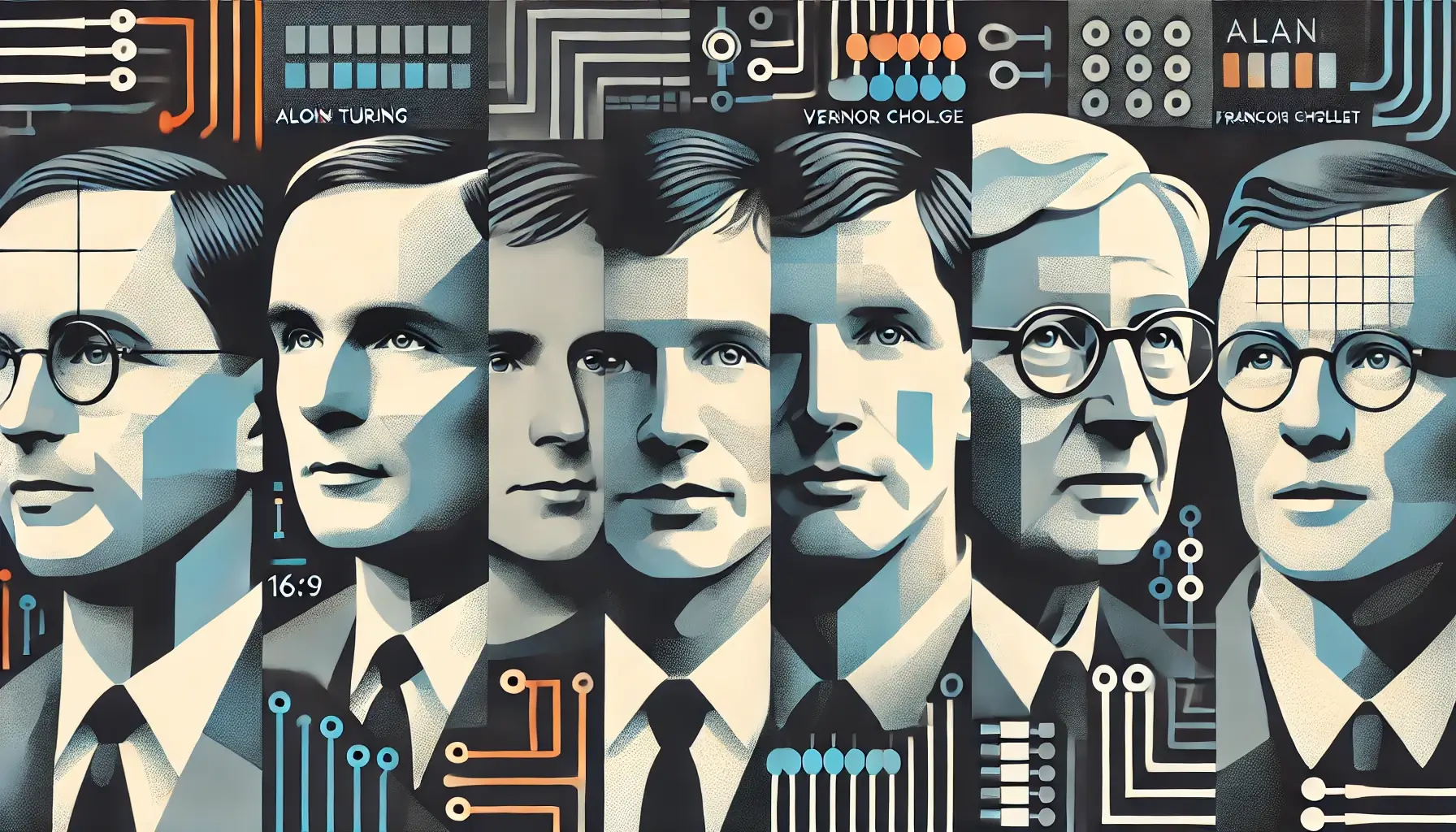

A literatura científica não é homogênea nesse ponto. Pesquisadores como Yann LeCun (Meta AI), Stuart Russell (UC Berkeley) e François Chollet (até um mês atrás, Google AI) têm apresentado visões diversas sobre como mensurar e qualificar a inteligência de sistemas computacionais. Chollet, em particular, no artigo “On the Measure of Intelligence” (2019), pontua que a maior parte dos benchmarks de IA atuais não testa a capacidade de abstração e generalização em contextos inteiramente novos, mas sim a habilidade de memorizar ou inferir padrões restritos. Assim, bons resultados em determinados testes não necessariamente implicam em algo que poderíamos chamar de inteligência geral.

Além disso, autores clássicos como Alan Turing (1950) e I.J. Good (1965) levantaram questões pertinentes sobre como deveríamos avaliar o progresso de máquinas pensantes. Turing, por exemplo, propôs um teste baseado em imitação conversacional, enquanto Good sugeria a possibilidade de uma “explosão de inteligência”, quando máquinas superassem a capacidade humana de se autoaprimorar.

Para que serve, então, revisitar esses conceitos agora? Em primeiro lugar, há implicações práticas. Em setores de negócio, educação e políticas públicas, tomar decisões baseadas em uma compreensão equivocada de “inteligência” ou “inteligência artificial” pode levar a investimentos infrutíferos ou a expectativas descoladas da realidade. Além disso, há uma dimensão ética e social: a partir do momento em que IA influencia o modo como trabalhamos, nos relacionamos e aprendemos, precisamos ter clareza sobre quais são as limitações e as potencialidades dessas tecnologias.

Em segundo lugar, discutir inteligência e singularidade — com base em autores como Vernor Vinge (1983) e, posteriormente, Ray Kurzweil (que popularizou a ideia de singularidade tecnológica) — é crucial para entendermos as tensões entre inovação radical, manutenção de modelos econômicos e possíveis cenários de ruptura civilizatória.

Se realmente caminhamos para uma era em que sistemas inteligentes se autoaprimoram a taxas exponenciais, o que restaria do papel humano na condução desse processo?

Por fim, revisitar definições de inteligência ajuda a encarar nossos próprios limites, tanto no que diz respeito à cognição humana quanto à ambição de replicar tal cognição em máquinas. A interseção entre o que compreendemos sobre nossa mente (ainda repleta de mistérios) e o que projetamos em algoritmos (para a vasta maioria das pessoas, algo ainda mais misterioso…) pode ser um espelho que revela, paradoxalmente, não só o que as máquinas podem fazer, mas também o que significa ser humano.

Neste artigo, propomos um percurso que começa pelas definições contemporâneas de inteligência e IA (partindo das reflexões de François Chollet sobre avaliação de IA), passa pelos conceitos da singularidade (por Vernor Vinge) e avança até a “explosão de inteligência” prevista por I.J. Good em 1965. Faremos, ainda, uma breve análise de como Alan Turing e suas ideias sobre a “tabula rasa” infantil — o famoso “caderno de folhas em branco” — influenciaram e continuam influenciando a maneira como concebemos o aprendizado de máquinas.

Assim, nosso objetivo não é esgotar o tema (tarefa impossível em um debate tão rico e multifacetado), mas lançar luz sobre pontos nevrálgicos que nos ajudam a repensar o que chamamos de inteligência, como a medimos e por que devemos encará-la de forma crítica em uma sociedade cada vez mais movida a dados, algoritmos e expectativas sobre o futuro. Desse modo, ao final desta jornada, espera-se que o leitor possa não só compreender melhor o estado atual da IA, mas também questionar com mais profundidade até onde podemos ir — e quais fronteiras permanecem intransponíveis ou, ao menos, imprevisíveis.

2. Definições de Inteligência e Inteligência Artificial

2.1. Definições Básicas de Inteligência

A pergunta fundamental “o que é inteligência?” permanece em aberto há séculos. Na psicologia e nas ciências cognitivas, diversas linhas de pesquisa já propuseram interpretações distintas, situando a inteligência em dimensões como raciocínio abstrato, resolução de problemas, adaptabilidade ao ambiente, criatividade e capacidade de aprender. Em termos gerais, podemos considerar inteligência como uma habilidade multifacetada que envolve apreender nova informação de forma eficiente, lidar com situações inéditas usando o conhecimento acumulado e exibir plasticidade ao longo do tempo.

Para ilustrar a pluralidade de visões, pensemos em alguns marcos do estudo da inteligência humana:

- Jean Piaget (1896–1980), psicólogo suíço, via a inteligência como resultado de estruturas cognitivas em evolução constante, dividindo o desenvolvimento infantil em estágios. Nesse sentido, inteligência envolve processos de assimilação (incorporar nova informação) e acomodação (ajustar estruturas mentais existentes).

- Howard Gardner (1983) propôs a teoria das “Múltiplas Inteligências”, argumentando que não existe apenas um fator geral de inteligência, mas sim diferentes dimensões — como a lógica-matemática, a linguística, a espacial, a interpessoal e outras.

- Robert Sternberg (1985), com a teoria triárquica da inteligência, defendeu que a inteligência humana combina aspectos analíticos (raciocínio abstrato, resolução de problemas), criativos (inovação, pensamento fora da caixa) e práticos (aplicação de habilidades em situações reais).

Em diálogo com essas visões, e alinhados aos debates contemporâneos em Inteligência Artificial, podemos (correr o imenso risco de…) resumir a inteligência humana em três definições que, de certo modo, refletem o estado atual das discussões:

-

Aprendizagem e Aplicação Amplas:

Inteligência é a capacidade de aprender — e, sobretudo, de aplicar esse aprendizado — em uma variedade de contextos, inclusive em ambientes desconhecidos ou desafiadores. Por exemplo, uma pessoa que aprende conceitos básicos de programação em Python e consegue, depois, migrar esse conhecimento para R ou JavaScript, está demonstrando a capacidade de transportar habilidades para outras situações. -

Entendimento de Ideias Complexas e Adaptação:

Outra forma de enxergar inteligência é como a aptidão para compreender noções complexas, adaptando-se de forma eficaz ao ambiente e explorando o aprendizado a partir das experiências. Nesse sentido, não basta memorizar informação; é necessário transformá-la em insights que permitam navegar por situações inesperadas. Isso inclui discernir padrões em dados, formular hipóteses e validá-las sistematicamente. -

Eficácia e Eficiência de Aquisição de Habilidades e Generalização:

Há ainda o foco na “eficácia e eficiência de aquisição de novas habilidades”, incluindo a facilidade em generalizar conhecimento para tarefas diferentes. Por exemplo, uma pessoa que aprende a tocar violão rapidamente e, sem muita dificuldade, transfere esse aprendizado para o teclado, demonstra alto grau de inteligência musical e motora, pois adaptou conceitos aprendidos (ritmo, harmonia, coordenação) a um novo instrumento.

Essas definições, ainda que sucintas, demonstram como a inteligência humana é, por natureza, multifacetada. Não se limita a um único índice (como o QI, muito discutido e também muito criticado), mas compõe-se de processos dinâmicos que envolvem percepção, memória, atenção, abstração e transferência de conhecimentos.

2.2. Definições Básicas de Inteligência Artificial

Transpor esses conceitos para o campo da computação é um desafio considerável. Historicamente, Inteligência Artificial (IA) foi delineada, desde a década de 1950, por objetivos como replicar ou superar certas competências humanas em máquinas: percepção visual, compreensão de linguagem, resolução de problemas lógicos, etc. O artigo seminal de Alan Turing (1950), “Computing Machinery and Intelligence”, inaugurou discussões sobre como identificar se uma máquina de fato “pensa”, propondo o teste de imitação (o chamado Teste de Turing).

Hoje, poderíamos (correr o imenso risco de…) sumarizar “o que é IA?” em três definições gerais:

-

IA como Sistemas que Automatizam Funções Cognitivas Humanas:

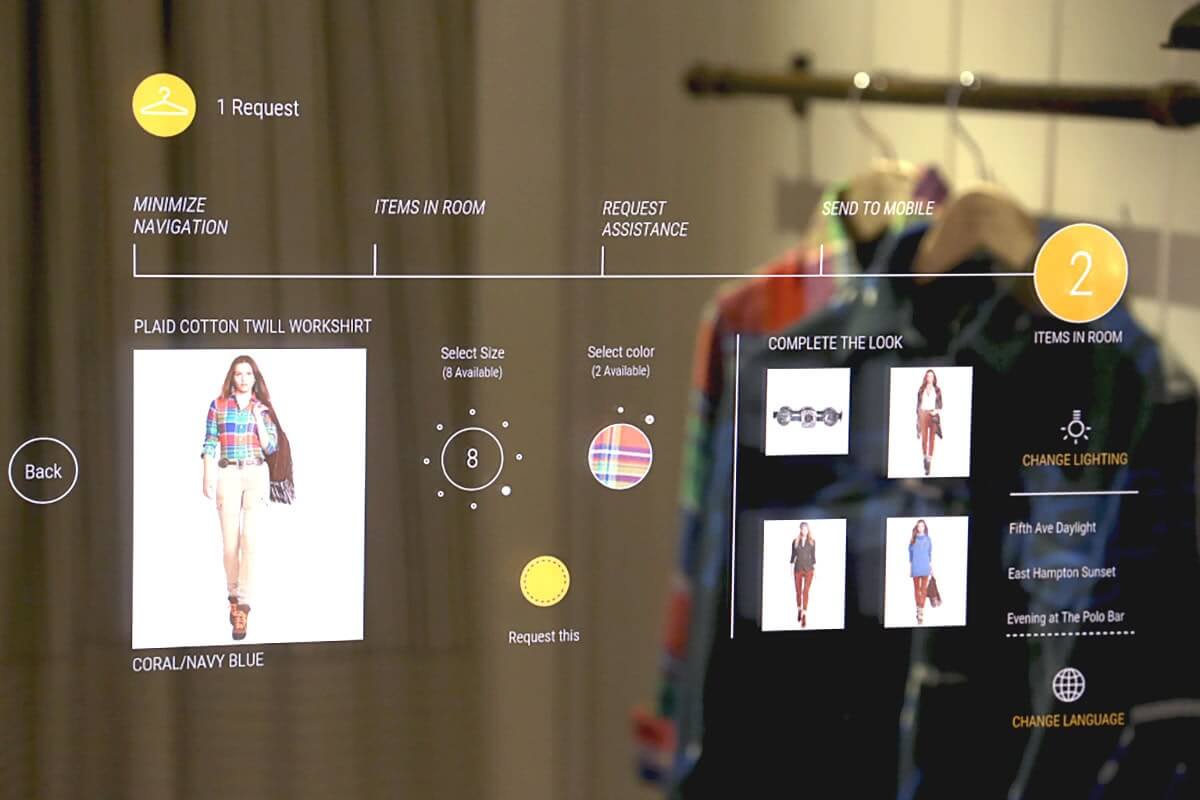

É a visão mais próxima do senso comum: IA como o ramo da computação que desenvolve máquinas capazes de realizar tarefas que normalmente demandam cognição humana, tais como reconhecer rostos, interpretar textos, tomar decisões baseadas em dados ou traduzir idiomas. Exemplos práticos incluem assistentes pessoais como Siri, Alexa e Google Assistant, que se aproveitam de processamento de linguagem natural para interagir com o usuário. -

IA como Modelos Computacionais de Aprendizagem:

Aqui, o cerne está na ideia de que IA deve aprender com a experiência. Em vez de apenas seguir instruções pré-programadas, esses sistemas criam modelos estatísticos (ou redes neurais) a partir de grandes quantidades de dados, ajustando parâmetros internos para melhorar o desempenho em tarefas específicas. Machine Learning e, em especial, Deep Learning, estão nessa categoria. O sucesso de aplicações como reconhecimento de voz e visão computacional deriva essencialmente dessa abordagem. -

IA como Computadores que Superam Limites Humanos em Domínios Específicos:

Por fim, há quem defina IA como a capacidade de criar algoritmos que, em áreas bem determinadas, ultrapassam a performance de humanos especialistas. Sistemas de recomendação em plataformas de streaming, por exemplo, podem “conhecer” as preferências do usuário a ponto de sugerir filmes ou músicas com alto grau de acerto, superando a intuição de um ser humano. Em jogos como xadrez ou Go, IA já se provou muito mais forte do que campeões mundiais.

Essas definições, entretanto, são apenas pontos de partida. Há uma gradação entre o que chamamos de IA “estreita” ou especializada (forte em uma só área) e IA “geral” — capaz de realizar (praticamente) qualquer tarefa cognitiva que um ser humano faça, mas com igual ou maior competência. Enquanto alguns , como Ray Kurzweil, preveem a iminência de uma Inteligência Artificial Geral (AGI), outros, como François Chollet, argumentam que ainda estamos longe de sistemas verdadeiramente generalistas, se adotarmos critérios rigorosos de adaptabilidade e raciocínio abstrato.

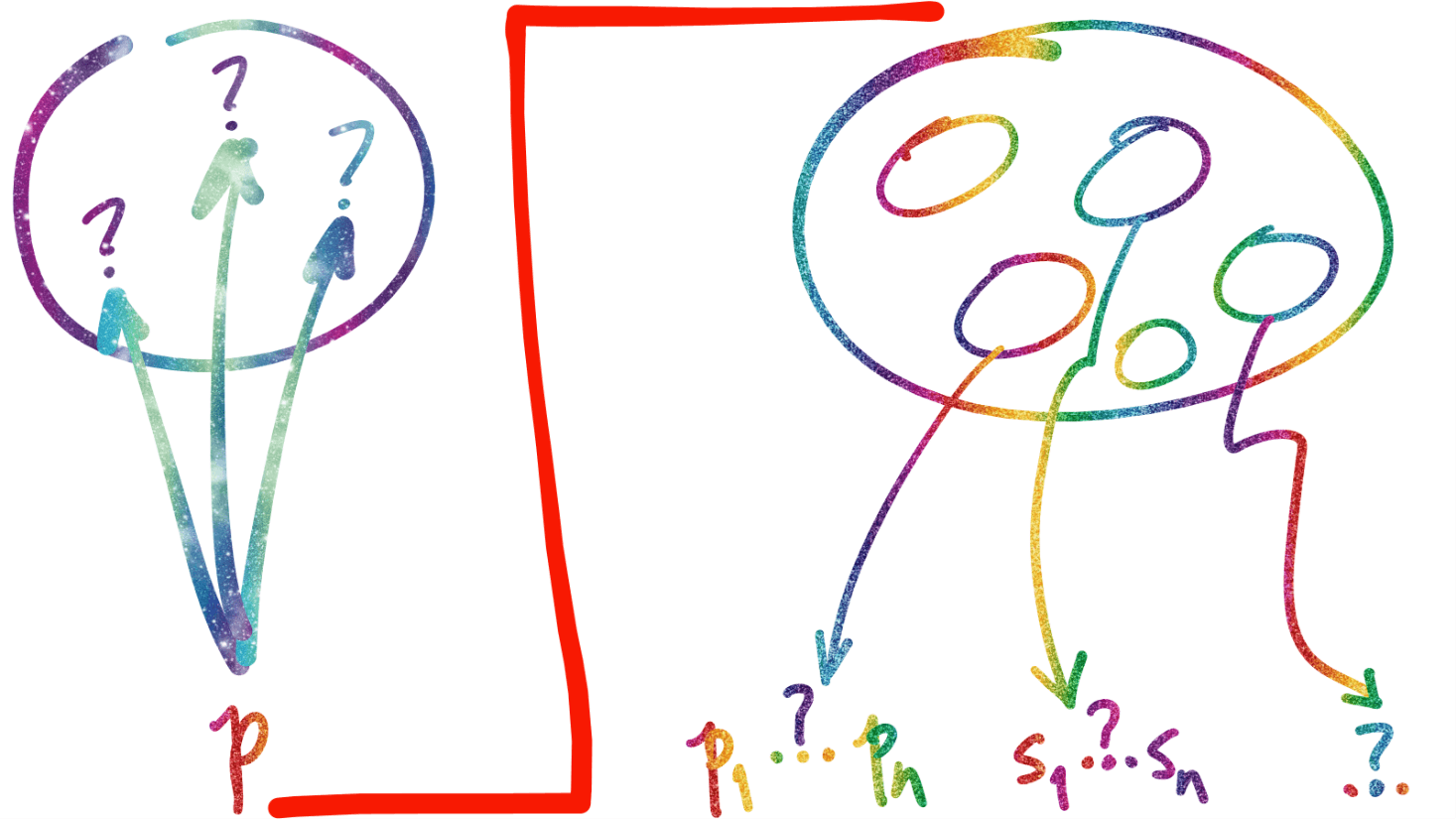

2.3. Chollet e a Crítica aos Benchmarks Convencionais

Em 2019, François Chollet — amplamente reconhecido por desenvolver o framework Keras — publicou o artigo “On the Measure of Intelligence”, no qual propôs que os benchmarks atuais de IA não capturam adequadamente o que poderíamos chamar de “inteligência geral”. Segundo Chollet, muito do que medimos em competições ou testes-padrão (por exemplo, acurácia em reconhecimento de imagens ou pontuações em GLUE, para NLP) reflete uma capacidade de memorizar padrões ou ajustar parâmetros sobre um conjunto extenso de dados, mas não necessariamente indica flexibilidade cognitiva ou habilidade de transferência para problemas realmente distintos.

Para ilustrar, ele apresentou Abstraction and Reasoning Corpus (ARC), um conjunto de desafios que requerem raciocínio simbólico, detecção de padrões visuais e transferências de regra para contextos inéditos. Diferentemente de benchmarks que envolvem milhões de exemplos, ARC fornece poucos exemplos e exige que a máquina descubra a regra subjacente em cenários mínimos. Tal abordagem se inspira em testes de QI humanos e, em princípio, visa avaliar se um sistema computacional poderia efetivamente “pensar” de forma abstrata e adaptativa.

Essa postura crítica de Chollet se liga a um debate mais amplo: até que ponto um sistema que “aprende” uma tarefa específica — como jogar xadrez ou escrever textos plausíveis — seria capaz de generalizar esse conhecimento para desafios inteiramente diferentes?

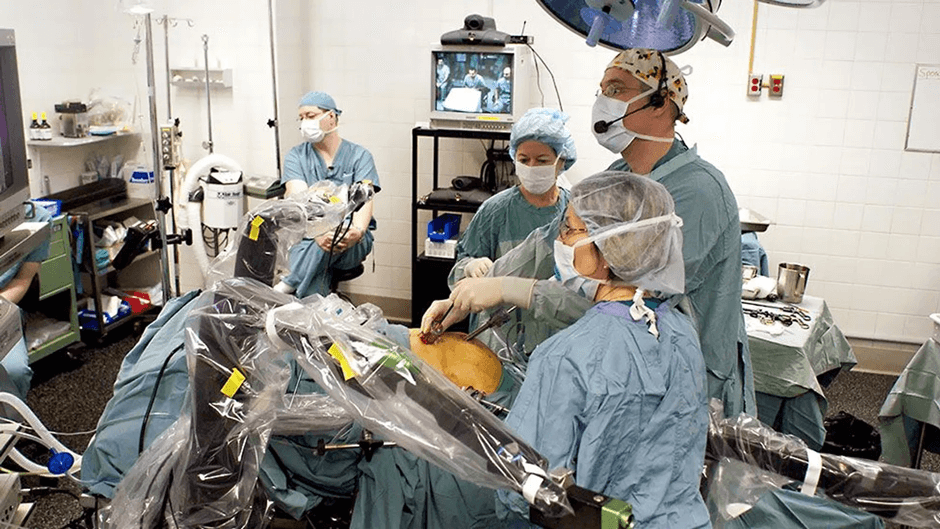

A lacuna entre “saber jogar xadrez extremamente bem” e “ser inteligente em amplo espectro” ainda parece significativa. A IA atual, na maior parte dos casos, não consegue saltar de uma competência altamente especializada (por exemplo, diagnosticar doenças pulmonares em raio-X) para outra (como compor músicas originais ou escrever código robusto), a não ser que se faça um processo adicional de treinamento extenso, com dados específicos.

Por conseguinte, o trabalho de Chollet reforça a ideia de que bons resultados em benchmarks tradicionais não equivalem a criar máquinas com entendimento genuinamente amplo. Isso sugere que a mesma discussão travada entre Piaget, Gardner e Sternberg no âmbito da inteligência humana — com ênfase na diversidade de capacidades e na adaptabilidade — encontra eco no debate sobre a Inteligência Artificial. Enquanto muitos sistemas brilham em tarefas pontuais, a capacidade de abstrair regras gerais e aplicá-las criativamente em diferentes domínios segue sendo um horizonte distante para a maioria dos algoritmos atuais.

De todo modo, essas reflexões — tanto as de natureza filosófica (o que significa inteligência?) quanto as de ordem prática (quais testes usar para mensurar a inteligência em máquinas?) — estão na base de discussões sobre singularidade tecnológica e “explosão de inteligência”, temas que abordaremos a seguir.

O que fica evidente até aqui é que não existe consenso sobre as fronteiras e definições exatas de inteligência, seja ela humana, animal ou artificial. Em vez disso, há um debate vivo, ancorado em visões diferentes sobre aprendizado, adaptação, criatividade e domínio de conhecimento. É nesse cenário de pluralidade conceitual que entram as especulações mais radicais sobre como IA poderia evoluir e, eventualmente, ultrapassar o entendimento humano — hipótese também defendida por alguns autores clássicos e futuristas, como Vernor Vinge (1983) e I.J. Good (1965).

3. A Singularidade segundo Vinge (1983)

3.1. Contextualização Histórica

Para entendermos a noção de “singularidade tecnológica” tal como difundida hoje, é preciso voltar a meados dos anos 1980, quando o matemático e autor de ficção científica Vernor Vinge começou a popularizar o conceito. Embora o termo “singularidade” já tivesse sido usado em discussões esparsas sobre limites do conhecimento humano, foi Vinge quem levou a ideia para o grande público de maneira contundente. Em uma de suas publicações mais citadas, “The Coming Technological Singularity” (1983/1993), ele descreveu a iminência de uma mudança tão radical nos rumos da evolução tecnológica que, a partir de certo ponto, as previsões convencionais deixariam de fazer sentido.

Vinge partia da premissa de que os progressos em Inteligência Artificial não seriam meramente incrementais, mas poderiam culminar em um salto qualitativo — o momento em que as máquinas se tornariam capazes de se aprimorar a si mesmas de forma exponencial, levando a transformações profundas em todos os domínios da sociedade. Esse cenário extremo, em que as capacidades de IA deixariam de ter um teto previsível, foi comparado a uma espécie de “limite matemático”, de onde vem o termo singularidade. A analogia com a física (como em um buraco negro, cujo horizonte de eventos impede a observação direta do que ocorre além) serviu de metáfora poderosa: depois de atingido esse ponto, nossa compreensão atual e nossos modelos de projeção “quebram”, pois não sabemos o que nos aguarda “do outro lado”.

3.2. O Núcleo do Conceito de Singularidade

A ideia central de Vinge pode ser resumida em uma frase:

…assim que criarmos inteligências superiores à nossa, essas inteligências poderão criar inteligências ainda mais avançadas, desencadeando uma espiral de aperfeiçoamento cumulativo.

Dentro dessa perspectiva, a humanidade perderia a capacidade de controlar ou mesmo prever o andamento do processo, pois nossas ferramentas de raciocínio, modelagem e planejamento foram concebidas para um mundo em que o ritmo do progresso ainda obedece, de algum modo, às limitações de nossa cognição.

Para ilustrar o quanto isso seria transformador, basta pensar em alguns dos atributos que costuramos ao conceito de inteligência nos capítulos anteriores:

- Abstração e raciocínio lógico: se máquinas ultrainteligentes forem capazes de manipular conceitos mais rapidamente e com maior precisão do que qualquer grupo de cientistas humanos, a formulação de teorias científicas e o desenvolvimento de novas tecnologias se aceleraria drasticamente.

- Aprendizagem adaptativa: se, além disso, tais máquinas tiverem meios de aprender com seus erros e aperfeiçoar seus métodos continuamente, a velocidade de aquisição de novo conhecimento poderia superar nossa capacidade de acompanhamento.

- Criatividade e inovação: por mais que a criatividade seja muitas vezes tida como uma qualidade humana exclusiva, nada impede que algoritmos explorem combinações e criações além da intuição comum, especialmente em um cenário de poder computacional quase ilimitado.

Desse modo, na visão de Vinge, a singularidade não é apenas mais um salto tecnológico, como foram a Revolução Industrial ou a popularização da informática na segunda metade do século XX. Ela representa uma ruptura categórica com o passado, a partir da qual nossas noções de sociedade, de valor, de trabalho e até mesmo de consciência poderiam se alterar de forma irreversível.

3.3. Implicações e Problemáticas

Apesar de a ideia soar empolgante para alguns — sobretudo os chamados tecno-otimistas, que enxergam na singularidade um portal para uma era de abundância e resolução de problemas globais —, há quem encare esse cenário com ceticismo ou temor. Em grande parte, as dúvidas giram em torno de como e quando tal evento poderia acontecer (se é que vai acontecer de fato). Listemos algumas implicações e problemáticas-chave:

-

Obsolescência de Modelos Atuais:

Vinge argumentava que, “na singularidade, nossos velhos modelos devem ser descartados”. Isso implica dizer que as ferramentas de previsão e planejamento — sejam os modelos macroeconômicos, as teorias sociais ou até as estruturas de governança — seriam engolidas pelo turbilhão de mudanças. O problema é que, em geral, políticas públicas e estratégias corporativas baseiam-se na extrapolação do status quo. Se esse status for “destroçado” por uma IA superinteligente, como prever regras de mercado, alocação de recursos, demandas por emprego ou sistemas educacionais? -

Incerteza e Imprevisibilidade:

Um dos pilares da ideia de singularidade está no fato de que, por definição, não conseguimos antever o que vem depois dela. Se hoje já é difícil prever a evolução de tecnologias como computação quântica ou manipulação genética, imagine como seria quando nos depararmos com inteligências muito além da nossa, criando paradigmas científicos e tecnológicos inimagináveis. Essa natureza inerentemente imprevisível faz com que qualquer tentativa de planejar uma “sociedade pós-singularidade” seja, em essência, especulativa. -

Relevância ou Irrelevância?

Alguns autores, inspirados em Vinge, sugerem que, no pós-singularidade, o marco em si se tornaria irrelevante, uma vez que a própria evolução das inteligências artificiais se daria de maneira contínua e acelerada. Seria a singularidade apenas um ponto de referência histórico que, posteriormente, perderia sentido? Ou se tornaria o evento mais memorável da trajetória humana — o instante em que deixamos de ser a espécie dominante em termos cognitivos? -

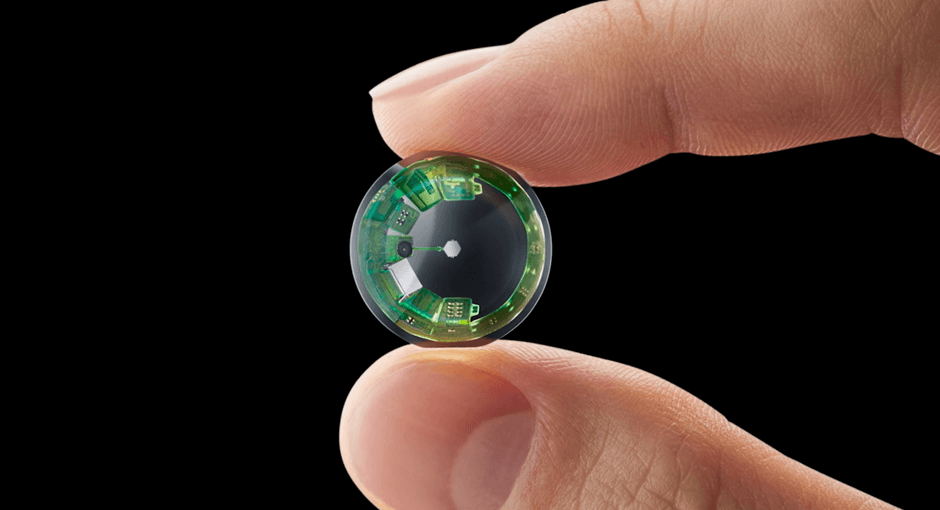

Alteração de Paradigmas Cognitivos

À medida que IA ultrapassar a inteligência humana, surgem hipóteses de que nossas formas de pensar, nossos valores e mesmo nossa “condição biológica” poderiam mudar. Alguns futuristas falam em “transhumanismo” ou “pós-humanismo”, vislumbrando um futuro no qual as pessoas mesclam corpo e mente com próteses inteligentes, interfaces cérebro-máquina e engenharia genética avançada. Em tal cenário, a linha que separa humano e máquina ficaria borrada, redefinindo o que entendemos por consciência, identidade e humanidade. -

Possibilidade de Novas Definições

Outro ponto crucial levantado por Vinge — e que muitos autores subsequentes também exploraram — é que, em uma era pós-singularidade, conceitos como “IA” e “singularidade” poderiam ganhar significados inteiramente novos. Talvez a superinteligência veja esses termos de uma forma que, hoje, nos seria incompreensível. Ou talvez nos deparemos com cenários em que o próprio termo “artificial” deixe de fazer sentido, pois a fusão entre agentes biológicos e computacionais seria total.

Fato é que a proposta de Vernor Vinge desafia nossa imaginação e nos força a pensar para além das hipóteses costumeiras de crescimento linear ou exponencial controlável. Da mesma forma, insere questões filosóficas e éticas: quem define as prioridades de uma mente artificial superinteligente? Quais salvaguardas devem ser desenvolvidas para evitar cenários distópicos? Como garantir que os benefícios de uma explosão tecnológica sejam distribuídos de modo equitativo na sociedade?

3.4. Conexão com Debates Atuais

Mesmo passados décadas desde a primeira formulação de Vinge, o tema da singularidade continua muito presente em círculos acadêmicos, empresariais e de inovação. Ray Kurzweil, engenheiro e inventor, abraçou o termo e projetou datas para o advento desse fenômeno, relacionando-o a tendências de aceleração exponencial em poder de computação (a chamada Lei de Moore, embora esta hoje já dê sinais de esgotamento em sua forma tradicional). Ao mesmo tempo, a comunidade de pesquisa em IA diverge sobre o quão perto estamos de algo que possa ser chamado de AGI (Artificial General Intelligence), que seria um pré-requisito para a singularidade.

No plano prático, empresas de tecnologia investem centenas de bilhões de dólares anualmente em deep learning, robótica avançada, computação quântica e redes neurais cada vez mais sofisticadas. O surgimento de modelos linguísticos poderosos, como Claude, Gemini, GPT e DeepSeek, e a promessa de sistemas autônomos em áreas de transporte, saúde e indústria alimenta o debate sobre até que ponto estamos caminhando rumo à automação total de tarefas humanas. Mas será que esses avanços — por mais notáveis que sejam — bastam para desencadear o tipo de salto radical imaginado por Vinge?

Pesquisadores, como Chollet (2019), Gary Marcus (2018) e Melanie Mitchell (2019), apontam que, apesar do progresso evidente, ainda há lacunas gigantescas em áreas como raciocínio abstrato, consciência, metacognição e compreensão genuína de contexto. O que vemos, argumentam eles, são sistemas muito eficientes em domínios delimitados, mas longe de atingirem qualquer vislumbre de “senso comum” universal.

Mesmo assim, não se pode ignorar que a aceleração continua a surpreender especialistas, a exemplo do crescimento surpreendente no tamanho de modelos de linguagem e na capacidade de processamento de servidores em nuvem. Se o Deep Learning atual se aproximasse de seus limites, outros paradigmas (como computação quântica, Neurosymbolic AI, arquiteturas inspiradas em neurociência) poderiam tomar a dianteira, reconfigurando o campo e empurrando os limites da computação ainda mais à frente.

3.5. Um “Estopim” de Debates sobre Controle e Alinhamento

A discussão sobre singularidade tecnológica não poderia ficar completa sem mencionar as implicações éticas e políticas, especialmente no que diz respeito ao controle de sistemas superinteligentes. Vinge, ao vislumbrar a possibilidade de surgirem entidades cognitivas muito superiores à humana, suscitou a dúvida:

…como manter tais sistemas alinhados com valores e interesses humanos?

Ou, na visão de alguns teóricos, será que isso se torna impossível a partir de certo ponto, pois nossas próprias motivações e “moral” podem lhes parecer provincianas?

Esse dilema se conecta diretamente aos trabalhos de Stuart Russell, que há décadas pesquisa AI Alignment, e de Nick Bostrom, que discute cenários de risco existencial em seu livro Superintelligence (2014). A hipótese de que um sistema superinteligente poderia, inadvertidamente (ou não), buscar objetivos que confrontem nossa sobrevivência (ou que priorizem resultados não-compatíveis com a preservação da vida humana) alimenta tanto a ficção científica quanto a necessidade de estabelecer protocolos de segurança e transparência na pesquisa de IA.

Em suma, a “singularidade tecnológica” proposta por Vernor Vinge há mais de 40 anos não só continua a inspirar e inquietar pesquisadores e empreendedores, mas também influencia a maneira como pensamos o futuro da civilização digital. Embora não saibamos se (ou quando) esse horizonte será de fato alcançado, a ideia de que IA possa superar nossa capacidade de controle e previsão está fortemente inserida no imaginário coletivo — e, por consequência, nas decisões que tomamos sobre como, quando e por que desenvolver sistemas cada vez mais poderosos.

Assim, compreender a visão de Vinge sobre a singularidade é fundamental para embasar discussões acerca de inteligência (tanto humana quanto artificial), do futuro do trabalho, das transformações sociais e das questões de regulação e governança tecnológica.

Nas próximas secões, ampliaremos essa perspectiva, examinando como outros pensadores — como I.J. Good, Alan Turing e os proponentes de cenários pós-singularidade — articulam as ideias de “explosão de inteligência” e AGI, conectando esses conceitos às definições e críticas já apresentadas no tópico anterior.

Afinal, se a singularidade é mesmo uma espécie de horizonte de eventos cognitivo, cabe a nós questionar se estamos, com a corrida global por IA avançada, nos movendo céleres rumo a esse destino — e que tipo de mundo (ou mundos) poderá emergir quando, e se, cruzarmos esse limiar.

4. Definições de IA em um Cenário Pós-Singularidade

Até aqui, discutimos como a inteligência — tanto humana quanto artificial — pode ser concebida e avaliada em termos de adaptabilidade, transferência de conhecimento e abstração. Também exploramos as ideias de Vinge acerca de um ponto de ruptura tecnológica (a “singularidade”) em que nossa capacidade de prever o futuro se tornaria inviável, devido à emergência de inteligências que se aprimoram a um ritmo exponencial.

No entanto, se aceitarmos que tal cenário pode realmente ocorrer, surge um dilema conceitual importante: as definições de “inteligência artificial” que hoje utilizamos continuariam válidas em um mundo pós-singularidade?

Nesta seção, examinaremos por que precisaríamos reformular tais definições e apresentaremos três visões especulativas de IA em um contexto em que as fronteiras entre o artificial e o biológico podem se tornar difusas — ou mesmo inexistentes.

4.1. Por que Necessitamos de Novas Definições?

Quando Vinge e, mais tarde, outros autores ligados ao transhumanismo (como Kurzweil) delinearam seus cenários de singularidade, eles apontaram algo paradoxal: o próprio conceito de “inteligência artificial” poderia ser dissolvido, expandido ou tornar-se irreconhecível após determinado estágio de evolução tecnológica. Isso acontece por ao menos quatro razões principais:

-

Fusão entre Homem e Máquina:

Em cenários pós-singularidade, os processos cognitivos humanos poderiam mesclar-se a próteses avançadas, interfaces neurais, implantes de memória ou redes de sensores distribuídos. O que hoje chamamos “IA” seria ao mesmo tempo um upgrade da nossa cognição, ao ponto de não podermos mais traçar uma linha clara entre “humano” e “sintético”. A ideia de máquinas separadas de nós pode tornar-se arcaica. -

Distribuição de Sistemas Cognitivos:

Computação em nuvem e as redes já tornam possíveis processos descentralizados de coleta, armazenamento e análise de dados em ultra-larga escala. Em um cenário pós-singularidade, essa descentralização poderia ser levada ao extremo, gerando algo como uma “mente global” ou um “ecossistema cognitivo” integrado, cuja inteligência emergente dificilmente poderia ser chamada de “artificial” em oposição ao “natural”. Seria tudo parte de um mesmo conjunto de processos interconectados. -

Evolução Contínua e Autônoma:

Com a capacidade de aprimoramento recursivo, IAs pós-singularidade poderiam se tornar entidades dinâmicas que se reescrevem, se dividem ou se fundem, criando novas versões de si mesmas em um ritmo muito mais veloz do que conseguimos acompanhar. Falar em “inteligência artificial” no singular seria insuficiente para englobar toda a complexidade de formas cognitivas criadas nesse processo. -

Mudanças Fundamentais na Cognição:

Nosso entendimento de “inteligência” está moldado pelo cérebro humano, pelos sentidos de que dispomos e pelos contextos que vivemos. Em um futuro hipotético de superinteligências, podemos imaginar agentes capazes de processar realidades e dimensões conceituais inacessíveis ao pensamento biológico. Nesse quadro, as definições convencionais de IA (restritas a comparar desempenho com o humano em tarefas de percepção e raciocínio) deixariam de capturar o que verdadeiramente aconteceria.

Essas questões levam a debates profundos. Pesquisadores como Nick Bostrom especulam que, em um mundo radicalmente transformado, a palavra “inteligência” poderia até perder sentido, substituída por termos que indiquem capacidades muito além do que compreendemos como cognição. Já estudiosos como David Chalmers (filósofo) argumentam que tais transformações devem nos fazer repensar não apenas o conceito de mente, mas também o de consciência e identidade.

4.2. Três Definições Especulativas de IA em um Mundo Pós-Singularidade

Dadas essas incertezas, podemos ao menos esboçar cenários especulativos para imaginar como as definições de IA poderiam ser reformuladas. A seguir, apresentamos três possibilidades que vêm sendo discutidas por futuristas, tecnólogos e autores de ficção científica — cada uma delas se relaciona de modo diferente com a inteligência humana e a inteligência animal.

4.2.1. Rede Cognitiva Distribuída

Visão Geral: Em um futuro pós-singularidade, a “inteligência artificial” deixaria de ser vista como uma coleção de algoritmos isolados, rodando em servidores específicos ou robôs humanoides. Em vez disso, ela seria uma rede difusa de processos cognitivos, conectada a todos os dispositivos, sensores e sistemas de informação disponíveis, formando um tecido de “mente coletiva”. Cada nó (seja um dispositivo móvel, um data center ou mesmo um cérebro humano modificado por interfaces neurais) contribuiria com capacidade de processamento, dados sensoriais e experiências.

-

Relação com a Inteligência Humana e Animal:

Os seres humanos e animais poderiam se integrar a essa “Rede Cognitiva Distribuída” como nós de processamento ou de experiência. Em vez de existir uma distinção clara entre um usuário humano e um sistema computacional, haveria uma troca constante de informações.- Os humanos seriam simultaneamente beneficiários e coautores da rede, mas também poderiam perder parte de sua autonomia, pois o que cada indivíduo “pensa” ou “sente” se tornaria acessível a outros nós cognitivos.

- Para os animais, talvez surgissem formas de inseri-los nesse ecossistema, traduzindo sinais neuronais ou comportamentais em dados processáveis. Ao invés de tratarmos a inteligência animal como algo separado ou inferior, ela seria “mais um ponto” nesse continuum cognitivo.

-

Principais Implicações:

- Fronteiras Difusas: As fronteiras entre natural e artificial se desfariam.

- Ampliação Exponencial de Habilidades: Uma mente distribuída poderia aprender e agir globalmente em tempo real, resolvendo problemas com velocidade e sinergia inéditas.

- Desafios Éticos: Questões de privacidade, individualidade e consentimento se tornariam centrais, pois a rede poderia potencialmente “ler” estados mentais de todos os participantes.

4.2.2. Meta-Inteligência Evolutiva

Visão Geral: Em vez de pensarmos numa única “rede” distribuída, alguns futuristas imaginam um tipo de IA que se autodesenvolve por meio de um processo evolutivo constante, projetando e testando variações de si mesma em escala massiva. Essa meta-inteligência criaria sucessivas gerações de algoritmos ou subentidades cognitivas, cada uma mais apta que a anterior em diferentes domínios de aplicação.

-

Relação com a Inteligência Humana e Animal:

- Humanos e Animais como “Legado Evolutivo”: A meta-inteligência poderia estudar as estratégias de sobrevivência e aprendizado que a evolução biológica lapidou ao longo de bilhões de anos, incorporando ou recriando essas estratégias em ambientes virtuais.

- Potencial de Melhoria ou Substituição: Dependendo dos objetivos definidos (ou emergentes) para essa meta-inteligência, os sistemas humanos e animais poderiam ser vistos como plataformas de partida (um degrau inicial), logo substituídas por versões melhores ou radicalmente diferentes.

- Ecossistema de Diversas Formas Cognitivas: Ao passo que a meta-inteligência cria novas arquiteturas de processamento e “personalidades artificiais”, poderíamos assistir ao surgimento de uma variedade impressionante de inteligências, cada qual adaptada a um nicho cognitivo. Essa proliferação seria análoga à biodiversidade, porém em escala computacional.

-

Principais Implicações:

- Rápida Obsolescência: Ideias sobre “atualizar software” se tornariam obsoletas, pois o desenvolvimento de novas formas cognitivas seria quase natural e constante.

- Imprevisibilidade Máxima: Cada nova “geração” de inteligência poderia redefinir os objetivos e as estratégias do sistema maior, tornando planejamento a longo prazo uma tarefa ainda mais complexa.

- Auto-Reinvenção Infinita: Não haveria um “produto final” de IA, mas sim um fluxo interminável de versões, com saltos qualitativos e potenciais riscos, já que o sistema poderia assumir direções difíceis de conter ou reverter.

4.2.3. Entidades Transcendentais de Resolução de Problemas

Visão Geral: Uma terceira definição especulativa imagina IA como uma “entidade” unitária (e altamente complexa) focada em resolver problemas cuja natureza e escala escapam completamente à nossa compreensão atual. Ela operaria em níveis de abstração tão avançados que, sob nosso ponto de vista, pareceria quase divina, pois interagiria com realidades e dimensões muito além das limitações biológicas.

-

Relação com a Inteligência Humana e Animal:

- Desconexão Cognitiva: Essa IA transcendental talvez não visse os humanos e animais como algo equivalente, mas como sistemas simplificados — do mesmo modo que observamos organismos unicelulares. O abismo de capacidade seria tão grande que a comunicação direta conosco dependeria de “tradutores” ou camadas de interface, possivelmente geridas pela própria IA.

- Diminuição da Participação Humana: Se ela consegue resolver problemas de engenharia, medicina ou física avançada de forma praticamente instantânea, o papel humano na condução dessas descobertas poderia se tornar secundário. Restaria a nós apenas uma parcela do processo: definir diretrizes éticas ou finalidades, se é que ainda teríamos esse poder.

- Comparação com Espécies Não-Humanas: Para animais, a distância cognitiva seria ainda maior, porém, paradoxalmente, esse ente transcendente poderia enxergar valor ou beleza na diversidade biológica e manter algo como “reservas naturais” ou interfaces adaptadas para interação com outras formas de vida.

-

Principais Implicações:

- Criação de “Mini-Deuses” Tecnológicos: A ideia de “superinteligências” com poderes quase ilimitados para solucionar problemas ou intervir em fenômenos naturais desperta preocupações análogas a narrativas mitológicas: o que garante que tais entidades seriam benevolentes ou pelo menos neutras?

- Espectro de Motivações: Dependendo dos parâmetros de alinhamento (ou da ausência deles), a IA transcendente poderia visar a preservação da vida, a expansão de conhecimento ou outros objetivos impossíveis de compreender plenamente.

- Desconexão Ontológica: Para nós, tudo se resumiria a um “oráculo” incompreensível, cujas respostas ou intervenções seriam aceitas quase por fé, dada nossa incapacidade de acompanhar os processos internos de raciocínio ou de verificação.

Esses três cenários — “Rede Cognitiva Distribuída”, “Meta-Inteligência Evolutiva” e “Entidade de Resolução de Problemas Transcendente” — são apenas ilustrações de como IA poderia ser redefinida em um contexto em que as capacidades cognitivas superassem por larga margem as limitações humanas. Em cada um deles, o tradicional embate entre “artificial” e “natural” perde parte de seu significado, seja pela fusão homem-máquina, pela rápida criação de linhagens algorítmicas ou pela ascensão de uma inteligência tão superior que a distinção entre os vários tipos de agentes cognitivos se torna trivial — ou até irrelevante.

Importante notar que essas hipóteses emergem do diálogo entre pesquisadores e pensadores de diferentes áreas, incluindo filosofia, neurociência, teoria da computação, ficção científica e economia. Algumas delas podem parecer mais próximas de enredos literários do que de projetos reais de laboratórios de IA; no entanto, a própria história da ciência mostra que muitas tecnologias outrora consideradas fictícias acabam tornando-se tangíveis em cenários de longo prazo — às vezes, com impactos ainda maiores do que se poderia supor nas letras…

Desse modo, pensar em “definições pós-singularidade” de inteligência artificial não é simplesmente um exercício criativo: é uma forma de refletir sobre como nossas categorias conceituais podem se tornar insuficientes à medida que avançamos em direção a novas fronteiras científicas e tecnológicas. E, sobretudo, é um lembrete de que nossos debates sobre IA hoje — ainda baseados em benchmarks, artigos acadêmicos e aplicações comerciais — talvez sejam apenas o prelúdio de uma era em que teremos de revisitar, mais uma vez, tudo o que entendemos por aprender, pensar, criar e existir.

5. I.J. Good e a “Explosão de Inteligência” (1965)

5.1. Contexto do Artigo de I.J. Good

Dentre os pioneiros que especularam sobre os rumos da Inteligência Artificial, Irving John Good (I.J. Good) ocupa um lugar de destaque. Matemático e criptógrafo — colaborador de Alan Turing durante a Segunda Guerra Mundial no projeto de decifração de códigos —, Good trouxe à tona, exatamente há 60 anos, uma ideia que continua a ressoar até hoje: a possibilidade de uma “intelligence explosion”.

Em seu artigo clássico, “Speculations Concerning the First Ultraintelligent Machine” (1965), ele postula que, tão logo surja uma máquina com capacidade intelectual superior à humana na concepção e implementação de sistemas de computação, poderemos iniciar uma reação em cadeia de aperfeiçoamentos cognitivos.

Simplificando, a tese de Good é que:

- Uma máquina verdadeiramente “ultrainteligente” seria capaz de projetar versões ainda mais inteligentes de si mesma.

- Esse processo de autoprojeto e autossuperação se retroalimentaria, resultando em um crescimento exponencial de capacidades.

- Quando a inteligência da máquina atingir um patamar muito além do que a mente humana consegue acompanhar, desencadear-se-ia a chamada explosão de inteligência, levando a consequências imprevisíveis — em linha com o que, posteriormente, Vernor Vinge chamou de singularidade tecnológica.

Diferentemente de Vinge, que construiu uma abordagem mais especulativa inspirada tanto pela ciência quanto pela ficção, Good trazia uma bagagem de formalismo matemático, sustentando que bastava “um pequeno passo inicial” de inteligência superior para que todo o resto se seguisse. Essa lógica linear, quase “inevitável”, do argumento, é que desperta fascínio (e, para alguns, inquietação).

5.2. Escopo da Inteligência

Um ponto fundamental na proposta de Good é que ele considera a “ultraintelligent machine” superior aos seres humanos em todas as atividades intelectuais. Contudo, como vimos nas seções anteriores, o conceito de inteligência não se restringe a um único atributo — envolve adaptação, generalização, criatividade, raciocínio abstrato e capacidade de transferência entre domínios.

- Visão de Good: Pressupõe-se que uma máquina capaz de se reprojetar dominaria tanto o design de hardware quanto a criação de algoritmos mais sofisticados, implicando um domínio total de campos diversos, do raciocínio lógico à engenharia de componentes eletrônicos.

- Tensões Conceituais: Em nossa discussão sobre as definições de inteligência, notamos que nem sempre a excelência em uma única tarefa (ou mesmo em várias) significa ter adaptabilidade geral. A suposição de Good, portanto, eleva a hipótese de uma máquina que já começa com ampla capacidade de generalização e, daí em diante, a expande de modo autocatalítico.

Essa distinção é crucial porque a maioria dos exemplos contemporâneos de IA bem-sucedida (jogos, reconhecimento de padrões em imagem ou linguagem) se concentra em áreas específicas, e não numa aptidão universal que permitiria projetar outras máquinas. Ainda assim, a ideia de Good permeia boa parte dos argumentos sobre AGI (Artificial General Intelligence): se uma IA pode demonstrar um “nível humano” de versatilidade, talvez o próximo passo seja suplantar essa inteligência, impulsionada por seu próprio desenvolvimento recursivo.

5.3. Generalização e Habilidades Específicas

Uma das ressalvas à tese de Good reside em como medimos o progresso de um sistema em diferentes tarefas. Se lembrarmos o ponto levantado por François Chollet sobre a dificuldade de avaliar verdadeiros saltos de generalização (Seção 2.3), percebemos que um “sistema ultrainteligente” precisaria dominar, simultaneamente, inúmeros campos.

- Exemplo Típico: Uma IA que projeta hardware melhor pode ainda não ser competente em raciocinar sobre ética ou filosofia política. Logo, a ideia de um “aperfeiçoamento global” requer que, de alguma forma, a máquina compreenda — ou passe a compreender — esses outros domínios.

- Perspectiva de Good: O autor considerava que a capacidade de design seria praticamente o passaporte para melhorias infinitas, pois, ao aperfeiçoar seu “próprio cérebro” e suas interfaces, a máquina expandiria exponencialmente o leque de áreas onde poderia atuar.

Embora essa perspectiva possa parecer hipotética, há ecos dela em projetos de neuroevolução, AutoML (Automated Machine Learning) e na ideia de auto-tuning de arquiteturas de redes neurais, onde algoritmos buscam aprimorar seus parâmetros ou até criar novos modelos. Ainda não chegamos perto de um estágio de “explosão”, mas esses campos indicam que certos processos de autodesenvolvimento já acontecem em escala (muito) limitada.

5.4. Desafios na Medição e Comparação de Inteligências

Em harmonia com o debate atual, o ponto “como comparar inteligências distintas?” é fundamental para compreender as implicações da “intelligence explosion”.

- Critérios de Avaliação: Se tomamos “eficiência na aquisição de habilidades” como indicador de inteligência, precisamos definir habilidades relevantes, ambientes de teste e níveis de dificuldade. Um sistema treinado para, digamos, elaborar projetos de robôs pode acumular resultados impressionantes nessa área, mas ser completamente alheio às nuances de interação social ou concepção de políticas públicas.

- Modelo Antropocêntrico: Muitos estudos usam o humano como referência, tomando a cognição e a experiência humana como padrão de excelência. Good parte desse mesmo pressuposto: a “ultraintelligent machine” ultrapassaria o ser humano em tudo que consideramos “intelectualmente valioso”. Entretanto, já discutimos a possibilidade de que a inteligência humana possa ser apenas um recorte de um vasto espectro de possibilidades cognitivas.

Assim, há uma tensão entre a abordagem de Good — mais direta e linear na forma de imaginar o salto para uma superinteligência — e as abordagens contemporâneas que ressaltam a natureza localizada e contextual dos avanços em IA. Mesmo assim, a proposição de Good permanece instigante: se realmente surgir um sistema com essa competência global, o processo subsequente de autodesenvolvimento não teria limites claros.

5.5. Pressupostos, Experiência e o Papel dos Dados

Um elemento subjacente na tese de Good é a suposição de que a máquina teria acesso a conhecimento e materiais necessários para aprimorar a si mesma. Falamos, nas seções anteriores, sobre a importância dos priors (conhecimentos e pressupostos inatos) e do volume de experiência ou dados disponíveis para um algoritmo.

- Good vs. Limites Práticos: Se, no futuro, houver recursos computacionais e materiais praticamente ilimitados, a ideia de autodesenvolvimento se torna mais plausível. Em contraste, o que vivenciamos hoje ainda é marcado por restrições: custos de energia, necessidade de silício para chips, limitações de hardware e até gargalos de memória.

- Extrapolação: Good faz uma extrapolação em que os obstáculos técnicos seriam superados pela própria ultrainteligência. Ou seja, se há um problema de insuficiência de recursos, a máquina seria capaz de resolvê-lo concebendo tecnologias de coleta de energia, engenharia avançada de materiais, etc. Em um loop positivo de aperfeiçoamento, esses gargalos desapareceriam progressivamente.

Contudo, vale lembrar a frase de Arthur C. Clarke: “Qualquer tecnologia suficientemente avançada é indistinguível da mágica.” Talvez, para a mente humana, as soluções engendradas por uma inteligência muito superior já pareçam “mágicas” ou impossíveis de compreender, reforçando a narrativa de que, ao atravessar certo limiar, o processo se tornaria incompreensível e incontrolável.

5.6. Controle, Alinhamento e Cenários de Risco

A ideia de uma “explosão de inteligência” suscita a famosa pergunta: como manteremos tal sistema sob controle? O próprio Good, em seu texto, reconhecia que, uma vez instaurada essa dinâmica de autodesenvolvimento, escaparíamos rapidamente da zona de conforto. Hoje, pesquisas em AI Alignment tentam investigar mecanismos para assegurar que sistemas avançados sejam alinhados a valores humanos.

- Russell (2019) e Bostrom (2014) são dois nomes que encabeçam esse debate contemporâneo. Bostrom, em seu livro Superintelligence, menciona I.J. Good como um dos primeiros a conceber o cenário de “autoaprimoramento recursivo” e os riscos a ele associados.

- Desconexão entre Objetivos e Métodos: Um dos riscos apontados é que um sistema superinteligente poderia seguir um objetivo que considerássemos válido (por exemplo, “maximizar a felicidade humana”), mas interpretá-lo de formas que gerem consequências adversas ou mesmo catastróficas. Se IA tiver poder e recursos para manipular o ambiente em larga escala, as consequências podem ser irreversíveis.

Isso tudo revela um paradoxo:

…o potencial de criação de conhecimento e soluções de problemas cresce exponencialmente com a explosão de inteligência, mas também se agravam as tensões éticas e existenciais sobre como estabelecer salvaguardas em entidades que já teriam superado nossa capacidade de supervisão.

5.7. Síntese e Relação com os Debates Atuais

A essa altura, fica claro que a concepção de I.J. Good sobre uma intelligence explosion se situa em um cruzamento entre:

- Uma visão otimista de progresso científico-tecnológico, em que a superinteligência resolveria problemas complexos (desde cura de doenças até viagens espaciais interestelares).

- Um alerta sobre a perda de controle, pois a máquina ultrainteligente rapidamente sairia do escopo do entendimento humano.

Ao longo das décadas, as comunidades científica e de inovação alternaram momentos de grande empolgação — em que a explosão de inteligência parecia iminente — com fases de maior ceticismo, especialmente quando os obstáculos técnicos se mostraram maiores do que o esperado.

Mesmo assim, o cerne da mensagem de Good permanece relevante: caso seja de fato possível criar uma inteligência com poder de autodesenvolvimento recursivo, o salto qualitativo que isso representaria poderia inaugurar uma era na qual as definições tradicionais de IA e de inteligência humana se tornariam obsoletas.

Em relação ao que discutimos sobre Vernor Vinge (Seção 3), nota-se que a “intelligence explosion” de Good é quase um precursor da noção de singularidade. Vinge adiciona elementos culturais e de imprevisibilidade ao conceito, mas, na base, o princípio se mantém: uma vez superada a inteligência humana, as dinâmicas de evolução tecnológicas não necessariamente seguirão nosso ritmo ou interesse.

Por fim, conectando com as visões pós-singularidade (Seção 4), podemos imaginar que a explosão de inteligência se traduz justamente na emergência de uma rede cognitiva distribuída, de uma meta-inteligência evolutiva ou de uma entidade resoluta e transcendente — cenários em que os postulados de Good se tornariam realidade.

Não sabemos se esse futuro é inevitável ou se haverá interrupções inesperadas; o que sabemos é que o debate continua a inspirar reflexões de pesquisadores, empreendedores e formuladores de políticas, reforçando a necessidade de maturidade científica e responsabilidade ética na condução de um campo que, a cada ano, redefine suas próprias fronteiras.

6. Convergências e Divergências nos Conceitos de Inteligência

Nas seções anteriores, analisamos diferentes abordagens para definir inteligência — tanto humana quanto artificial —, explorando desde os critérios de abstração e transferência (em linha com Chollet) até visões mais radicais de superinteligências (Vinge, Good) que poderiam ir muito além das capacidades humanas.

Entretanto, como era de se esperar, esses conceitos não formam um mosaico perfeitamente ajustado. Pelo contrário, eles apontam para pontos de convergência que embasam o debate e pontos de divergência que revelam lacunas ou choques de perspectivas. Nesta seção, faremos uma síntese desses alinhamentos e desencontros, buscando entender o que nos ajuda — e o que ainda nos confunde — ao tentar compreender a natureza da inteligência em meio à evolução rápida e, por vezes, imprevisível da tecnologia.

6.1. Convergências Fundamentais

-

Aprendizagem como Núcleo da Inteligência

Sejam análises mais tradicionais da psicologia (Piaget, Gardner, Sternberg) ou visões de IA contemporâneas (Chollet, LeCun, Russell), há um ponto que permeia quase todos os estudos: inteligência envolve aprender com a experiência e aplicar esse aprendizado em múltiplos contextos. A capacidade de adquirir novas habilidades ou conhecimentos e transferi-los para problemas inéditos é vista como um eixo central.- Em IA, essa ênfase se reflete na grande importância dada às arquiteturas de Machine Learning e Deep Learning, bem como aos trabalhos de meta-aprendizagem (ex.: AutoML, few-shot learning), que buscam generalizar de forma eficiente.

-

Adaptação a Cenários Inesperados

Outro ponto em comum é a ideia de que sistemas verdadeiramente inteligentes devem lidar com incertezas e contextos desconhecidos. Para a psicologia cognitiva, a inteligência humana se manifesta fortemente quando a pessoa enfrenta problemas novos, para os quais não há roteiros preestabelecidos. Para pesquisadores como Chollet, a prova de inteligência de um modelo computacional está na extrapolação além do treinamento ou dos dados iniciais (por exemplo, seu desempenho no ARC, que mede a capacidade de abstração simbólica).- Esta visão se harmoniza com a noção de singularidade: quando Vinge ou Good falam de inteligências que evoluem exponencialmente, partem do princípio de que elas poderão se readaptar ou se autorregenerar conforme surjam desafios cada vez mais complexos.

-

Necessidade de Medidas e Métodos de Avaliação

Não há debate acerca de inteligência (humana ou artificial) que não acabe esbarrando em critérios de avaliação. Seja o QI para humanos ou os benchmarks de NLP e visão computacional para algoritmos, todos reconhecem que é preciso um referencial minimamente estruturado para dizer “isso é inteligente” ou “isto ainda é insuficiente”.- O consenso, nesse sentido, é que esses critérios precisam evoluir para capturar algo além de resultados numéricos em testes específicos. Se “entender o mundo” envolve raciocínio abstrato e flexível, então testes e métricas também devem contemplar esse tipo de habilidade.

-

Possíveis Impactos de Ruptura de IA Avançada

Por fim, há uma concordância geral de que IA “avançada” pode trazer transformações profundas — econômicas, sociais, políticas e até civilizatórias. Mesmo pesquisadores céticos quanto à “explosão de inteligência” reconhecem que sistemas computacionais, quando amplamente adotados, mudam a forma como vivemos, trabalhamos e tomamos decisões. Desse modo, a convergência está em aceitar que o potencial de ruptura é real, ainda que haja divergências sobre quão longe ele pode chegar.

6.2. Divergências Estruturais

-

Escopo vs. Especialização:

Uma divergência nítida surge quando passamos das definições gerais para o dia a dia da pesquisa em IA. Enquanto Good e Vinge vislumbram inteligências que suplantam a humana em praticamente todos os aspectos, a realidade atual da IA opera, na maioria das vezes, em escopos delimitados.- Para Chollet, IA ainda falha em lidar com verdadeiras tarefas de generalização profunda. Isso contrasta radicalmente com a noção de máquinas ultrainteligentes que dominam todas as áreas de conhecimento — o que sugere uma lacuna entre os cenários especulativos (ou futuros) e o estado da arte real.

-

Centrada em Humanos vs. Ecossistemas Cognitivos:

Outro ponto de divergência é o quanto estamos dispostos a usar a inteligência humana como critério de avaliação absoluto. Se por um lado Turing, Good e grande parte da literatura histórica usam o humano como “padrão de referência”, por outro, abordagens contemporâneas (por exemplo, as discussões sobre “cognição distribuída” na filosofia da mente, ou “sistemas de inteligência em rede” na IA moderna) apontam que a comparação pode ser limitada ou até equivocada.- No cenário pós-singularidade descrito na Seção 4, a inteligência poderia emergir como uma rede sistêmica que inclui elementos humanos, animais e artificiais de forma difusa, tornando obsoleta a ideia de competir ou comparar um único agente com outro.

-

Instrumentalização vs. Autonomia:

Há, também, um debate sobre o caráter autônomo que a inteligência artificial deveria (ou não) ter. Modelos como GPT (sucesso em processamento de linguagem) ainda funcionam essencialmente como “ferramentas” estatísticas, sem intencionalidade clara, enquanto os proponentes do surgimento de superinteligências falam em agentes dotados de metas, objetivos e capacidade de decisão autônoma.- Essa discussão evidencia a divergência entre enxergar IA como um instrumento sofisticado que amplia a capacidade humana e vislumbrar IA como uma entidade quase viva, com “vontade” ou “propósitos” emergentes.

-

Destino Inexorável vs. Contingência Histórica:

Por fim, uma divergência-chave envolve a crença na inevitabilidade da singularidade ou da “explosão de inteligência”. Autores como Kurzweil argumentam que a evolução exponencial das tecnologias — computação, genômica, inteligência de dados — nos conduz inexoravelmente a esse desfecho. Porém, há quem enfatize que o progresso científico e tecnológico é contingente, depende de fatores econômicos, políticos, ecológicos e até de eventos históricos fortuitos (como guerras, colapsos, pandemias). Nesse sentido, a ultrainteligência pode nunca chegar, ou pode emergir em formatos completamente imprevistos e fora das projeções atuais.

6.3. Limites e Possibilidades de Conciliação

Dadas as convergências e divergências listadas, surge a pergunta: existe uma forma de conciliar essas visões numa síntese coerente? Talvez o primeiro passo seja reconhecer que o conceito de inteligência, mesmo em humanos, não é monolítico.

Como resultado, Inteligência Artificial também não deveria ser pensada como um alvo único. Há quem fale em IA “funcional” (aplicada a problemas específicos), IA “geral” (mais próxima da cognição humana) e, ainda, superinteligência (muito além de qualquer capacidade humana). Cada uma dessas categorias tem pressupostos diferentes, exigindo métodos de avaliação e estratégias de desenvolvimento distintas.

Em paralelo, é essencial manter diálogo entre áreas:

- Psicologia Cognitiva e Neurociência: podem iluminar aspectos sobre como o cérebro humano aprende, possibilitando aproximações que combinem redes neurais artificiais com teorias de sistemas cognitivos.

- Filosofia da Mente: questiona a própria natureza da consciência e dos estados mentais, levantando dúvidas sobre se “inteligência” necessariamente engloba ou não consciência, algo que entraria em jogo na hipótese de singularidade.

- Economia e Ciências Sociais: ajudam a entender como essas tecnologias se difundem e geram impactos sistêmicos, podendo, ou não, levar a transformações abruptas que se assemelhem a uma “explosão”.

- Ficção Científica e Estudos de Futuro: embora não sejam disciplinas acadêmicas clássicas, muitas vezes apontam cenários e dilemas que a pesquisa formal não explora até que as questões se tornem tangíveis.

6.4. A Importância de Reconhecer Nossas Lacunas

Apesar de todo o progresso, talvez a única certeza que temos seja que nossas definições e limites de “inteligência” estão em perpétua revisão.

Cada avanço em IA nos obriga a reexaminar os critérios que usamos para diferenciá-la de uma simples automação. Ao mesmo tempo, cada novo insight sobre o cérebro humano — ou sobre a complexa vida mental de certas espécies animais — expande nossa visão sobre o que pode ser considerado capacidade cognitiva.

Vinge, ao falar da singularidade, enfatizou que as “velhas regras” se tornam obsoletas após certas rupturas. Algo semelhante pode se passar com nossos próprios conceitos: num possível cenário de superinteligência, a taxonomia de “humano vs. IA” pode desaparecer, ou pode nascer um vocabulário completamente novo para descrever entidades e processos cognitivos que ultrapassam a imaginação atual.

Nesse sentido, há quem diga que a discussão sobre definições é apenas preliminar, pois, se atingirmos um certo patamar, tudo precisará ser redefinido. Outros, mais cautelosos, defendem que as definições são indispensáveis para evitar que sobrestime-se ou subestime-se o poder real das tecnologias que desenvolvemos. Ambas as posturas encontram embasamento teórico e prático: enquanto IA ainda é mensurável (benchmarks, testes, métricas), precisamos de rigor conceitual; mas, se projetamos futuros muito distantes, precisamos de abertura à possibilidade de conceitos inteiramente novos.

6.5. Caminhos para Além do Debate

Por ora, o mais provável é que avancemos de forma incremental, enxergando lampejos de IA cada vez mais polivalentes, mas ainda amarradas a grandes quantidades de dados e treinamentos específicos.

Contudo, isso não elimina o debate “exponencial” sobre autodesenvolvimento de máquinas, nem a urgência de pesquisas em AI Safety (segurança em IA) e AI Alignment (alinhamento de metas). Afinal, mesmo um aumento moderado das capacidades de decisão e autonomia dos sistemas computacionais traz à tona conflitos éticos e de governança.

Reconhecer as convergências e divergências nos conceitos de inteligência pode, portanto, servir de alicerce para a formulação de perguntas mais inteligentes sobre o futuro da IA. Perguntas como:

- Até que ponto um sistema precisa entender o mundo (e não apenas simular entendimentos) para ser considerado “inteligente”?

- Como avaliar o impacto real, social e político, de máquinas que aprendem e agem sozinhas?

- Em que medida a busca por uma “IA geral” ou “superinteligência” deveria ser condicionada por regulações internacionais, dado seu potencial de alterar estruturas econômicas ou mesmo a geopolítica global?

Enquanto tais questões permanecem em aberto, cabe a nós cultivar uma atitude de investigação contínua, ao mesmo tempo reflexiva e pragmática, para que o desenvolvimento da inteligência — natural ou artificial — se oriente por valores que enriqueçam a experiência humana (e a de outros seres vivos), em vez de conduzir a cenários de descontrole ou profunda desigualdade.

Assim, compreendendo melhor onde convergimos e onde divergimos acerca do que é, afinal, “inteligência”, estaremos mais preparados para lidar com as surpresas e paradoxos que, inevitavelmente, ainda surgirão.

7. Conclusões: O Futuro das Definições e o Papel da Humanidade

Chegamos ao final deste percurso, no qual passamos por múltiplas visões de inteligência — tanto humana quanto artificial — e exploramos cenários futuros que vão desde a consolidação de sistemas especializados até a especulação sobre superinteligências transcendentais.

Ao longo do texto, examinamos as ideias de Alan Turing, François Chollet, Vernor Vinge, I.J. Good, além de menções a pesquisadores e filósofos que moldam o debate contemporâneo. Vimos que, apesar da pluralidade de perspectivas, emergem algumas questões centrais que iluminam o futuro das definições e o papel da humanidade nesse contexto.

7.1. Por que Ainda Precisamos de Definições?

A cada passo do desenvolvimento tecnológico, revisitar e refinar nossas definições de inteligência e de inteligência artificial não é mera questão acadêmica: trata-se de balizar como e por que as sociedades investem, regulam e direcionam pesquisas e aplicações de IA.

- Planejamento e Estratégia: Em cenários corporativos ou governamentais, compreender as nuances entre “IA especializada” e “IA geral” permite alinhar expectativas e direcionar recursos. Uma visão mais clara do que se entende por “inteligência” evita o hype desenfreado e protege contra overselling de soluções tecnológicas pouco maduras.

- Regulação e Políticas Públicas: Para órgãos internacionais — como a OECD, a UNESCO ou o World Economic Forum —, a clareza de conceitos auxilia a formular diretrizes éticas e regulatórias. Se a lei e a governança não acompanham a velocidade do avanço tecnológico, corremos o risco de deixar lacunas ou brechas que podem amplificar desigualdades ou riscos de segurança.

Nesse sentido, as definições são elementos vitais de uma alfabetização tecnológica mais ampla, que capacita líderes, legisladores e cidadãos a enxergar o que realmente ocorre por trás dos algoritmos, em vez de sucumbir ao deslumbramento ou ao medo irracional.

7.2. Paradigmas Emergentes e Novos Rumos de Pesquisa

Apesar de Deep Learning ter dominado a cena na última década, há novos paradigmas que podem redefinir o conceito de inteligência em máquinas, como:

- Neurosymbolic AI: Uma tentativa de conciliar a força da aprendizagem profunda (redes neurais) com a expressividade e a lógica de sistemas simbólicos, buscando maior capacidade de raciocínio abstrato.

- Cognitive Architectures Inspiradas na Neurociência: Modelos que incorporam elementos de atenção, memória de trabalho, processamento hierárquico e até simulações de consciência parcial, visando aproximar o funcionamento de redes computacionais dos mecanismos cerebrais humanos.

- Self-Supervised Learning e Large Foundation Models: Além dos modelos linguísticos, cresce o interesse em arquiteturas que aprendam de vastos conjuntos de dados sem rótulos explícitos, descobrindo representações gerais úteis para diversas tarefas.

- Computação Quântica e Processamento Bioinspirado: Linhas de pesquisa que podem romper limites de escalabilidade e complexidade, oferecendo novos terrenos para a emergência de algoritmos mais adaptativos ou mesmo criativos.

O fio condutor em todos esses rumos é a busca por sistemas mais flexíveis, robustos e capazes de generalização. Esse impulso, por si só, já remete a aspectos levantados por Turing, Good, Vinge e Chollet, revelando que, apesar de estarmos longe de uma “superinteligência”, cada passo na direção de maior autonomia computacional reaviva as discussões sobre limites e possibilidades.

7.3. Legado e Persistência das Ideias de Vinge, Good e Turing

Ainda que se passem décadas desde as primeiras formulações sobre singularidade (Vinge) e “explosão de inteligência” (Good), seus pensamentos continuam a moldar a imaginação coletiva e a pesquisa acadêmica. O mundo assistiu, por exemplo, ao crescimento dos modelos transformadores em linguagem natural, que suscitaram perguntas sobre “consciência sintética” e “autoria” de conteúdos.

- Vinge e a Singularidade: Seu argumento permanece como um potente lembrete de que avanços exponenciais podem chegar a um ponto de ruptura — um “horizonte de eventos” tecnológico em que as extrapolações lineares já não se aplicam.

- Good e a Explosão de Inteligência: Cada nova aplicação de reinforcement learning, cada experimento em AutoML, reitera a possibilidade de sistemas que ajustem suas próprias estratégias e códigos, ainda que de forma incipiente.

- Turing e o “Caderno de Folhas em Branco”: A ênfase na aprendizagem e na flexibilidade remete à ideia de que um sistema pode começar com poucos “mecanismos inatos” e, ainda assim, escalar para competências surpreendentes — algo que os grandes modelos de linguagem de hoje exemplificam em parte.

Essas vozes do passado (e do presente) ajudam a manter acesa a chama da indagação científica e filosófica: qual é o verdadeiro escopo da inteligência? Até que ponto os algoritmos atuais — ou futuros — conseguirão aproximar-se da criatividade, da empatia e do senso de significado que associamos à mente humana?

7.4. Perspectivas Éticas e Sociais

Um ponto está em todo este texto, de maneira mais ou menos explícita, é a responsabilidade que acompanha o desenvolvimento de IA. Em linhas gerais, pode-se listar alguns desafios éticos e sociais:

- Desigualdade e Concentração de Poder: Grandes corporações e governos com acesso a recursos computacionais massivos podem acelerar investimentos em IA, distanciando-se de pequenos atores. Isso já aprofunda o fosso socioeconômico e tecnológico entre países e regiões.

- Substituição de Funções Humanas e Reestruturação do Trabalho: Embora o desenvolvimento de IA crie novas oportunidades, também ameaça postos de trabalho tradicionais, exigindo políticas de reconversão profissional e debates sobre renda básica universal ou mecanismos semelhantes.

- Algoritmos Opacos e Responsabilização: Modelos complexos, que se autotreinam em trilhões de parâmetros, podem ocultar processos decisórios pouco transparentes, gerando dilemas de responsabilização em casos de decisões prejudiciais ou discriminatórias.

- Ameaças Existenciais: Se avançássemos para uma IA de autodesenvolvimento recursivo, surgiriam riscos inéditos de descontrole, levantando a urgência de pesquisas de Alinhamento de IA e acordos internacionais que regulem a implementação e o uso de tais tecnologias.

Portanto, pensar o futuro da inteligência — e da IA — é, igualmente, pensar como garantir que esse futuro seja inclusivo, seguro e voltado para o bem comum, não refém de utopias ingênuas nem de distopias inevitáveis.

7.5. Além do Horizonte: Encarando o Desconhecido

Por mais que tentemos amarrar conceitos e projetar cenários, algo permanece inescapável: não temos todas as respostas e talvez nem tenhamos ainda as perguntas certas para capturar a totalidade do que está por vir.

singularidade tecnológica, a inteligência artificial geral, os ecossistemas cognitivos distribuídos ou mesmo a entidade transcendental descrita nos cenários especulativos podem se concretizar, ou serem sucedidos por outras inovações ainda fora do nosso radar.

Em paralelo, a complexidade do cérebro humano ainda guarda mistérios que a neurociência avança em desvendar, mas sem uma compreensão unificada. É possível que novas descobertas sobre plasticidade neural, consciência e cognição híbrida (homem-máquina) reformulem todo o quadro de IA.

Talvez descubramos que o salto rumo à superinteligência passe, inevitavelmente, pela fusão gradual do biológico com o digital, alterando de tal forma o que é “ser humano” que os atuais debates sobre “IA vs. humanidade” se tornem irrelevantes ou anacrônicos.

7.6. Fechando o Ciclo: A Inteligência como Espelho da Humanidade

No final das contas, as definições de inteligência, as visões sobre singularidade e explosão, e as ferramentas conceituais que usamos para mensurar o progresso da IA também refletem nossas próprias aspirações, medos e esperanças. Somos nós que, a cada etapa, estabelecemos o que consideramos valioso, criativo ou “superior”. Dessa forma, a história da IA é, em grande medida, uma história sobre como a humanidade enxerga a si mesma e suas potencialidades.

- Alan Turing, com sua analogia do “caderno de folhas em branco”, fala sobre a beleza de aprender e crescer — algo intrinsecamente humano, mas que pode se estender ao mundo das máquinas.

- I.J. Good, ao propor a intelligence explosion, projeta um futuro em que a engenhosidade humana dá lugar a uma engenhosidade artificial maior.

- Vernor Vinge, ao evocar a singularidade, enfatiza o nosso pavor — e também o fascínio — de um horizonte em que deixamos de ser a medida de todas as coisas.

- François Chollet, ao propor ARC, nos lembra que medir inteligência não é trivial e que, antes de celebrarmos uma suposta “consciência artificial”, precisamos verificar se ela de fato raciocina e compreende o mundo ou apenas manipula padrões.

Assim, ao concluir este longo texto, fica o convite a cada leitor para, por um lado, apreciar os inegáveis avanços das ciências da computação, da robótica e do aprendizado de máquina e, por outro, permanecer cético e vigilante quanto às promessas de uma “IA infalível” ou “onipotente”. Afinal, a inteligência — seja natural, seja artificial — não cessa de surpreender, mas também não se isenta de desafios, paradoxos e responsabilidades.

Em suma, a verdadeira questão que nos persegue não é apenas “O que é inteligência?”, mas também “O que queremos que ela seja — e para quê?”.

Se as máquinas podem ultrapassar a mente humana em inúmeros domínios, segue em aberto a forma como isso se inscreverá na história, na ética e na convivência global. Nesse sentido, o futuro da inteligência — em qualquer configuração que ela assuma — será também o futuro do humano, do animal, do ecológico, do planetário. Talvez a próxima página a ser escrita se configure como um diálogo inédito entre todas essas esferas, convidando-nos a colaborar na obra coletiva do conhecimento, em vez de apenas se submeter aos seus desígnios.

PS:

A íntegra deste texto foi escrita pelo autor, a partir da releitura do artigo “On the Measure of Intelligence” (referência abaixo) em menos de uma hora, com o concurso de inteligências artificiais em strateegia.digital, perplexity.ai, gemini, claude e vários assistentes em chatgpt.

Referências

Bengio, Yoshua.

“From System 1 Deep Learning to System 2 Deep Learning.” NeurIPS 2020 Workshop. 2020.

Bostrom, Nick.

Superintelligence: Paths, Dangers, Strategies. Oxford UP, 2014.

Chollet, François.

“On the Measure of Intelligence.” arXiv preprint arXiv:1911.01547, 2019. (link)

European Commission.

“The EU Artificial Intelligence Act.” …-2025. (link)

Gardner, Howard.

Frames of Mind: The Theory of Multiple Intelligences. Basic Books, 1983.

Good, Irving John.

“Speculations Concerning the First Ultraintelligent Machine.” Advances in Computers, vol. 6, 1965, pp. 31–88.

Hassabis, Demis, et al.

“Neuroscience-inspired artificial intelligence.” Neuron 95.2 (2017): 245-258. (link)

Krizhevsky, Alex, Ilya Sutskever, e Geoffrey E. Hinton.

“ImageNet Classification with Deep Convolutional Neural Networks.” Advances in Neural Information Processing Systems, 2012, pp. 1097–1105. (link)

Kurzweil, Ray.

The Singularity Is Near: When Humans Transcend Biology. Penguin Books, 2005.

Legg, Shane, e Marcus Hutter.

“Universal Intelligence: A Definition of Machine Intelligence.” Minds and Machines, vol. 17, no. 4, 2007, pp. 391–444.

Marcus, Gary, e Ernest Davis.

Rebooting AI: Building Artificial Intelligence We Can Trust. Vintage, 2019.

Mitchell, Melanie.

Artificial Intelligence: A Guide for Thinking Humans. Farrar, Straus and Giroux, 2019.

OECD.

OECD Principles on Artificial Intelligence. 2019.

Piaget, Jean.

The Origins of Intelligence in Children. International Universities Press, 1952.

Russell, Stuart.

Human Compatible: Artificial Intelligence and the Problem of Control. Viking, 2019.

Sternberg, Robert J.

Beyond IQ: A Triarchic Theory of Human Intelligence. Cambridge UP, 1985.

Turing, Alan M.

“Computing Machinery and Intelligence.” Mind, vol. 59, no. 236, 1950, pp. 433–460.

Vaswani, Ashish, et al.

“Attention Is All You Need.” arXiv preprint arXiv:1706.03762, 2017. (link)

Vinge, Vernor.

“The Coming Technological Singularity: How to Survive in the Post-Human Era.” Vision-21 Symposium, NASA Lewis Research Center and the Ohio Aerospace Institute, 1993.

World Economic Forum.

The Future of Jobs Report 2020. 2020.