os tres primeiros textos desta série descreveram alguns cenários, de guerra a futebol, onde há evidências consideráveis de que robôs terão uma participação no futuro. menos em futebol do que em guerra, talvez infelizmente. mais em trânsito do que na sala de aula, talvez felizmente. qualquer que seja o campo, toda discussão informal sobre robótica inteligente [inteligente mesmo, bem mais do que máquinas de solda em montadoras] passa pelas chamadas “leis” da robótica, primeiro formuladas por isaac asimov.

os tres primeiros textos desta série descreveram alguns cenários, de guerra a futebol, onde há evidências consideráveis de que robôs terão uma participação no futuro. menos em futebol do que em guerra, talvez infelizmente. mais em trânsito do que na sala de aula, talvez felizmente. qualquer que seja o campo, toda discussão informal sobre robótica inteligente [inteligente mesmo, bem mais do que máquinas de solda em montadoras] passa pelas chamadas “leis” da robótica, primeiro formuladas por isaac asimov.

asimov foi um dos mais prolíficos e sofisticados autores de ficção científica de todos os tempos. como parte de sua produção, há um grande número de textos que gira ao redor dos problemas práticos [e psicológicos] de robôs ideais, construídos para operar segundo regras românticas, as tais “três leis”, publicadas pela primeira vez em “run around“, de 1942.

as leis são muito simples, e representam uma certa hierarquia de valores [antropocêntricos]: 1ª lei: um robô não pode ferir um ser humano ou, por omissão, permitir que um ser humano sofra algum mal; 2ª lei: um robô deve obedecer as ordens que lhe sejam dadas por seres humanos, exceto nos casos em que tais ordens contrariem a primeira lei; 3ª lei: um robô deve proteger sua própria existência desde que tal proteção não entre em conflito com a primeira e segunda leis.

as leis são muito simples, e representam uma certa hierarquia de valores [antropocêntricos]: 1ª lei: um robô não pode ferir um ser humano ou, por omissão, permitir que um ser humano sofra algum mal; 2ª lei: um robô deve obedecer as ordens que lhe sejam dadas por seres humanos, exceto nos casos em que tais ordens contrariem a primeira lei; 3ª lei: um robô deve proteger sua própria existência desde que tal proteção não entre em conflito com a primeira e segunda leis.

as leis dizem que os robôs [ideais, ou “de asimov”] estão sujeitos às nossas vontades, desde que estas não impliquem em causar mal a outros humanos e que, garantidas estas condições, os robôs devem cuidar de sua própria subsistência. há um grande número de variações das leis, parte delas de autoria do próprio asimov, que tempos depois incluiu um lei “zero”, determinando que robôs não podem agir no interesse de humanos como indivíduos; devem agir no interesse de toda a humanidade. a idéia, aqui, era elevar o interesse coletivo acima do individual, tornando os robôs um bem universal e não um benefício pessoal para um ou outro humano.

porque tais leis podem ser consideradas ingênuas? porque alguém poderia construir um robô armado e… burro. o exemplo da torre de vigia robotizada que supostamente está sendo usada na fronteira entre as coréias é claro: trata-se de uma máquina de matar gente, que pode –ou não- ter humanos no processo de tomada de decisão. veja o caso desta máquina de paintball: no jogo, é mortífera. sem humanos no controle. somos simples e puros alvos. nada mais.

o primeiro e segundo texto desta série trataram cenários em que robôs autônomos podem ter a capacidade de eliminação de seres humanos [sem humanos para tomar a decisão…] e, pior, onde estas coisas podem fugir de nosso controle e passar a tomar decisões que estejam fora dos planos originais [por mais violentos que tenham sido] de seus construtores e donos.

na série, até agora, muitos comentaram que os engenheiros trabalhando em tais projetos deveriam procuram algo mais interessante para fazer, como minorar a fome do mundo. o comentário deve ser levado em conta, mas é primário e ingênuo. tecnologia é, quase sempre, o possível, agora. se for possível fazer robôs [armados] que vigiam lojas, casas, prédios, bases e fronteiras, eles serão feitos. e usados.

nosso problema é outro. assumindo que tais sistemas começam a aparecer, quais são as regras às quais eles, seus donos, projetistas e fabricantes deveriam estar sujeitos?… dentro de tais regras, quem é responsável pelo que, em que termos? se um bug no software de um robô levá-lo a atirar em alguém, de quem será a culpa? principalmente se o robô for completamente autônomo? se for, será que é possível impedir que uma máquina seja hackeada para se comportar de uma forma não prevista anteriormente? como? nesta discussão, temos que necessariamente descer ao ponto de discutir se um robô [autônomo] deveria ter “porte de arma” ou não.

neste contexto, que por sinal é o atual, as leis de asimov não servem para nada. as mudanças feitas no conjunto original de leis por roger clarke também não resolvem o caso, pois clarke continua assumindo [em seu texto de 1993/94] que os robôs são necessariamente “do bem”. não são. e olha que clarke tem uma lei que considera que robôs podem projetar e construir outros robôs…

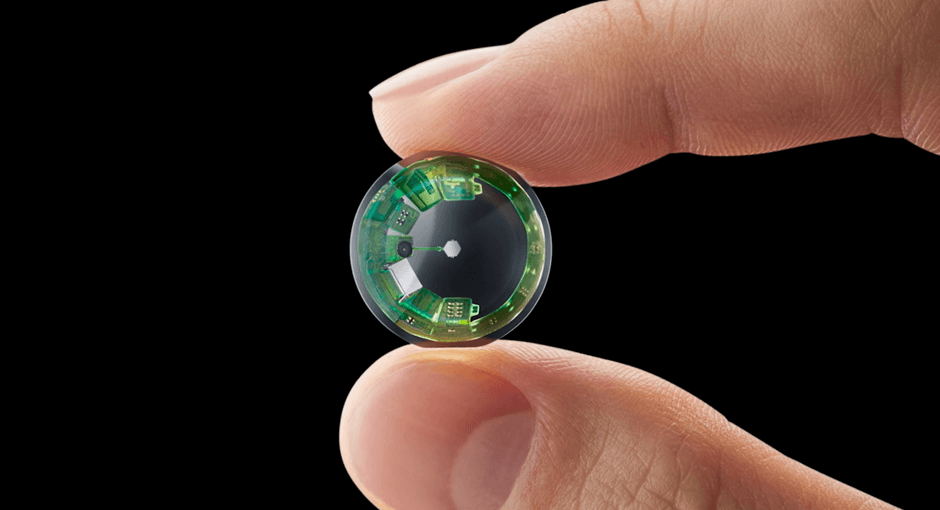

num artigo bem recente, yueh-hsuan weng, chien-hsun chen e chuen-tsai sun propuseram, no topo das “inteligências” que robôs muito sofisticados [autônomos, conscientes] poderiam vir a ter, uma inteligência de “segurança”, que tornaria tais máquinas seguras num ambiente majoritariamente humano e, claro, antropocêntrico [onde as prioridades, a ética, a moral, os meios e métodos… e tudo mais são estabelecidos ao redor de demandas e satisfação humanas].

de forma muito clara, os robôs que a toyota e muitos outros vão tentar vender para nossas casas hão de se guiar por regras parecidas com as de weng et al. os robôs da toyota são baseados em “harmonia com as pessoas” que, apesar de não garantir que tudo vai dar certo e nunca haverá um acidente fatal envolvendo um robô da marca, pelo menos nos dizem que a marca japonesa vai tentar, no limite da sua competência, cumprir a promessa.

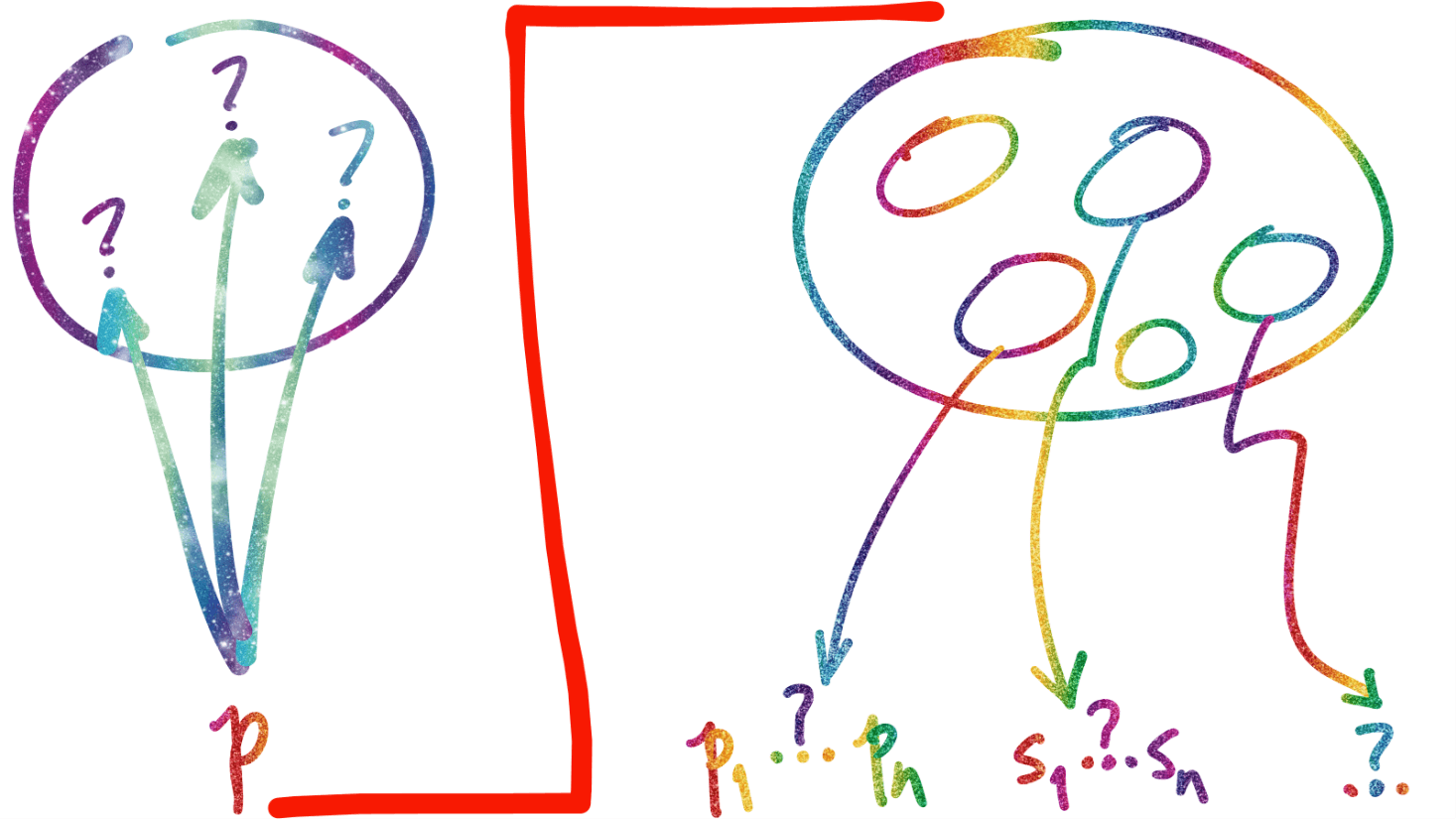

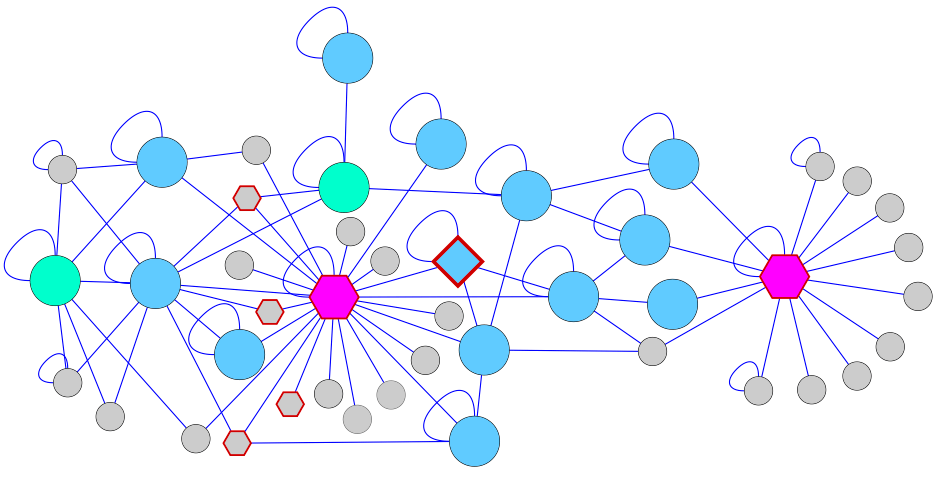

no lado oposto, há robôs sendo feitos para tratar humanos como alvo. sobre estes, é urgente impor regras como as de john canning, da marinha americana, que propõe que os robôs podem entrar em combate autônomo entre eles mas, quando o alvo for humano, têm que solicitar a ajuda de um humano para tomar a decisão de atirar ou não. um diagrama explicando o básico das regras de canning é mostrado a seguir.

a matriz de canning baliza o comportamento de robôs autônomos armados em situações onde haja pessoas e “coisas” [inclusive outros robôs]. se, no ambiente, só há coisas que são objetivos militares válidos, sinal verde e o pau canta, literalmente. se há pessoas e coisas que são objetivos válidos, os robôs devem mirar as coisas e pedir autorização superior para detonar as pessoas. em qualquer outra situação, os robôs não devem fazer nada, exceto se defender caso estejam sendo atacados.

não se sabe, ao certo, que conjunto de algortitmos implementariam tal capacidade de decisão e como eles seriam provados corretos na prática e em todas as situações.

tenho minhas dúvidas, face ao tamanho do esforço, se isso será possível algum dia. independentemente disso, sistemas robóticos armados continuarão sendo construídos de forma acelerada pelos países mais ricos, até porque diminuem o risco humano e político da guerra. mau sinal.

certo mesmo é que vamos enfrentar uma ampla discussão sobre ética robótica nas pr&´ximas décadas, inclusive porque poderemos, no médio prazo, construir máquinas capazes de raciocinar e tomar decisões de forma mais “esperta” [no sentido humano] do que nós próprios.

uma das atitudes subdesenvolvidas mais clássicas, em casos como este, é fingir que o assunto –de tão ameaçador ou complexo- não é conosco; dá-se uma de avestruz, a enfiar a minúscula cabeça na terra e deixar de fora e bem visível um traseiro –um alvo- centenas de vezes maior. nunca dá certo.

ao contrário, a associação americana de inteligência artificial encomendou a um painel de cientistas, mencionado no segundo texto desta série, um estudo sobre… expectations and uncertainties about the development of increasingly competent machine intelligences, including the prospect that computational systems will achieve “human-level” abilities along a variety of dimensions, or surpass human intelligence in a variety of ways.

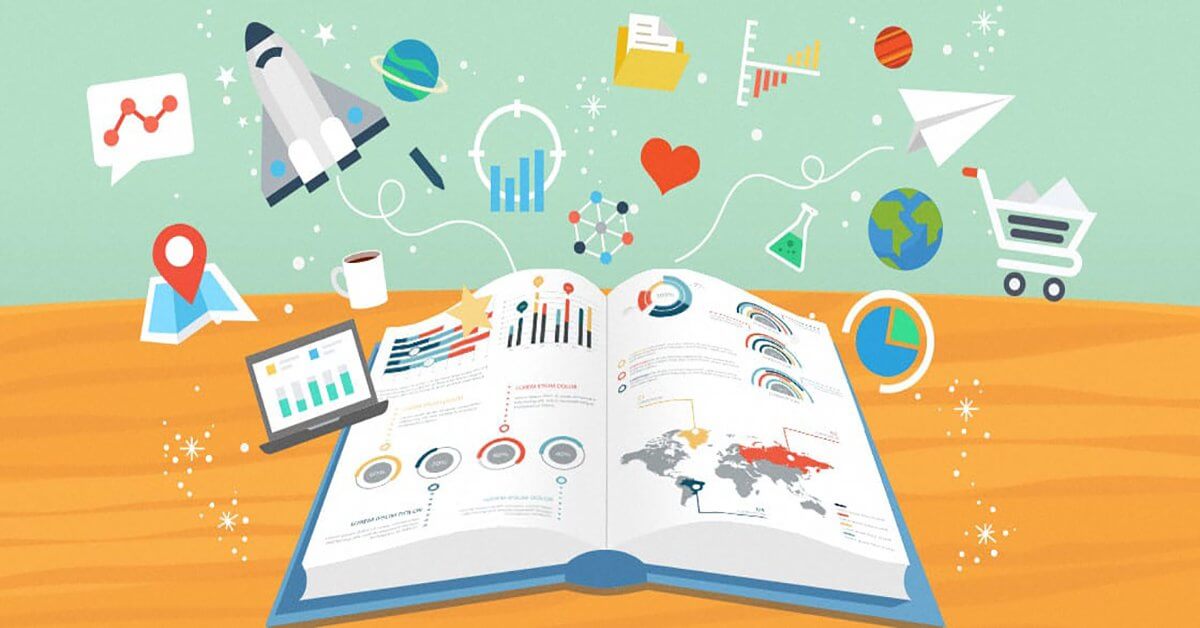

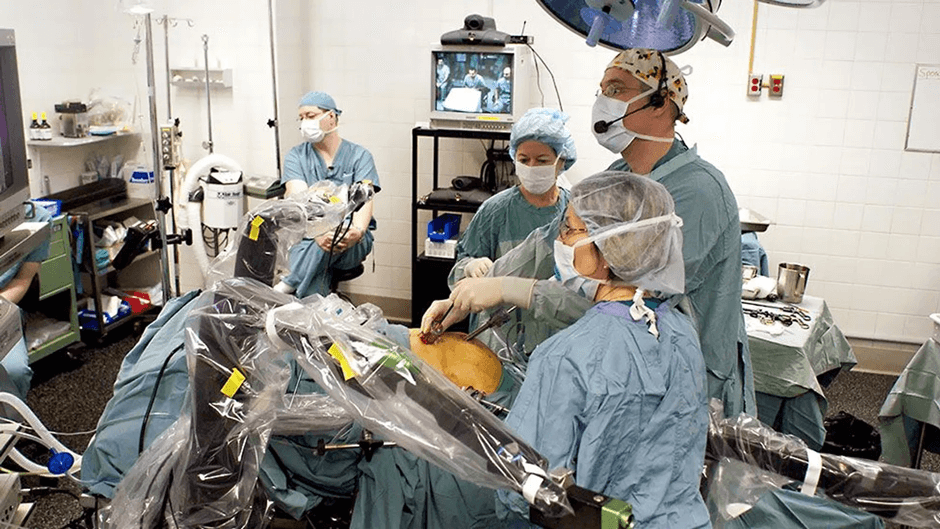

se existe a possibilidade de sistemas computacionais poderem, em futuro próximo, atingir níveis de performance igual ou superior aos humanos em um número de áreas, talvez se deva –todos nós, em todo o mundo- ajudar a escrever o livro de regras debaixo dos quais tais inteligências artificiais vão se comportar. na escola e na estrada, na casa e no escritório, na brincadeira, no hospital, no jogo, na guerra e na paz.

antes que elas próprias queiram escrever o livro de regras. talvez todas as regras.

[na figura acima, níveis de necessidade humanos {de acordo com maslow}, níveis correspondentes para um robô de pesquisa da nec e, abaixo, exemplo de atitude do robô quando seu nível de satisfação é baixo e ele realiza uma ação para aumentá-lo.]