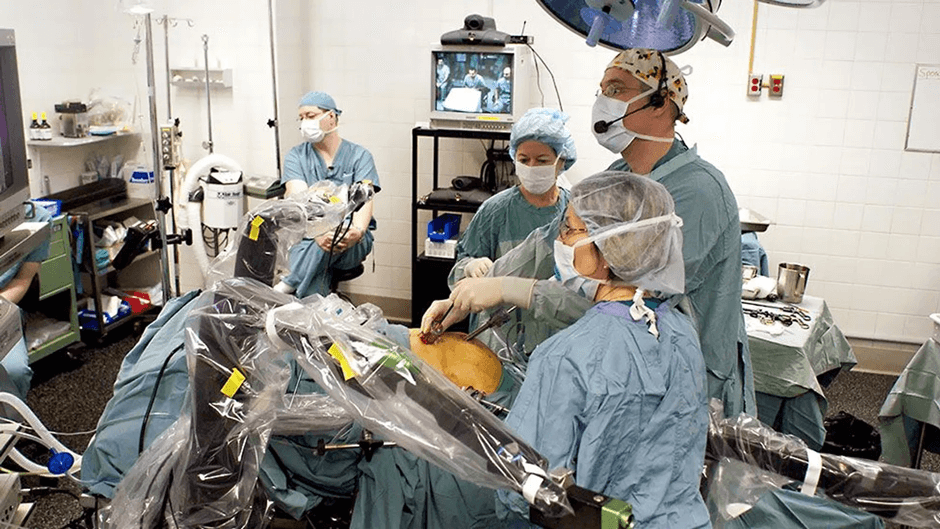

a capacidade de criar e escrever uma história era um dos traços que distinguiam humanos de outros seres, pelo menos se a gente se limitasse à terra. agora, e aqui, há mais agentes [senão “seres”] capazes de fazer a mesma coisa, como o software da narrative science, de chicago, que escreve milhares de notícias por dia, hoje, sobre partidas de de ligas esportivas amadoras dos EUA. mas pra programar –e não ser programado- e nem precisa ser um negócio com dezenas de cientistas e engenheiros de software como a narrative science, como mostra um gerador de notícias sobre terremotos escrito por um jornalista do los angeles times.

imagine o problema: o USGS detecta e publica, para a grande los angeles, que tem 13 milhões de habitantes, 2 terremotos de magnitude igual ou maior do que 1.5 por dia [média de 2013]; pra comparar, toda a américa do sul teve menos de 3 terremotos por dia no mesmo período. o USGS tem uma interface, na web, documentada, de onde se pode pegar dados sobre terremotos, à medida em são detectados, já organizados por magnitude e tempo de ocorrência. basta um pouco de bom senso [e não precisa ser senso jornalístico…] pra saber que não se deve dar atenção, lá em LA, a terremotos de intensidade menor do que 2, para os quais ninguém está nem aí. um 3, na escala richter, já dá um susto, 4 já da pra pensar que vai acontecer alguma coisa e, de 5 pra cima, coisas se movem.

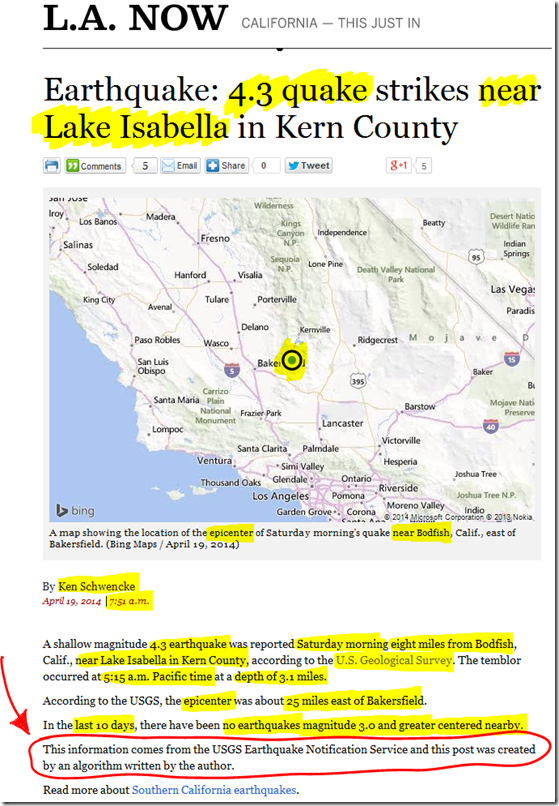

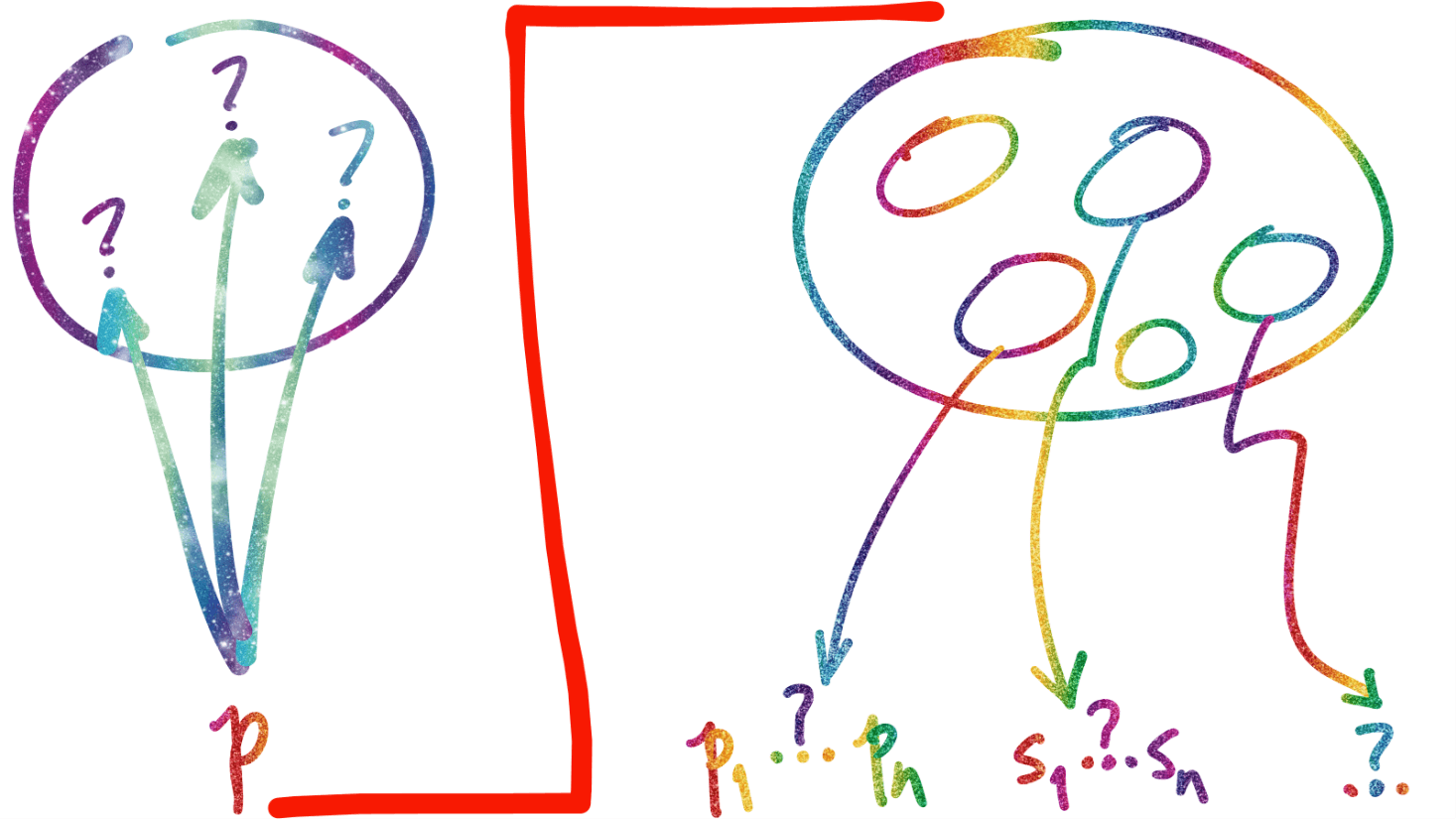

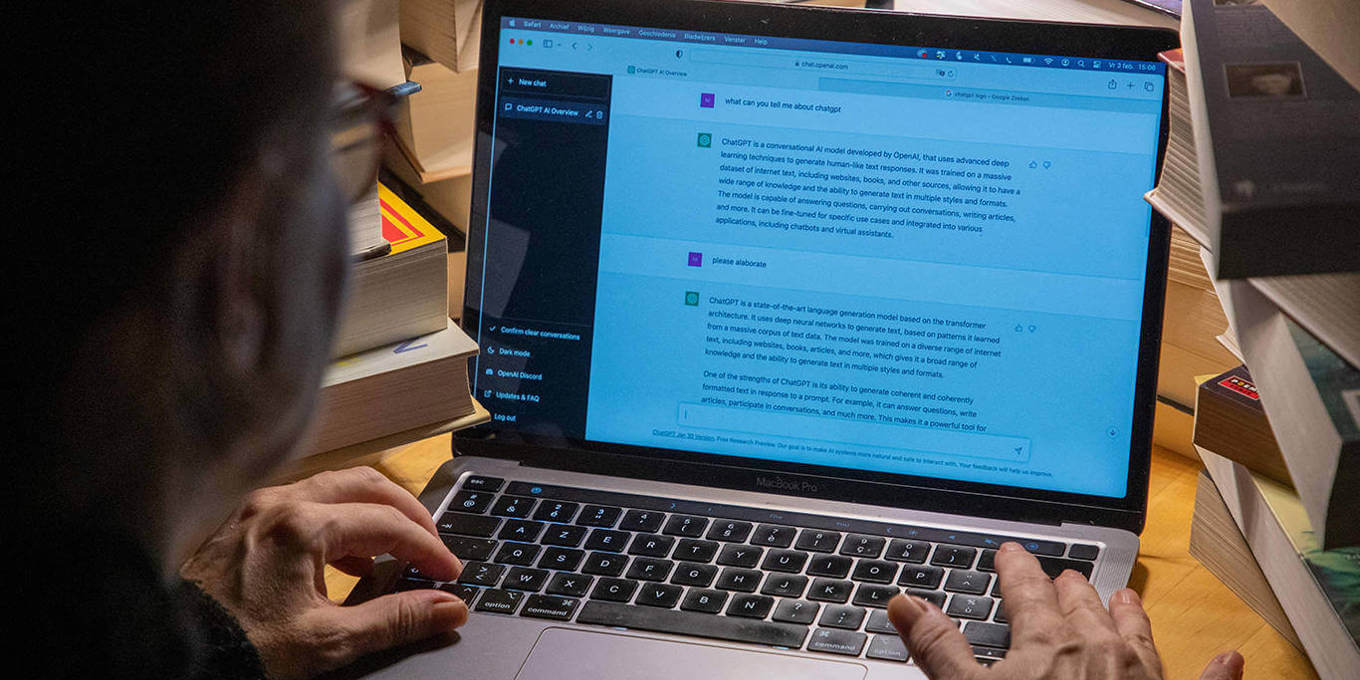

neste contexto, se você, como ken schwencke, tivesse o problema de relatar tantos terremotos, incluindo os de menor magnitude, que não têm impacto sobre pessoas e coisas e, como ele, soubesse programar, faria o que? schwencke foi atrás e criou um ótimo exemplo de data + programming based journalism, liberando o jornalista [criativo] dos fatos [apontados pelos dados] para procurar suas consequências e interpretações. o resultado pode se ver no fim deste texto, uma notícia de 19/04 sobre um terremoto 4.3 centrado em bodfish, CA. note que schwencke fecha a nota com uma sentença [circulada em vermelho] avisando que o texto foi escrito por um newsbot. o algoritmo de schwencke “espreita” novos eventos na interface de dados em tempo real do USGS e, ao “perceber” informação nova, usa decisões de “bom senso” [e “programadas” em alguma linguagem], para criar um “enredo” que conta a “história” que está “escondida” nos dados brutos publicados pela agência americana. simples assim. o algoritmo deve ter múltiplas estruturas de discurso e vocabulário para o mesmo tipo de notícia, pra não cansar o leitor. se não tiver, ainda, é muito fácil de inserir.

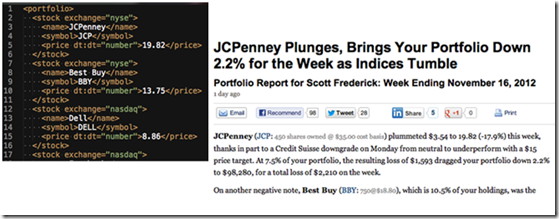

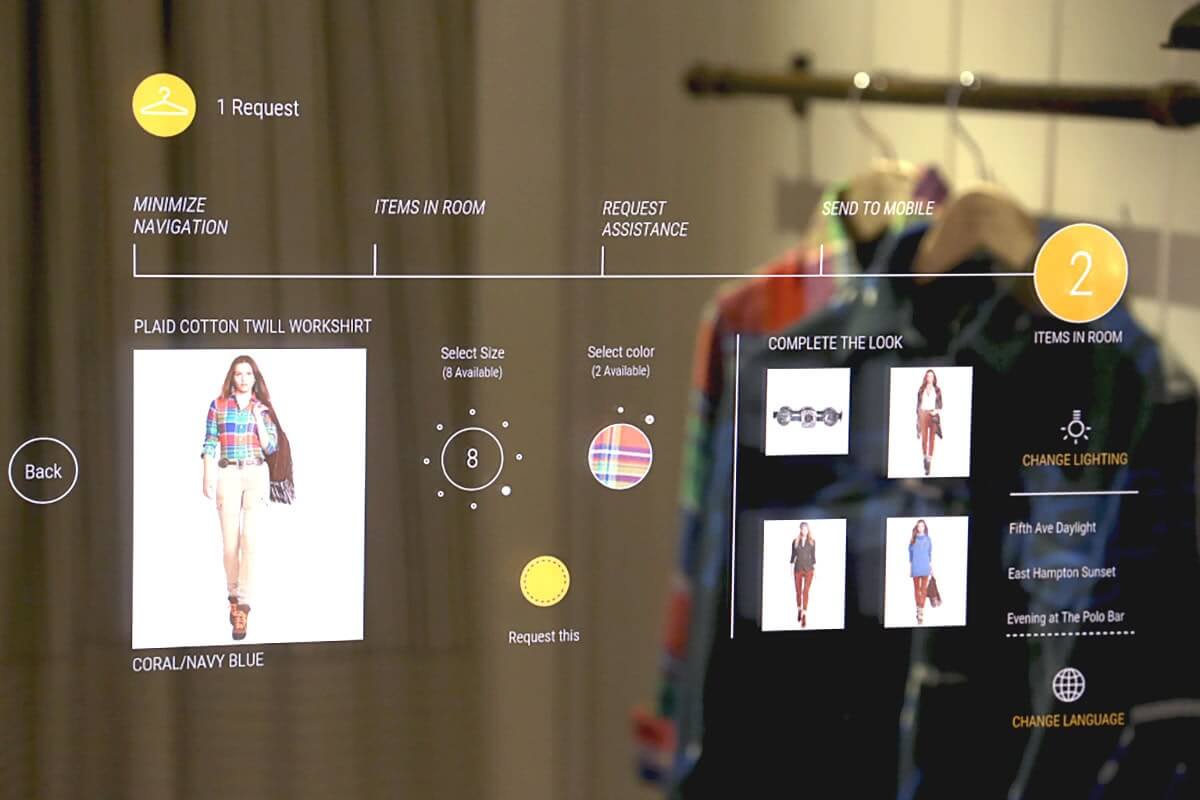

nada do que foi descrito acima é novidade. software para “escrever” como humanos existe há décadas e há algoritmos que já “escreveram” mais de um milhão de livros [todos publicados; veja a história do humano por trás deles aqui]. nem a narrative science, de quem já falamos, é única no mercado de criar histórias a partir de dados. mais de um bilhão de relatórios serão escritos pelo software da automated insights em 2014. coisa de gente grande, que parece com texto escrito por “gente”. o mostrado abaixo, um relatório de investimento que tem, à esquerda, dados como os que schwencke “pega” do USGS e, à direita, um relatório “automático” sobre os mesmos dados, é um dos muitos exemplos de aplicação de “escritores” virtuais.

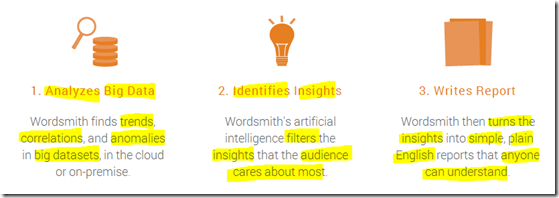

conceitualmente, o processo usado por sistemas como os da narrative e automated é similar; uns, como o da automated, conseguem minerar grandes volumes de dados para extrair informação “escondida” no palheiro digital e outros, como os da narrative, transformam dados brutos [e às vezes muito simples], em histórias que parecem contadas por humanos.

em uma das aplicações da narrative, os pais entram com os dados em seus smartphones e a narrative [aliás, o software, lá] escreve a história. há humanos no circuito? sim, claro; mas fazendo o trabalho verdadeiramente criativo de desenhar e escrever o software que escreve a história…

um estudo de 2013 que discutimos no texto deste link prevê que pelo menos 47% das profissões catalogadas nos EUA têm mais de 70% de probabilidade de não sobreviverem aos avanços tecnológicos [e consequências culturais…] das próximas décadas. e por próximas, aqui, entenda as próximas duas ou três. no caso dos EUA, há quem diga que os bebês de hoje nunca terão uma carteira de motorista [pois seus carros serão autônomos].

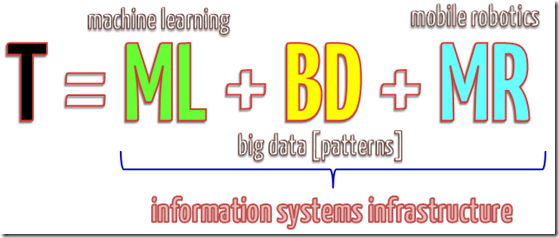

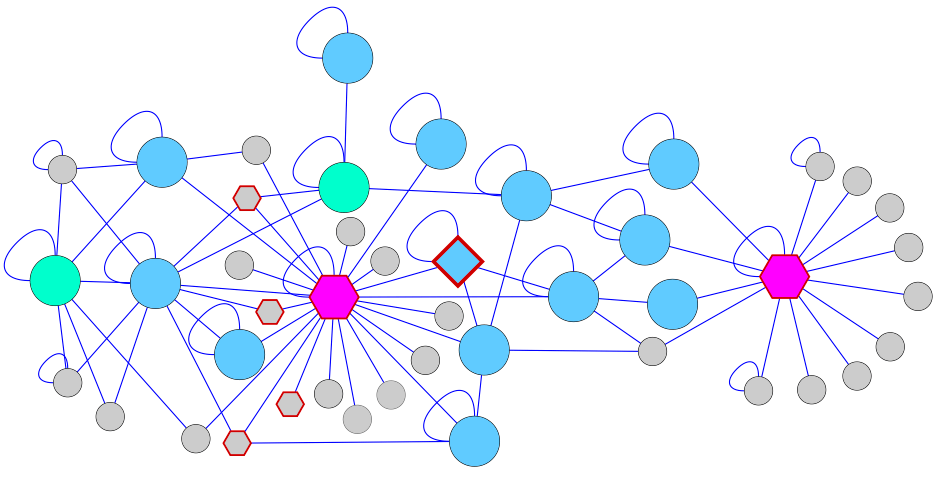

a evolução da inteligência artificial e aprendizado por máquinas [machine learning], grandes volumes de dados sobre comportamento humano nas mais variadas situações [parte do big data…] e a disponibilidade, cada vez maior, de robôs [inclusive móveis] cada mais sofisticados e mais baratos é o conjunto de forças que codifica e automatiza cada vez mais funções humanas, inclusive muitas que eram consideradas, até muito recentemente, trabalho criativo. se T, abaixo, é trabalho, boa parte de T vai ser automatizado, breve, e parte disso é trabalho criativo [ou pelo menos o que, hoje, é tratado como trabalho criativo].

o CEO da narrative science, kristian hammond acha que em 2030, 90% das notícias serão escritas por robôs. e que um robô [leia software] escreveria histórias com potencial de ganhar o principal prêmio do jornalismo global já em 2017. sei não. a lei de amara diz que o impacto de novas tecnologias tende a ser superestimado no curto prazo e subestimado no longo. e isso parece ser verdade neste caso. lá no trabalho sobre o futuro do trabalho, a probabilidade de automatizar o trabalho de escritores [de relatórios] técnicos é de 89%… e o autores de trabalhos originais é 4%. se você é o cara que cria textos verdadeiramente novos, a partir de análises e/ou construções inéditas, seu trabalho será criativo no futuro, mesmo em um futuro muito automatizado. se você escreve relatórios a partir de massas de dados, ou comenta estatísticas de esporte, economia, a partir de fórmulas estabelecidas e rotineiras… acho bom você procurar outra coisa pra fazer. agora, enquanto é tempo…

a história que você acabou de ler não foi, ainda, escrita por software. foi escrita com software, na rede, sem o que teria sido muito mais difícil de apurar e fazer. e teria saído com dias, meses, talvez, de atraso. a seguir, a tal história do terremoto, lá no LA times; não houvesse um aviso de que ela foi escrita por software, só quem estivesse procurando notícias escritas por computador [talvez] fosse capaz de tratá-la como tal. boa leitura.