“a rede é o computador”. a frase, dita por john gage no fim da década de 80, era uma promessa, lá. que confundia muita gente, por sinal. como é que a “rede”, algo que nem o pessoal de TICs entendia, ainda, substituiria os computadores? mas a frase apontava para uma visão que começou a se tornar realidade quando computação, aliada a comunicação, se tornou rede. e não podia ser rede fechada, de uma companhia. tinha que ser a rede global de e para todos [pelo menos em potencial], com protocolos abertos e acesso universal.

se fosse revisada para o cenário atual, 25 anos depois, a frase não mencionaria computadores, quase certamente. só a rede. porque é a rede, hoje, que importa. dita daqui a alguns anos, nem a rede iria aparecer, talvez. por que? porque o que importa, mesmo, são processos [de negócios] e porque as coisas duradouras não podem ser definidas em termos de tecnologias passageiras. não se deve confundir os fundamentos da computação com as possibilidades de realização a cada época. visto do tempo de LEO [veja o primeiro capítulo], o futuro teria computadores cada vez maiores e mais rápidos, mas isolados uns dos outros e do resto do mundo. a literatura de ficção científica da época [que costuma antecipar o futuro, sempre] e bem depois dela segue este caminho, com uma notável exceção.

em A Logic Named Joe, publicado em astounding science fiction de março de 1946, murray leinster descreve casas que têm logics, computadores pessoais com teclado e tela, ligados aos tanks, supercomputadores conectados entre eles, que armazenam o conhecimento do planeta [incluindo os programas de rádio e TV que já foram ao ar] e intermediam a comunicação entre os usuários das lógicas. acesso à informação, resolução de problemas, entretenimento, chats [tipo skype video…] e tudo mais rola nesta rede de tanques e lógicas, pra qual leinster previu vírus se espalhando e até um sistema de censura que previne o acesso de menores a material impróprio. PCs, internet e web, em 1946. e isso menos de um ano depois de arthur clarke propor satélites para comunicação terrestre, postos em órbita 20 anos depois. leinster nunca ganhou crédito por sua visão, talvez porque não tenha, como clarke, estabelecido os princípios por trás de suas ideias para PCs e redes, o que clarke fez para satélites em órbita geoestacionária. mas, de qualquer forma, trata-se de um feito, algo que clarke, asimov e outros não viram.

ao descrever a rede de tanques e lógicas, leinster estava falando de serviços, na e em rede, realizados por provedores para usuários. a palavra software não existia; seria impressa pela primeira vez em um artigo de john tukey em 1958. em 1946, JOE, a lógica do título, mudava quando seu hardware era modificado, como eram os computadores da época. a lei de amara explica: tendemos a superestimar o impacto das tecnologias no curto prazo e subestimar no longo. o resolvedor geral de problemas de JOE ainda não apareceu [e nem vai]. e hardware é commodity, pois pouco importa o hardware por trás do software, o que importa é o software e seus efeitos. aliás, hoje, hardware é serviço e software também. este é o cenário deste texto, partindo de LEO e chegando na nuvem, 60 anos em alguns parágrafos.

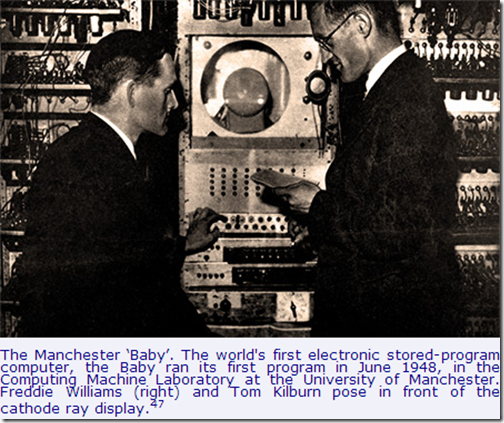

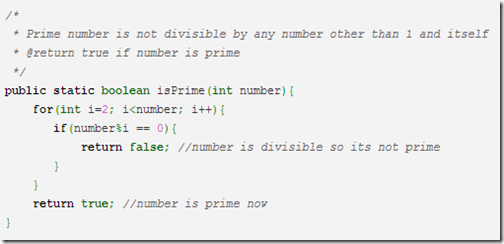

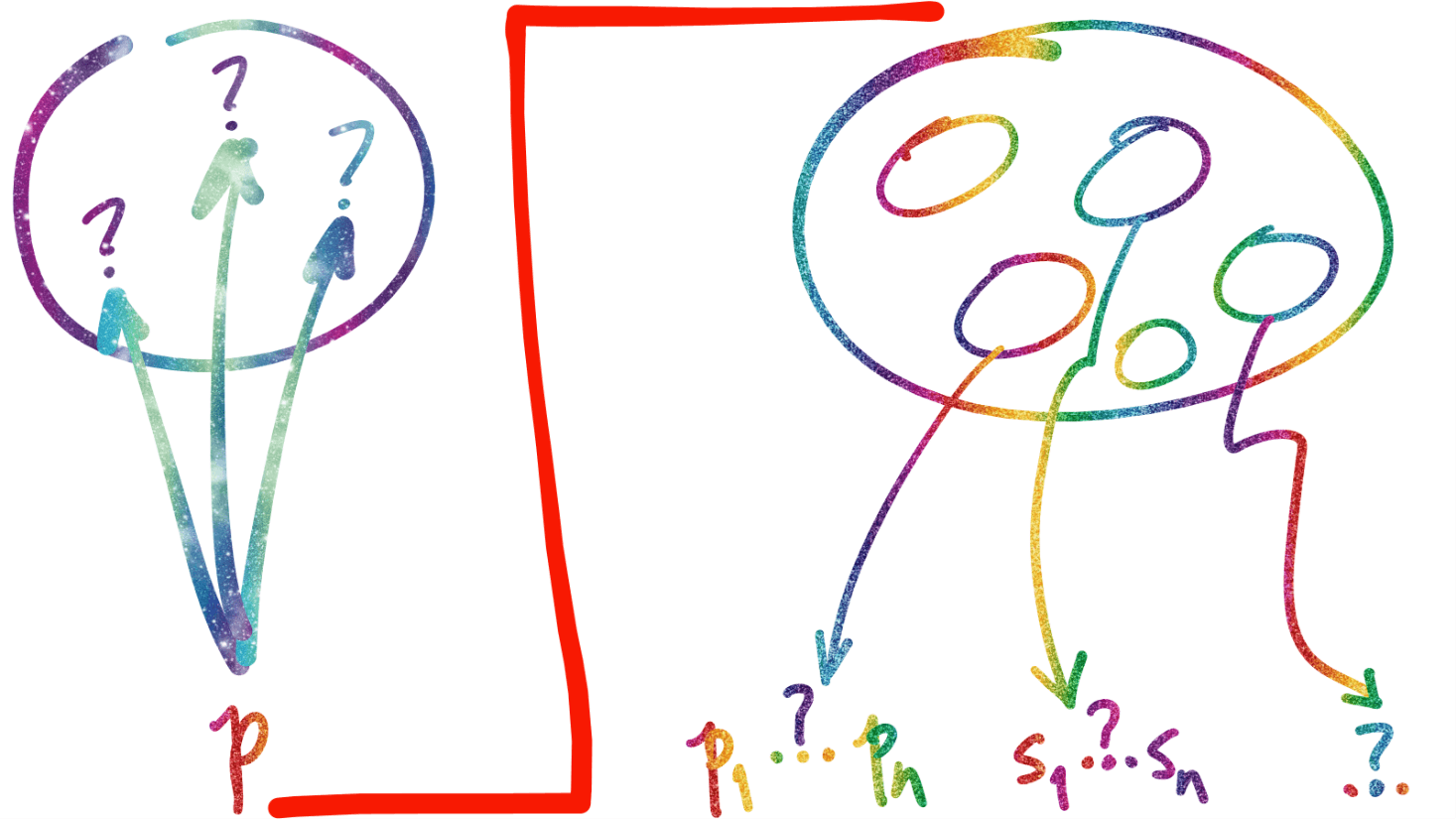

tecnologias da informação e comunicação [TICs] como entendidas hoje dependem de software desde o começo. o comportamento do hardware é controlado pelos programas armazenados na memória, conceito dos anos 3o, tornado prático em 1948, em manchester, UK, numa máquina chamada baby. daí em diante, era só comprar um computador e escrever as instruções que iriam informatizar o que se queria, de funções matemáticas a estoques de casas de chá. você está aqui e não é de computação? saiba que linguagens de programação contemporâneas servem para escrever instruções exatas, a serem seguidas por um hardware absolutamente determinístico, para computar procedimentos e funções como a mostrada abaixo, e transmitir e receber mensagens.

só que os fabricantes dos primeiros mainframes [os tanques da história de JOE], como IBM, ICL, UNIVAC…, tinham o costume de entregar o software básico e de implementação de funções essenciais para os negócios de graça a quem comprava o hardware. o último era o mercado, de circuitos, fontes e armários, o primeiro era entregue como algo marginal, mas usado para criar um efeito lock-in: quando se comprava um mainframe um fornecedor, você estava preso a ele quase para sempre. o mercado de software, portanto, quase não existia, apesar de haver uma ou outra empresa, aqui e ali, escrevendo software. estima-se que o faturamento de software era de apenas US$0.5B em 1969, menos de 4% do total da indústria de informática [veja neste texto de martin campbell-kelly]. o ano de 1969 marca a separação entre os mercados de hardware e software, pois a IBM, sob pressão do governo americano, é forçada a anunciar software e esforços de programação a preços públicos, abrindo o mercado e quadruplicando seu valor em uma década, e chegando a US$25B em 1985, 50 vezes o que era na época monopólio da IBM.

em 1985, caso você não se lembre, o software nacional operava milagres. depois de ter chegado a 92% em 1964 e caído para níveis civilizados [à época], abaixo de 50%, a inflação pegou ar a partir de 1979 [76%], passou de 100% [em 1981] e foi até 248.5% em 1985. a quantidade de regras novas no sistema financeiro, zeros a menos na moeda e troca da própria, o overnight, onde estava o dinheiro de todos os que tinham dinheiro, a indexação e dolarização, levaram o país ao caos e a vida dos programadores ao inferno. sob muitos aspectos, só foi possível rodar o país naquele tempo porque software e programadores, no sistema financeiro, foram capazes de acompanhar, quase em tempo real, as mudanças das especificações do país pelo governo, que quase toda semana fazia algo radicalmente novo, decretado quase sempre ao fim da sexta-feira, para que houvesse tempo de arrumar a casa, o software, para segunda na abertura dos bancos.

desde então, a competência do setor financeiro, em software, é citada como uma das provas de que o país sabe fazer sistemas complexos, críticos e sob pressão. e é verdade. mas os bancos tinham margens tão grandes, à época, que não importava o custo de verticalizar o desenvolvimento, tal seria feito. e foi. e, depois, contratar terceiros para desenvolvimento também se provou barato, alugando homens-hora implementar sistemas fechados, perdendo a oportunidade de criar o que poderia ter sido a indústria brasileira de software –essa sim, de classe mundial- financeiro.

a estratégia do setor financeiro foi adotada por boa parte dos outros mercados e por todas as facetas e níveis de governo, e nenhum dos grandes sistemas nacionais [gestão, impostos, eleições…] serviu de base para criar uma indústria de software de classe mundial. no caso do governo, as soluções podem ser de classe mundial, mas [via de regra] não chegaram ao mercado, local que fosse. ao responder porque a indústria de software dos EUA domina o mundo [procure 3 grandes provedores globais de software fora dos EUA…] campbell-kelly diz que os grandes desafios nacionais e encomendas estratégicas feitas à indústria, pelo estado, são duas das principais razões do sucesso americano. aqui, por outro lado, a completa ausência dos dois, aliado ao tratamento hostil dado à indústria, são razões essenciais para sermos basicamente irrelevantes no mercado internacional. será que isso poderia mudar, agora que a indústria de software está mudando? e quando a do grande hardware vira serviço e o pequeno, a informática-com-você, é uma commodity global, que só faz sentido fabricar onde se é competitivo para o mundo?…

pode mudar sim, todos sempre têm chances quando o mundo muda rápido, pois os gigantes, na maioria das vezes, não têm tempo, nem espaço ou energia, pra mudar. mas mudar pra onde, o que foi que aconteceu –e está acontecendo- que causa esta mudança tão grande, que cria novas oportunidades de competir?

resposta? informática em rede. aberta. como serviço. informaticidade.

antes da internet, o mercado de software tinha 3 facetas: pacotes para máquinas pessoais [como os da microsoft e adobe], pacotes para empresas [exemplos são os produtos da SAP e TOTVS] e os serviços, providos de fora para dentro da firma, por um fornecedor especializado, sobre uma rede dedicada [a EDS, em saúde]. as três facetas evoluíram de forma distinta, com pouca interação e, em muitos casos, por muito tempo, foram tratadas de forma desarticulada nas corporações. datada de 1970 [ou perto], a indústria viveu seus primeiros 25 anos fragmentada desse jeito. a chegada da internet comercial, ao fim deste primeiro quarto de século da indústria de software, mudou tudo: primeiro, juntou os provedores de soluções corporativas e pessoais na mesma arena, em rede e, ao mesmo tempo, trouxe aos dois a competição dos provedores de serviços, que passaram a poder ofertar seus serviços onde não tinham rede, ainda, porque agora havia –ou iria haver- redes globais, de todos para todos.

até aí, tudo bem… em tese. pois os fornecedores estabelecidos tinham clientes de longa data, cujas soluções necessitavam de manutenção e evolução enquanto a rede não se estabelecia pra valer [leia cobertura, velocidade e qualidade]. isso foi parte do contexto que possibilitou um sem número de novas empresas, propondo soluções inovadoras para velhos problemas do mercado. mas qual mercado, se os compradores, desconfiados dos novos serviços, seus provedores e da rede, em si, de sua confiabilidade [incluindo sua segurança…] não queriam as novas soluções? ou pelo menos não as queriam ainda… até não tinham rede de qualidade?…

levou um tempo até que as empresas, principalmente, começassem a entender que fazia sentido mudar a forma de aquisição de software, pois o fornecimento estava mudando. e o mercado de software não mudou de dentro para fora, das empresas para o mercado mas o contrário, de fora para dentro. tanto para [a maioria d]os fornecedores quanto para os compradores. se você lembrar, havia uma conta sua em gmail ou hotmail bem antes da sua empresa levar o emeio corporativo para a rede, como serviço. primeiro, os usuários individuais começaram a usar serviços gratuitos, pagos por terceiros em troca de nossos dados de navegação; depois, os provedores, tendo testado sua oferta por anos com os usuários finais [nós], sabiam exatamente o que e como vender para as empresas. aí, depois de muito tempo em modo beta, mediado pela internet, software estava virando serviço. e a internet é a principal causa da mudança radical nas estratégias corporativas de TICs. com os usuários experimentando as novidades lá… a mudança veio de fora pra dentro.

volte para o caso de emeio: dava para fazer a mesma mudança antes da internet? é claro que dava. mas a que custo? uma EDS, que já tinha infraestrutura a conectar milhares de hospitais, teria que estender sua rede para chegar milhões ou dezenas de milhões de pessoas, pra oferecer um serviço [gratuito] como parte da educação da comunidade, parte da qual iria querer a solução na empresa, por quem também já estaria, quase certamente, usando o serviço fora dela. há um mas, aqui: google, para prover gmail de graça, tem que cuidar “só” de sua infraestrutura própria [de hardware e software] e pagar sua conexão à rede. mas antes da internet a EDS [por exemplo] teria que instalar… uma internet. e isso inviabilizava tudo. por isso que a gente ouve falar de tanta coisa que, no passado distante, parecia com serviços que existem na internet, hoje, mas nunca foram feitas. é que sem rede, elas não eram possíveis, pois a conta para uma só empresa era muito alta, impossível de ser paga.

então, a rede redesenhou o mercado de software, pondo as empresas de software de massa [pacotes para os computadores pessoais], de pacotes corporativos e de serviços especializados no mesmo mercado. e fez mais: desceu para perto de zero o ticket de entrada de quem tinha uma boa ideia, capacidade de execução mas não tinha meios para distribuição global, que cada uma das três vertentes de mercado antes da rede tinha. de repente, era possível competir globalmente, a partir de um lugar qualquer do planeta. bem… não um lugar qualquer, mas um onde houvesse rede de muito boa qualidade e acesso a infraestrutura na qual rodar o software que iria ser entregue ao consumidor via rede, como serviço, sem que fosse necessário incorrer nos investimentos para adquirir o hardware em que o software iria rodar. ou seja… a infraestrutura ideal para prover software como serviço passou a ser o hardware [dos outros] como serviço. infraestrutura, pois, como serviç0.

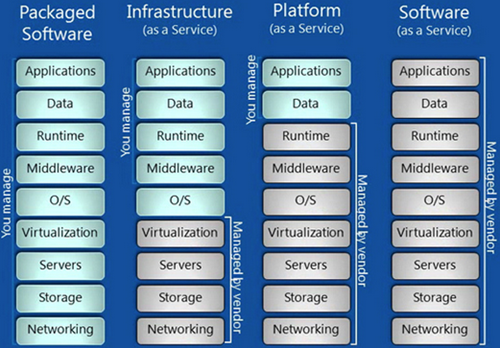

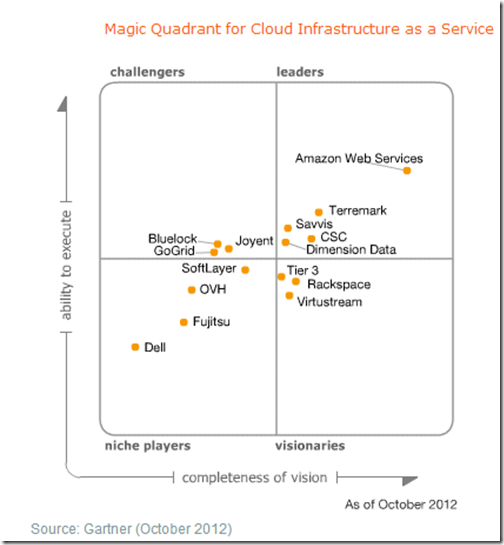

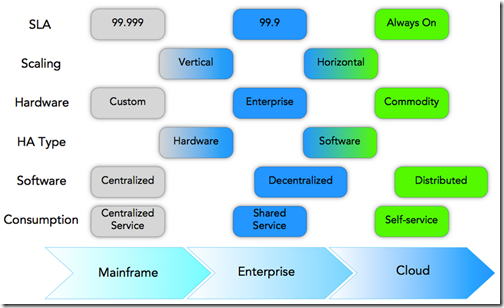

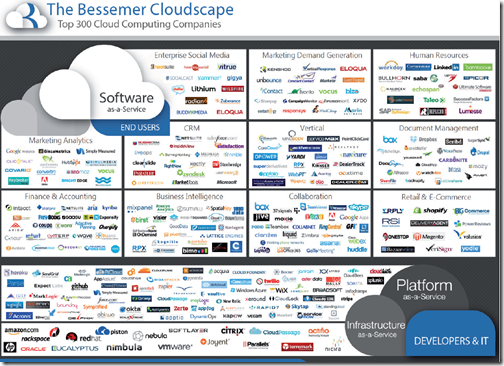

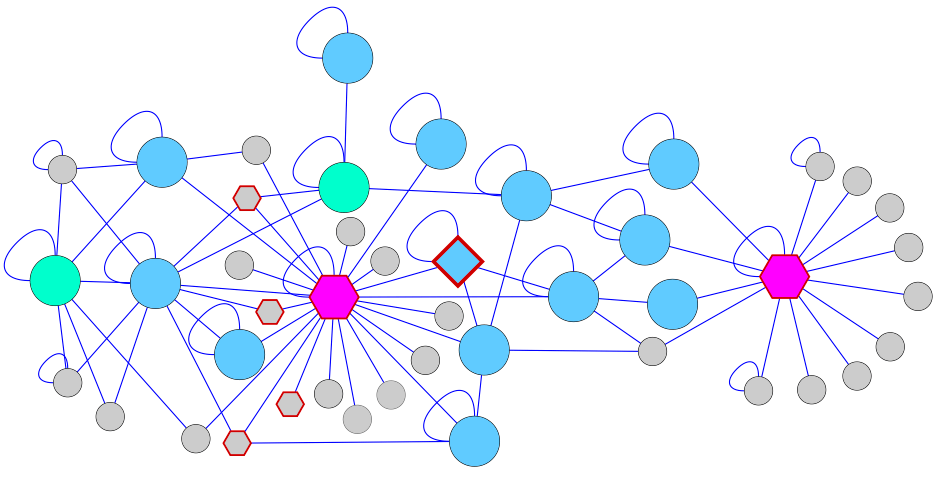

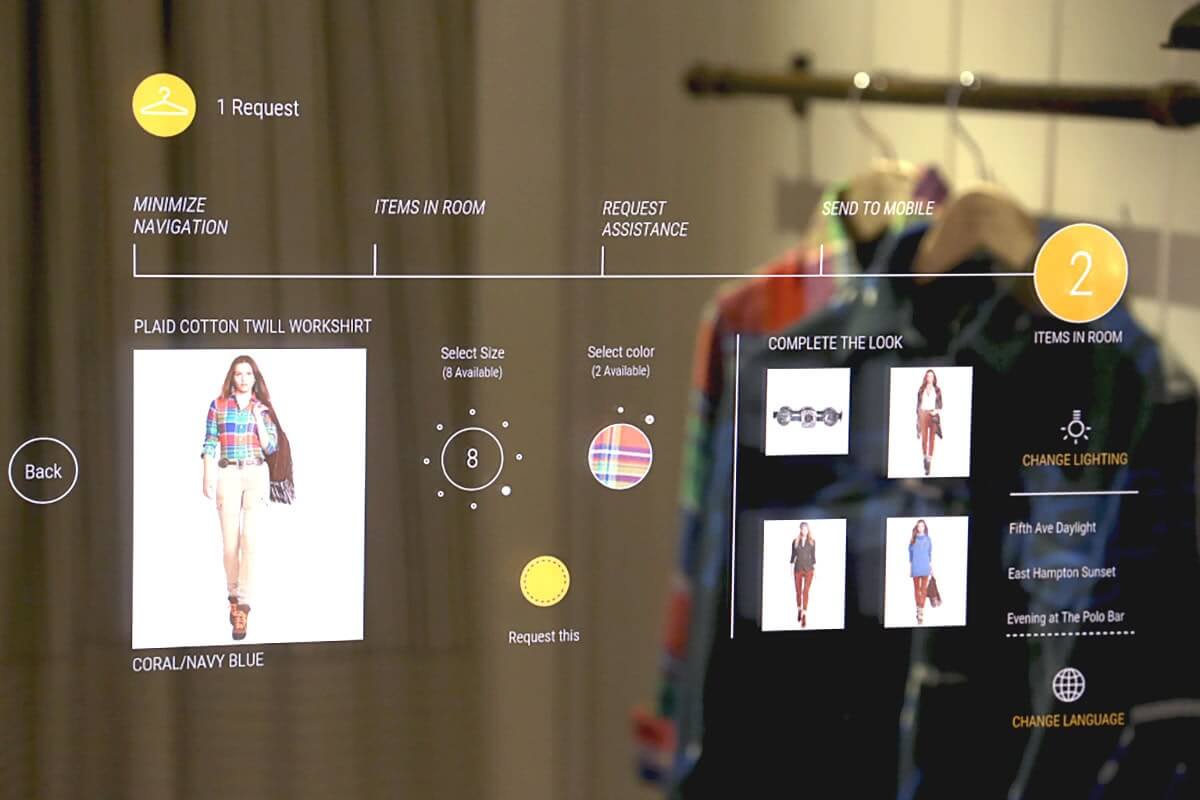

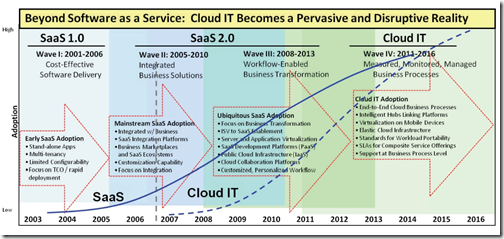

como é típico de TICs, onde nada existe sem uma sigla, a salesForce apareceu com o termo SaaS [software as a service] em 2005 e a savvis com HaaS [hardware as a service] em 2006, ao mesmo tempo em que a amazon começava a oferecer seus serviços de processamento [EC2] e armazenamento [S3] como serviço. e foi só no ano passado que a própria amazon transferiu seu site de comércio eletrônico para a combinação EC2+S3, o que nos dá uma boa ideia de como ainda há um longo e bom caminho para evolução do uso destas tecnologias nas empresas. a “nuvem” é nome e estágio contemporâneo, mas intermediário, na evolução da informática a partir de centros de processamento isolados, depois servindo sua própria rede de terminais, passando por servidores interconectados em múltiplos lugares, para os serviços que compartilham elementos essenciais e periféricos e servem pontos da rede dispersos por toda internet. a imagem abaixo [veja uma maior neste link] dá uma boa ideia de onde estamos e pra onde vamos no curto prazo.

antes de mais nada, é bom saber que a mudança de pacotes para serviços também é uma guinada nos modelos de negócios do setor de software [e hardware], assim como nos processos de aquisição e uso de software pelas empresas. primeiro, há um problema fundamental, de cultura: será que a [sua?] empresa está preparada para discutir quais são os elementos essenciais do seu modelo de negócio, aqueles que você têm que desenvolver em casa e ter domínio absoluto de seu ciclo de vida, ou então seu negócio correria riscos inadministráveis? que elementos são esses?… eletricidade, por exemplo? sim, se você estiver no negócio de transformação de bauxita em alumínio. não, se você for uma rede de farmácias. nos dois casos, os negócios não funcionam sem eletricidade. mas no alumínio ela passa de 1/3 do custo e o setor consome mais de 6% da capacidade de geração do país. pense. a farmácia tem que estar absolutamente tranquila com a energia da distribuidora e não saber quem é o gerador, sequer; a fábrica de alumínio não, está na briga até para mudar a política nacional de energia…

mudar de pacotes [pessoais ou corporativos] para serviços quer dizer pagar pelo que se usa [ou uma tarifa fixa por mês] e quem lhe fornece não precisa lhe vender nada todo mês… porque se você parar de pagar deixará de usar. simples assim, do ponto de vista conceitual, claro. sair de seu software, no seu hardware, instalado no seu CPD… para a web, com os serviços rodando você nem sabe onde e os dados sendo armazenados sabe-se lá como, dentro de que regime de segurança não é uma decisão fácil, no começo da história, pra ninguém. mas pode ser muito simples, se você olhar o problema dentro de um contexto apropriado.

que tal este contexto? há pelo menos um tipo de informação pessoal e corporativa que sempre esteve longe, sob cuidados nem sempre ideais de terceiros, e há muito tempo. e não é pouca coisa, trata-se de dinheiro, que não passa de informação sobre poder de compra, e que há tempos é [literalmente] depositada em um banco e tem todo o seu ciclo de vida gerenciado lá. se sempre foi assim para informação que, literalmente, é dinheiro, porque não poderia ser para os tipos de informação que… bem, não passam de informação?

claro que pode. mas havia mudanças radicais a fazer, antes que assim o fosse. já se disse que o mercado de software pré-rede era de massa [software para seu PC], de pacotes corporativos [para empresas, óbvio] e de serviços de terceiros, em redes próprias. em rede, passamos a ter um só mercado, de infraestruturas, serviços e aplicações, que sustentam o ciclo de vida de informação das pessoas e negócios. a infraestrutura do mercado de informática contemporâneo está nos data centers globais, os serviços são providos por software que está rodando nestes e, por fim, as aplicações servem as pessoas, como indivíduos ou colaboradores das empresas, nas appliances [ATMs, PDVs, POSs, PCs, laptops, tablets, smartphones] que cada um usa. os serviços de software, em rede, têm status parecido com eletricidade ou água, coisas que não podem ser desligadas, não podem falhar, estão always on.

nunca foi óbvio descrever o que era uma empresa de software. de entender, então, nem pensar. agora, as “empresas de software” ainda fazem software, no sentido de escrever programas, mas suas receitas se originam, cada vez mais, da informação processada pelo software. em muitos sentido, não é fácil distinguir as empresas de software [em rede, como serviço] de bancos: armazenam e processam informação crucial para seus clientes e são remuneradas por isso. quem dera a remuneração fosse da mesma ordem do setor financeiro, mas essa é outra história.

agora vamos transpor esta discussão para informática e para o papel de um agente bem especial na empresa: quem é, e o que deveria fazer o CIO, o chief information officer, o cara cujo nome diz que ele é o responsável pela informação no negócio, quando ele deixa de se preocupar com as tecnologias de suporte ao ciclo de vida de informação e passa a se preocupar com o negócio propriamente dito?… será que a promessa das tecnologias de informação abertas [open IT], da nuvem e do software, nela, como serviço vão, enfim, deixar o nosso herói se concentrar nas demandas de informação para diferenciação e competitividade do seu negócio? pois é aí mesmo que vai começar o terceiro capítulo de nossa saga. até lá.